报告主题: Epistemic reasoning in AI

简介:

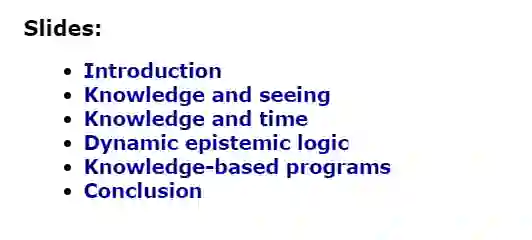

在多智能体系统中,智能体应该能够解释它们的决策。事实上,在失败的情况下,智能体需要以一种可以理解的方式为它们的决定辩护,特别是要遵守最近的法律(如欧洲的GDPR)。此外,它们需要做出有意义的决定来与它他智能体合作,比如人类。为了实现这一目标,智能体应该模拟人的心理状态。例如,如果机器人认为人类需要某个物体而不知道它的位置,那么它可以将该物体的位置告知人类。在本教程中,我们将介绍关于知识/信念的推理的最新进展。它由教学工具Hintikka来展示,该工具通过连环画的方式描绘人的心理状态,并以游戏等多种简单的多智能体系统为特色。我们将讨论几个正式的工具建模如下:

- 通过观察/感知环境/其它智能体获得的知识;

- 知识的时间方面

- 复杂的认知行为(公共/私人公告等)

- 不完全信息下的战略推理

- 以知识为基础的项目

邀请嘉宾:

Tristan Charrier教授是INRIA/IRISA(法国雷恩)的研究员,目前是临时助理教授。主要兴趣是应用于人工智能的逻辑/形式方法、符号模型、认知规划、指定认知情境的语言、认知推理的论证。

François Schwarzentruber是法国雷恩大学的副教授。他目前的研究兴趣主要集中在逻辑理论和人工智能、代理和多代理系统以及计算机科学中的应用。他是AAMAS和IJCAI等专题的PC版成员。曾任Synthese、Studia Logica、Theoretical Computer Science等期刊的审稿人。2011年以来,主要研究动态认知逻辑。

成为VIP会员查看完整内容

相关内容

François Schwarzentruber是法国雷恩(ENS Rennes)副教授。 他目前的研究兴趣主要集中在逻辑理论及其在人工智能,代理和多代理系统以及计算机科学中的应用。 他曾是Synthese,Studia Logica和Theoretical Computer Science等期刊的审稿人。 自2011年以来,他的研究主要致力于研究动态认知逻辑。

专知会员服务

46+阅读 · 2020年1月11日

专知会员服务

46+阅读 · 2019年8月10日