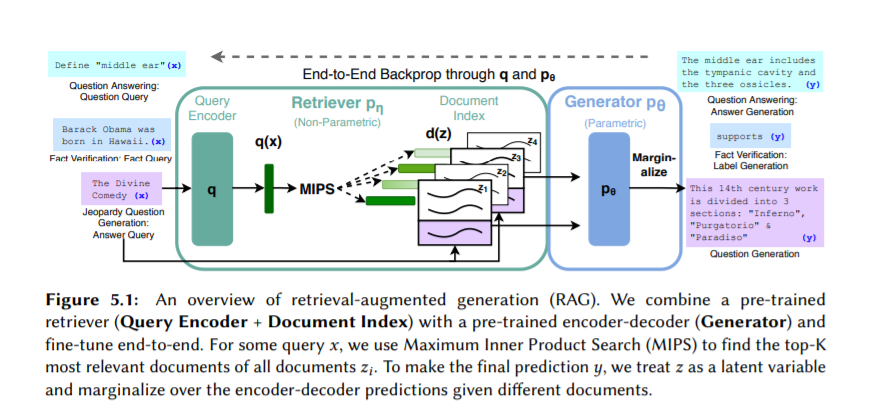

自然语言处理(NLP)有望为各种有影响力的应用提供工具,从自动摘要到问答系统和会话助手。最近,由于预训练语言模型的出现,NLP已经发生了革命性的变化。Radford et al. 2018a, 2019;Devlin et al. 2019;Brown等人,2020]。我们使用“自监督”的学习目标来训练PLM——只对无标签文本进行预测任务,比如下一个单词预测或缺词预测。因此,PLM能够从大量的互联网文本中学习,在许多NLP任务中获得强大的性能。尽管自监督的目标取得了成功,但它们面临着一个根本的限制:它们训练PLM以与人类偏好不一致的方式行事。PLM学会重复互联网上的错误信息、攻击性笑话和个人联系信息,很难控制或引导PLM生成的文本。接下来,我们展示了基于PLM的分类器在预测人们喜欢的文本方面是有效的。因此,有可能使用这样的分类器作为一个学习信号来自动校正PLM。我们展示了这种方法来训练高质量的检索系统,使用检索增强生成(RAG)在各种任务中获得强大的性能。即使在这样的训练之后,一些不良行为也可能在训练过程中未被发现。因此,我们更进一步,通过使用其他PLM,从PLM中产生一些诱发不良行为的输入,从而预先地发现并修复这些行为。总的来说,我们发现,让PLM与人类偏好保持一致的一些最强大的工具是PLM本身。

成为VIP会员查看完整内容

相关内容

Arxiv

31+阅读 · 2021年11月1日

Arxiv

24+阅读 · 2021年8月12日