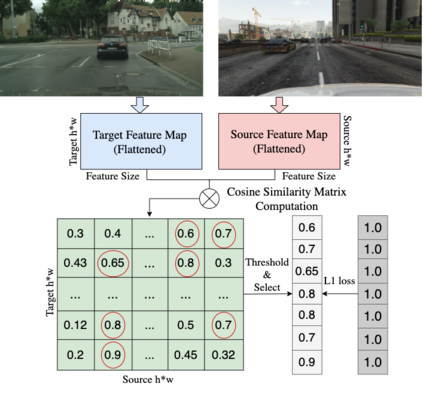

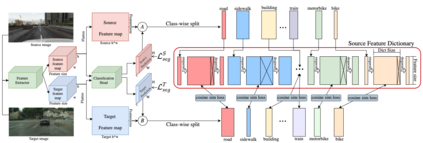

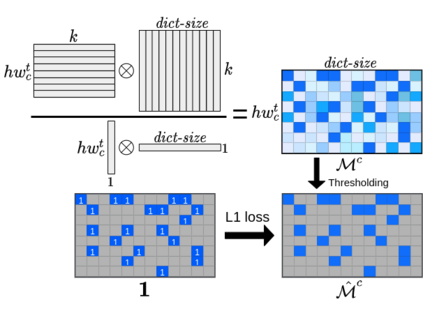

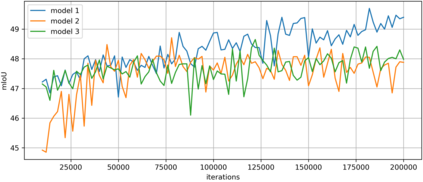

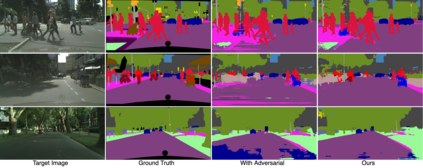

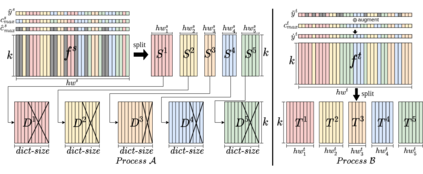

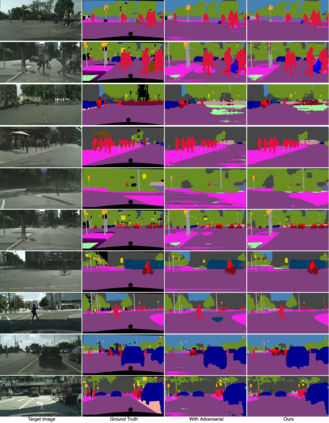

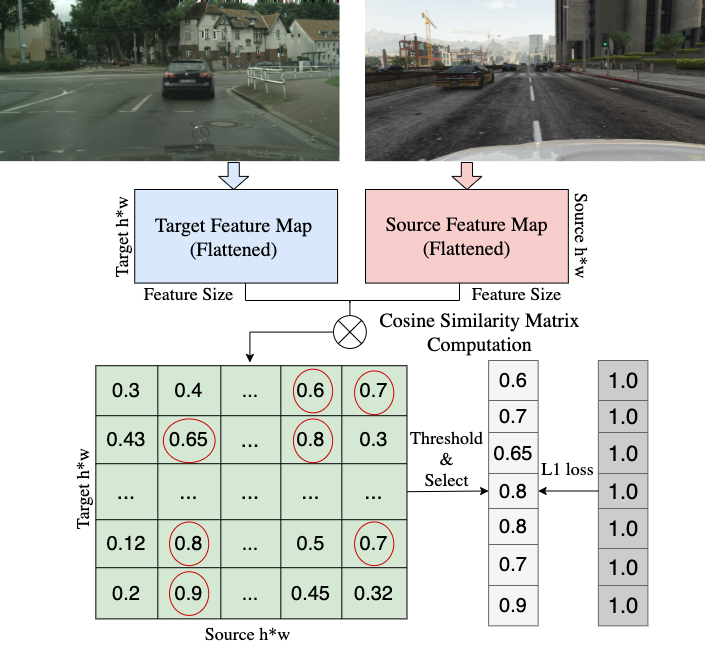

We propose a novel method that tackles the problem of unsupervised domain adaptation for semantic segmentation by maximizing the cosine similarity between the source and the target domain at the feature level. A segmentation network mainly consists of two parts, a feature extractor and a classification head. We expect that if we can make the two domains have small domain gap at the feature level, they would also have small domain discrepancy at the classification head. Our method computes a cosine similarity matrix between the source feature map and the target feature map, then we maximize the elements exceeding a threshold to guide the target features to have high similarity with the most similar source feature. Moreover, we use a class-wise source feature dictionary which stores the latest features of the source domain to prevent the unmatching problem when computing the cosine similarity matrix and be able to compare a target feature with various source features from various images. Through extensive experiments, we verify that our method gains performance on two unsupervised domain adaptation tasks (GTA5$\to$ Cityscaspes and SYNTHIA$\to$ Cityscapes).

翻译:我们建议一种新颖的方法,通过在特性水平上最大限度地实现源和目标域的相似性,解决未受监督域适应语义分割的问题。 分解网络主要由两个部分组成, 一个特征提取器和一个分类头。 我们期望, 如果我们能够使这两个域在特性水平上存在小的域间差距, 它们在分类头上也会有小的域间差异。 我们的方法计算出源特征地图和目标特征地图之间的相近性矩阵, 然后我们尽量扩大超过阈值的元素, 以引导目标特性与最相似来源特征高度相似。 此外, 我们使用一种分类源特性词典, 储存源域的最新特征, 以防止在计算相近特性矩阵时出现不匹配的问题, 并能够将目标特性与各种图像的来源特征进行比较。 我们通过广泛的实验, 核实我们的方法在两个未超过范围的调控域调任务上取得了绩效( GTA5$\ to $ Cityscapes and SYNTHHIA$\\totoscapeat )。