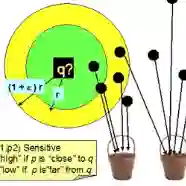

Among many solutions to the high-dimensional approximate nearest neighbor (ANN) search problem, locality sensitive hashing (LSH) is known for its sub-linear query time and robust theoretical guarantee on query accuracy. Traditional LSH methods can generate a small number of candidates quickly from hash tables but suffer from large index sizes and hash boundary problems. Recent studies to address these issues often incur extra overhead to identify eligible candidates or remove false positives, making query time no longer sub-linear. To address this dilemma, in this paper we propose a novel LSH scheme called DB-LSH which supports efficient ANN search for large high-dimensional datasets. It organizes the projected spaces with multi-dimensional indexes rather than using fixed-width hash buckets. Our approach can significantly reduce the space cost as by avoiding the need to maintain many hash tables for different bucket sizes. During the query phase of DB-LSH, a small number of high-quality candidates can be generated efficiently by dynamically constructing query-based hypercubic buckets with the required widths through index-based window queries. For a dataset of $n$ $d$-dimensional points with approximation ratio $c$, our rigorous theoretical analysis shows that DB-LSH achieves a smaller query cost ${O(n^{\rho^*} d\log n)}$, where ${\rho^*}$ is bounded by ${1/c^{\alpha}}$ while the bound is ${1/c}$ in the existing work. An extensive range of experiments on real-world data demonstrates the superiority of DB-LSH over state-of-the-art methods on both efficiency and accuracy.

翻译:高维近邻(ANN)搜索问题的许多解决方案中,地方敏感散列(LSH)以其亚线性查询时间和对查询准确性的严谨理论保证而著称。传统的LSH方法可以快速从散列表格中产生少量候选人,但会遇到巨大的指数大小和散列边界问题。最近为解决这些问题进行的研究往往需要额外的间接费用来识别符合资格的候选人或消除虚假的正数,使查询时间不再是子线性。为了解决这一难题,我们在本文件中提议了一个名为DSH的新LSH(DB-LSH)计划,它支持高效的高维度数据集搜索。它用多维指数而不是使用固定维度的黑桶来组织预测空间。我们的方法可以大大减少空间成本成本成本成本,在DB-LS的查询阶段中,少数高质量的候选人可以通过动态地建基于查询的超宽度高空基桶(DB_$$美元) 来显示以多维度指数标值的空域空间,同时用高基的基数据分析以美元($xxxxxxxxxx) 。