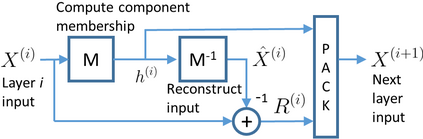

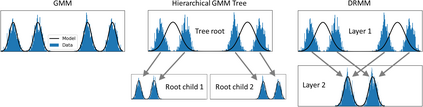

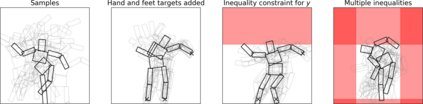

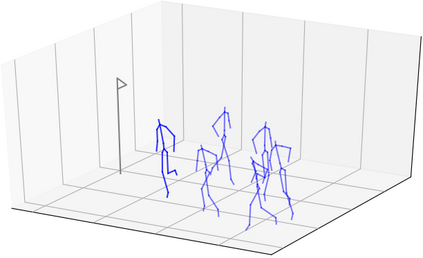

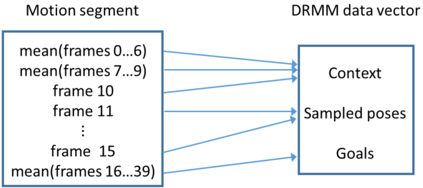

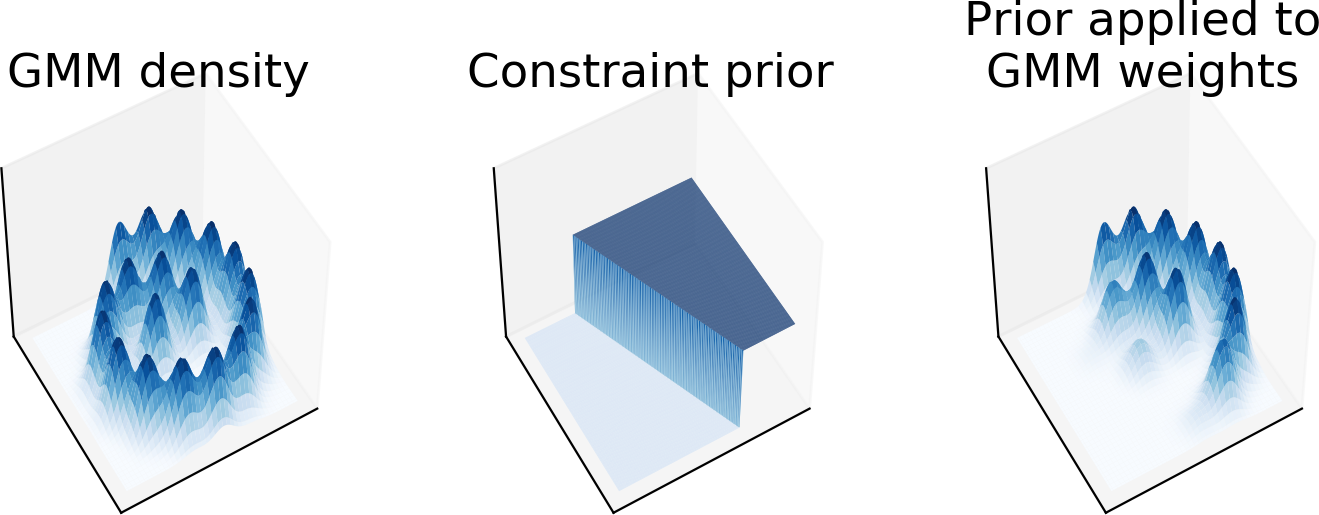

We propose Deep Residual Mixture Models (DRMMs), a novel deep generative model architecture. Compared to other deep models, DRMMs allow more flexible conditional sampling: The model can be trained once with all variables, and then used for sampling with arbitrary combinations of conditioning variables, Gaussian priors, and (in)equality constraints. This provides new opportunities for interactive and exploratory machine learning, where one should minimize the user waiting for retraining a model. We demonstrate DRMMs in constrained multi-limb inverse kinematics and controllable generation of animations.

翻译:我们提出深残余混合模型(DRMMs),这是一个全新的深层基因模型结构。与其他深层模型相比,DRMMs允许更灵活的有条件抽样:该模型可以经过一次与所有变量的培训,然后用于任意结合调节变量、高斯前科和(在)平等制约进行抽样。这为互动和探索性机器学习提供了新的机会,可以最大限度地减少用户等待再培训的模式。我们用受限制的多层反动和可控动动画生成来显示DRMMs。