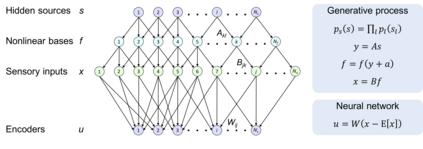

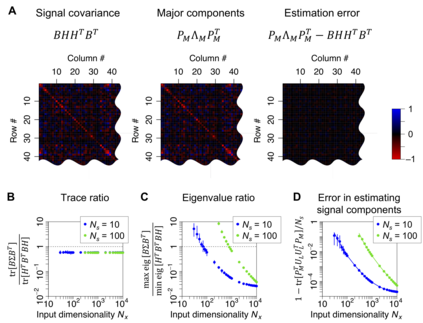

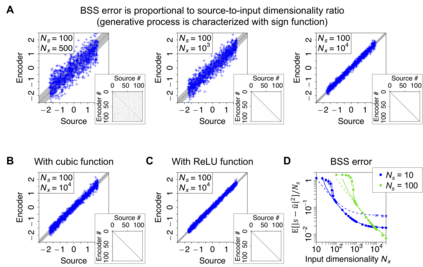

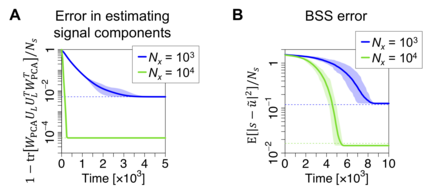

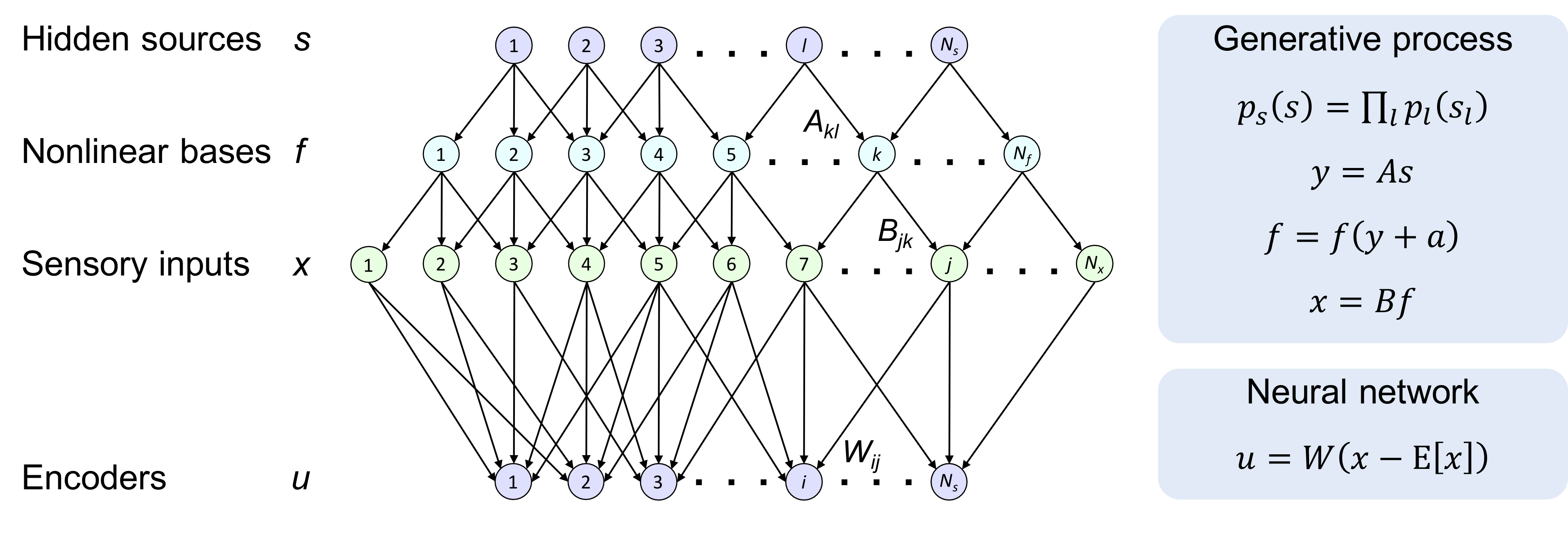

For many years, a combination of principal component analysis (PCA) and independent component analysis (ICA) has been used for blind source separation (BSS). However, it remains unclear why these linear methods work well with real-world data that involve nonlinear source mixtures. This work theoretically validates that a cascade of linear PCA and ICA can solve a nonlinear BSS problem accurately -- when the sensory inputs are generated from hidden sources via nonlinear mappings with sufficient dimensionality. Our proposed theorem, termed the asymptotic linearization theorem, theoretically guarantees that applying linear PCA to the inputs can reliably extract a subspace spanned by the linear projections from every hidden source as the major components -- and thus projecting the inputs onto their major eigenspace can effectively recover a linear transformation of the hidden sources. Then, subsequent application of linear ICA can separate all the true independent hidden sources accurately. Zero-element-wise-error nonlinear BSS is asymptotically attained when the source dimensionality is large and the input dimensionality is sufficiently larger than the source dimensionality. Our proposed theorem is validated analytically and numerically. Moreover, the same computation can be performed by using Hebbian-like plasticity rules, implying the biological plausibility of this nonlinear BSS strategy. Our results highlight the utility of linear PCA and ICA for accurately and reliably recovering nonlinearly mixed sources -- and further suggest the importance of employing sensors with sufficient dimensionality to identify true hidden sources of real-world data.

翻译:许多年来,主要组成部分分析(PCA)和独立组成部分分析(ICA)的组合被用于盲源分离(BSS),然而,仍然不清楚为什么这些线性方法与涉及非线性源混合物的真实世界数据运作良好。这项工作在理论上证实线性五氯苯甲醚和ICA的级联能够准确地解决非线性BSS问题 -- -- 当感官输入是通过非线性图象以足够维度的方式从隐性来源生成时 -- -- 我们的拟议理论,称为无线性线性线性理论,理论上保证在输入中应用线性五氯苯可以可靠地从各主要组成部分的每个隐藏来源的线性预测中提取一个以线性预测为间隔的子空间范围,从而预测其主要电子空间的投入能够有效地恢复隐藏来源的线性转变。随后,线性ICA的应用程序可以精确地将所有真正独立的隐性来源分离出来。当源量大而输入线性线性线性线性线性线性理论,当源性线性线性线性线性线性理论性理论保证在输入输入输入输入的线性五氯苯线性常线性常线性理论时,而输入的线性空间的线性常量性常量性空间的线性空间数据比线性数据性战略的准确性比来源的线性价值要大得多。我们使用不易性规则的精确性规则的精确性分析,我们所测的精确性规则的精确性分析, 。我们测的精确性估算性分析的精确性分析的精确性,用的数值性能性能性能性能的数值性能性能性能性能性能分析性能、性能、性能性能性能、性能性能性能性能性能性能分析性能分析性能性能性能性能、性能、性能、性、性能性能性能、性能、性能、性能、性能、性能、性能、性能、性能、性能性能性能、性能性能、性能、性能性能性能性能性能性能性能性能性能、性能、性能、性能性能性能、性能、性能性能性能性能性能性能性能性能性能性能性能性能性能性