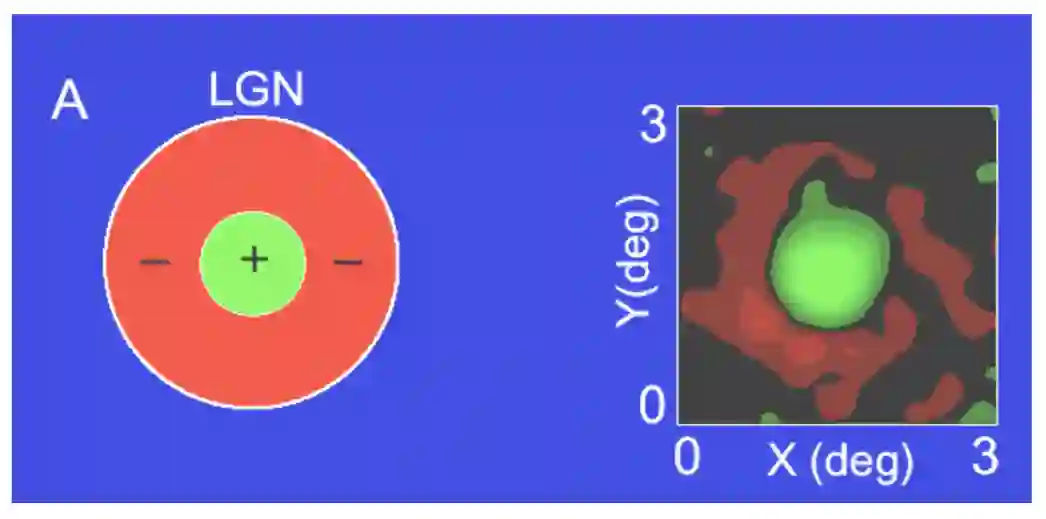

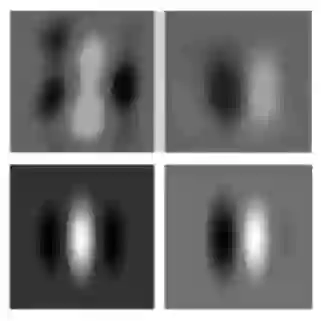

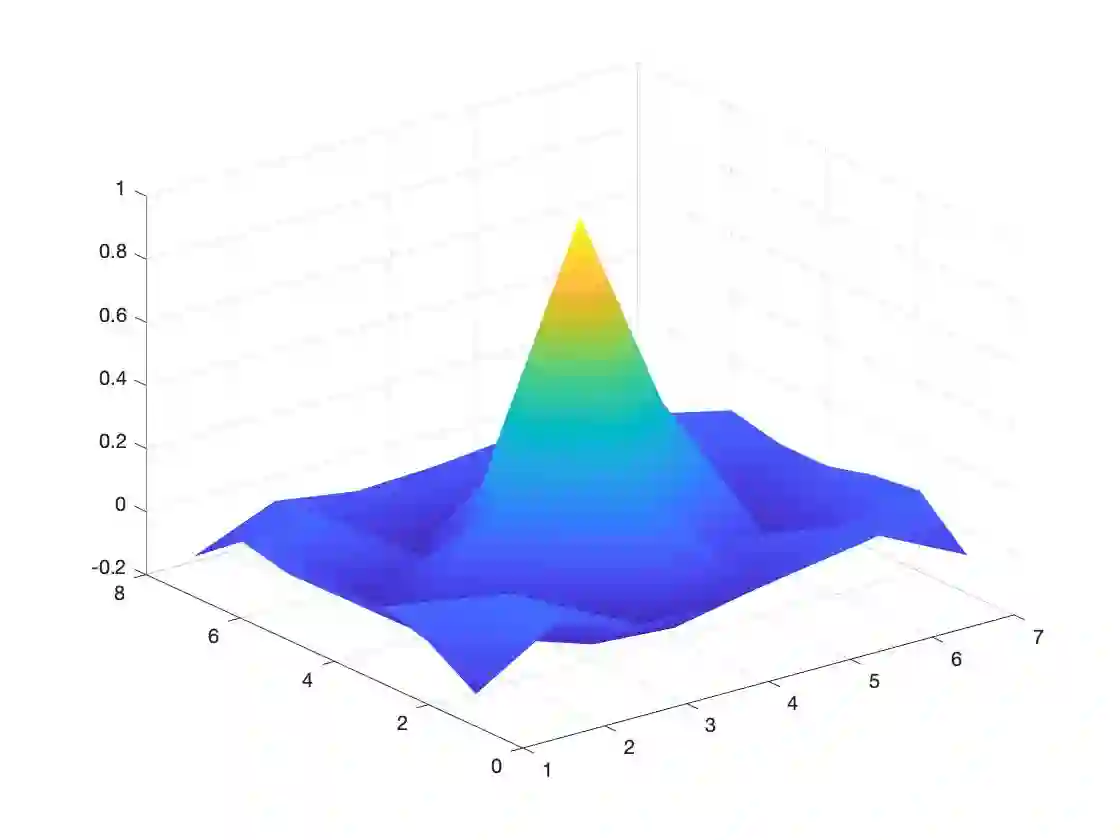

In this paper we introduce a biologically inspired Convolutional Neural Network (CNN) architecture called LGN-CNN that has a first convolutional layer composed by a single filter that mimics the role of the Lateral Geniculate Nucleus (LGN). The first layer of the neural network shows a rotationally symmetric pattern justified by the structure of the net itself that turns up to be an approximation of a Laplacian of Gaussian (LoG). The latter function is in turn a good approximation of the receptive profiles (RPs) of the cells in the LGN. The analogy with respect to the visual system structure is established, emerging directly from the architecture of the neural network. A proof of rotation invariance of the first layer is given on a fixed LGN-CNN architecture and the computational results are shown. Thus, contrast invariance capability of the LGN-CNN is investigated and a comparison between the Retinex effects of the first layer of LGN-CNN and the Retinex effects of a LoG is provided on different images. A statistical study is done on the filters of the second convolutional layer with respect to biological data.

翻译:在本文中,我们引入了一种生物激励的进化神经网络(CNN)结构,称为LGN-CNN, 其第一个进化层由单一过滤器组成,该过滤器模仿横向基因核核心(LGN)的作用。神经网络的第一层显示一个旋转的对称模式,其原理是网络本身的结构结构,该结构本身的近似于Gaussian(LoG)的拉拉帕西亚(LoGN),而后一种功能则是LGN-CNN细胞第一层的接收剖面(RPs)与LGN第一层的Retinex影响之间的近似。关于视觉系统结构的比喻是直接从神经网络结构中产生的。第一个层的旋转变化证据是在固定的LGN-CNN结构上提供的,计算结果也表明了这一点。因此,对LGNN-CNN(LGN-CNN)的逆向能力进行了比较,对LGN第一层的Retinex效应和LGLG的Retinex效应的不同图像进行了比较。关于生物进层的数据与第二层的过滤进行了统计研究。