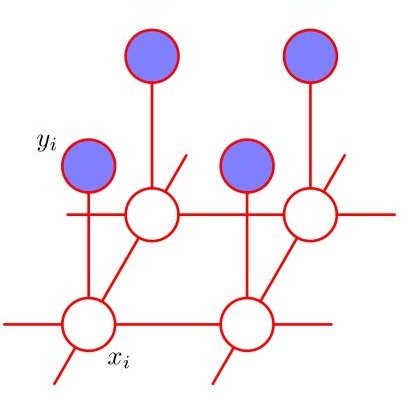

Dense disparities among multiple views is essential for estimating the 3D architecture of a scene based on the geometrical relationship among the scene and the views or cameras. Scenes with larger extents of heterogeneous textures, differing scene illumination among the multiple views and with occluding objects affect the accuracy of the estimated disparities. Markov random fields (MRF) based methods for disparity estimation address these limitations using spatial dependencies among the observations and among the disparity estimates. These methods, however, are limited by spatially fixed and smaller neighborhood systems or cliques. In this work, we present a new factor graph-based probabilistic graphical model for disparity estimation that allows a larger and a spatially variable neighborhood structure determined based on the local scene characteristics. We evaluated our method using the Middlebury benchmark stereo datasets and the Middlebury evaluation dataset version 3.0 and compared its performance with recent state-of-the-art disparity estimation algorithms. The new factor graph-based method provided disparity estimates with higher accuracy when compared to the recent non-learning- and learning-based disparity estimation algorithms. In addition to disparity estimation, our factor graph formulation can be useful for obtaining maximum a posteriori solution to optimization problems with complex and variable dependency structures as well as for other dense estimation problems such as optical flow estimation.

翻译:多种观点之间的巨大差异对于根据场景和观点或相机之间的几何关系来估计场景的三维结构至关重要。 场景的三维结构基于场景和视图或相机之间的几何关系。 场景的多样化质谱范围较大,多视图和隐形物体的场景光化不同,影响到估计差异的准确性。 以Markov随机字段为基础的差异估计方法利用观测和差异估计之间的空间依赖性来消除这些局限性。 但是,这些方法受到空间固定和较小的邻里系统或晶体的限制。 在这项工作中,我们为差异估计提供了一个新的基于因数图形的概率性能图形模型模型,允许根据当地场景特征确定一个更大和空间可变的社区结构。 我们用Middlebury基准立体数据集和Midledbury评价数据集3.0来评估我们的方法,并将其性能与最新最先进的差异估计算法进行比较。这些基于要素的图表方法提供了更高的差异估计数,与最近的非学习和学习的差异估计算法相比,我们提供了一个新的基于因数图表的模型的概率性估算法模型模型模型估算方法。除了差异估计外,我们作为最深度的模型的模型的模型的模型的模型的模型,对于获得最深度估计问题也是有用的,对于获得最深度的模型的,也是有用的,因为其最深度估计方法,对于获得最深度的精确性估算方法,对于获得最深度的估计。