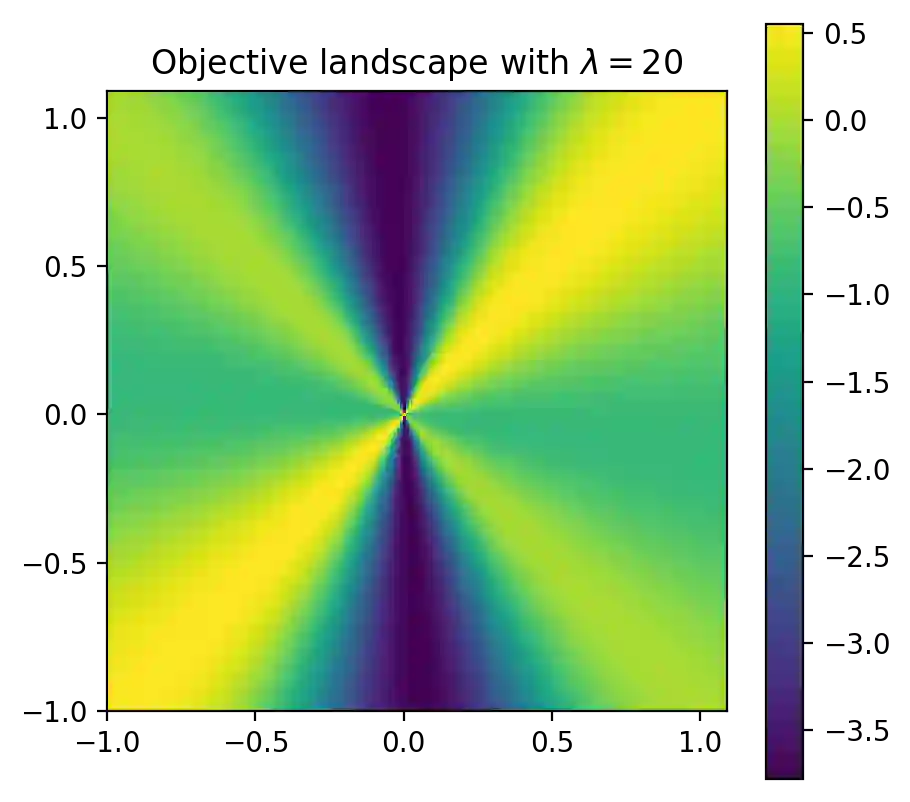

Deep predictive models often make use of spurious correlations between the label and the covariates that differ between training and test distributions. In many classification tasks, spurious correlations are induced by a changing relationship between the label and some nuisance variables correlated with the covariates. For example, in classifying animals in natural images, the background, which is the nuisance, can predict the type of animal. This nuisance-label relationship does not always hold. We formalize a family of distributions that only differ in the nuisance-label relationship and introduce a distribution where this relationship is broken called the nuisance-randomized distribution. We introduce a set of predictive models built from the nuisance-randomized distribution with representations, that when conditioned on, do not correlate the label and the nuisance. For models in this set, we lower bound the performance for any member of the family with the mutual information between the representation and the label under the nuisance-randomized distribution. To build predictive models that maximize the performance lower bound, we develop Nuisance-Randomized Distillation (NURD). We evaluate NURD on a synthetic example, colored-MNIST, and classifying chest X-rays. When using non-lung patches as the nuisance in classifying chest X-rays, NURD produces models that predict pneumonia under strong spurious correlations.

翻译:深度预测模型往往使用标签与不同培训和测试分布之间差异的共变点之间的虚假关联。 在许多分类任务中, 标签和一些与共变点相关的麻烦变量之间的关系不断变化, 从而诱发了虚假关联。 例如, 在自然图像中动物的分类中, 背景, 也就是麻烦, 可以预测动物的类型。 这种令人不安的标签关系并不总是能够维持。 我们正式确定一个分布的组合, 其分配方式在互调性标签关系和测试分布上有所不同, 并引入一种分配方式, 这种关系被打破了, 称之为骚扰- 随机分布。 我们引入了一套预测模型, 建于骚扰- 随机分布与共变异关系的关系中, 建构了一套预测模型, 建于骚扰- 骚扰- 随机分布上, 建构了一套预测模型, 设时, 与标签和骚扰- 调和 调和 调和 调 (我们用NUS- NU- NB- Calizal- Claimal- disal- dislational- disal laimal laimal laimal- disal- disal lagial- lagial- disal- lax- disal- disal- dismal- dism- disl- disl- dismal- dismal- lavialvial- lavial- lavial- dism- dismal- dismal- dismal- dism- dismalvialvialvialvical- dism- dism- dismal- dism- dism- vical- lavical- dism- dism- dismalvi) vi) vi) ass- vi) ass- ass- vical- imal- ass- ass- imal- imal- sal- sal- vial- imal- imal- sal- sal- sal- imal- sal- sal- laism- laismal- laismal- laismal- imal