题目: Data-Efficient Image Recognition with Contrastive Predictive Coding

摘要:

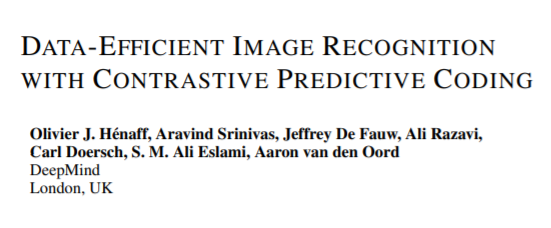

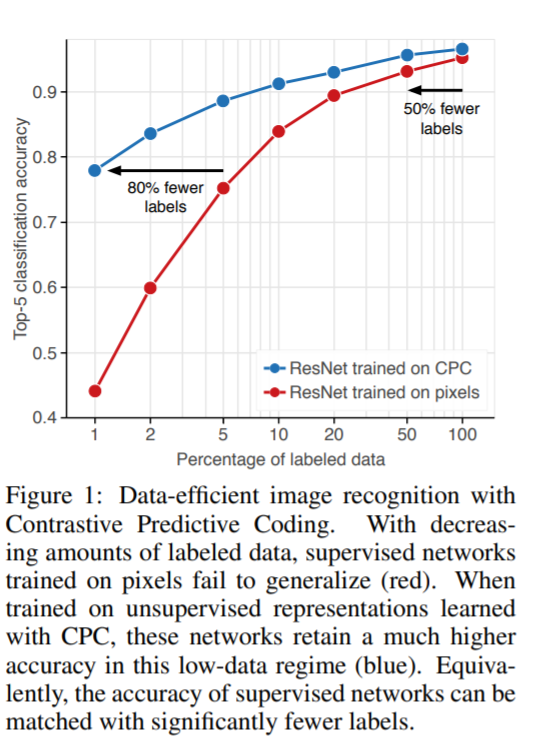

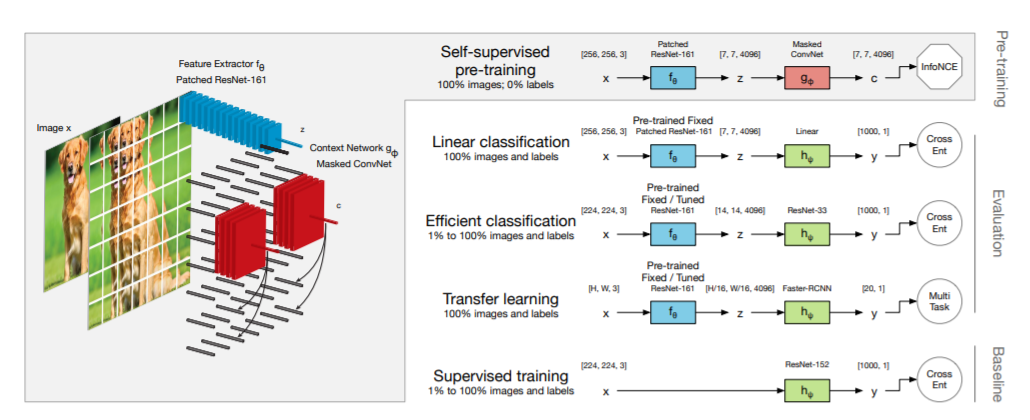

人类观察者可以从一些例子中学习识别新的图像类别,但用机器感知来做到这一点仍然是一个开放的挑战。我们假设有效的数据识别是通过使自然信号的可变性更可预测的表征来实现的。因此,我们重新审视并改进了对比预测编码,这是一种学习此类表示的无监督目标。这个新实现产生的特性支持在ImageNet数据集上最先进的线性分类精度。当使用深度神经网络作为非线性分类的输入时,这种表示方法允许我们使用比直接训练在图像像素上的分类器少2-5倍的标签。最后,这种无监督表示大大改进了PASCAL VOC-2007上的目标检测迁移学习,超越了完全监督的预训练的ImageNet分类器。

作者简介:

Aravind Srinivas是加州大学伯克利分校三年级的博士生,指导老师是Pieter Abbeel教授,研究兴趣是使用深度神经网络学习原始感官观察的表示法,目前正在从事深度生成建模和深度强化学习。

Carl Doersch是DeepMind的一名研究科学家,与Andrew Zisserman密切合作。在CMU完成了博士学位,于2010年毕业于卡内基梅隆大学,获得计算机科学和认知科学学士学位,研究兴趣是计算机视觉和与之相关的学习问题,并且对自我监督和非监督学习特别感兴趣。

成为VIP会员查看完整内容

相关内容

专知会员服务

10+阅读 · 2019年12月12日

【ICDAR2019教程】模式识别和文档图像中基于图的方法,Graph-based Methods in Pattern Recognition and Document Image Analysis

专知会员服务

30+阅读 · 2019年9月20日

Arxiv

8+阅读 · 2020年4月13日

Arxiv

5+阅读 · 2018年4月3日

Arxiv

4+阅读 · 2018年1月29日