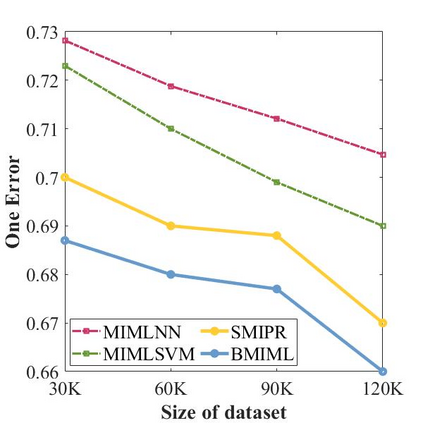

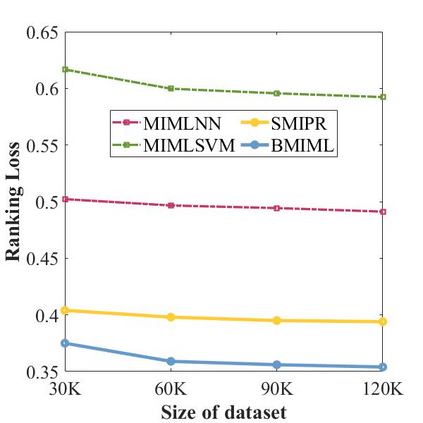

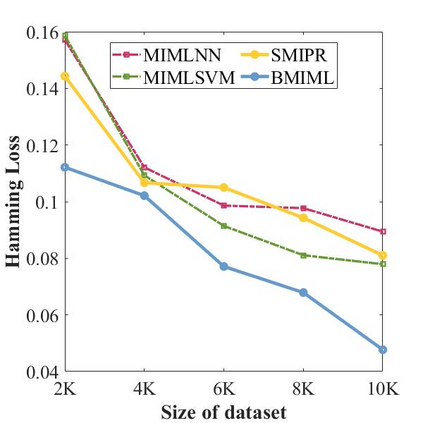

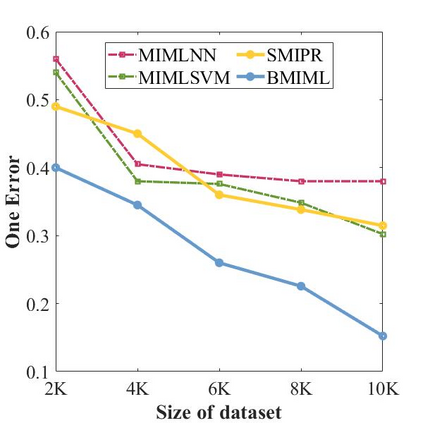

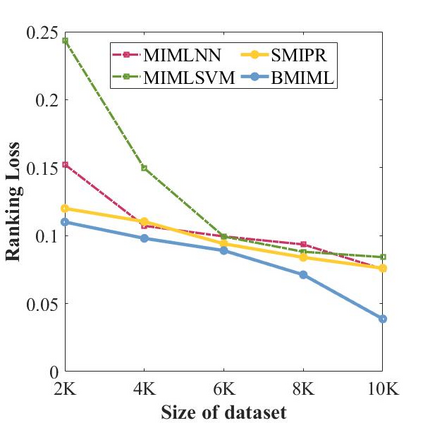

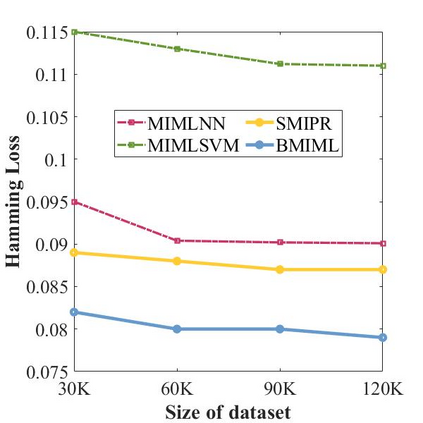

In many real-world applications, one object (e.g., image) can be represented or described by multiple instances (e.g., image patches) and simultaneously associated with multiple labels. Such applications can be formulated as multi-instance multi-label learning (MIML) problems and have been extensively studied during the past few years. Existing MIML methods are useful in many applications but most of which suffer from relatively low accuracy and training efficiency due to several issues: i) the inter-label correlations (i.e., the probabilistic correlations between the multiple labels corresponding to an object) are neglected; ii) the inter-instance correlations cannot be learned directly (or jointly) with other types of correlations due to the missing instance labels; iii) diverse inter-correlations (e.g., inter-label correlations, inter-instance correlations) can only be learned in multiple stages. To resolve these issues, a new single-stage framework called broad multi-instance multi-label learning (BMIML) is proposed. In BMIML, there are three innovative modules: i) an auto-weighted label enhancement learning (AWLEL) based on broad learning system (BLS); ii) A specific MIML neural network called scalable multi-instance probabilistic regression (SMIPR); iii) Finally, an interactive decision optimization (IDO). As a result, BMIML can achieve simultaneous learning of diverse inter-correlations between whole images, instances, and labels in single stage for higher classification accuracy and much faster training time. Experiments show that BMIML is highly competitive to (or even better than) existing methods in accuracy and much faster than most MIML methods even for large medical image data sets (> 90K images).

翻译:在许多真实世界应用程序中,一个对象(例如图像)可以由多个实例(例如图像补丁)来代表或描述,并同时与多个标签相关。这些应用程序可以作为多因子多标签学习(MIML)问题来形成,并在过去几年中进行了广泛研究。现有的MIML方法在许多应用中非常有用,但由于一些问题,其中多数具有相对较低的精确度和培训效率。i) 标签间的相关性(例如,与一个对象相对应的多个标签的图像之间的概率性相关性被忽略;ii) 无法直接(或联合)学习与因缺失实例标签而导致的其他类型关联的精确性相关性;iii 现有的MIML方法在多个应用中是有用的,但是由于以下几个问题,这些方法中大多数都存在相对较低的精确度和培训效率:i) i) i- orialical or milalal i-lational mailal i-loral milal i-loral lailal i-loral i) a lax lais mal lacial lais mal lais mal lax a mal lacial lais mal a mal a mal a mal a mess mess mal a mal a mal a mal mal mal a mal a mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess mess m