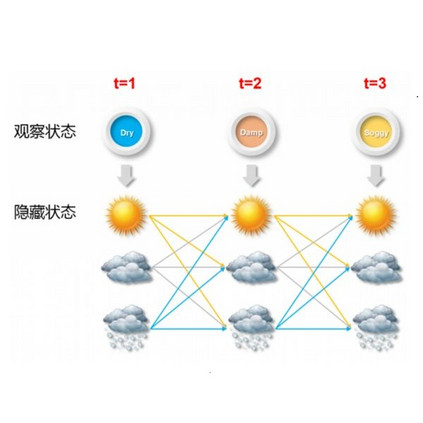

The Baum-Welch (B-W) algorithm is the most widely accepted method for inferring hidden Markov models (HMM). However, it is prone to getting stuck in local optima, and can be too slow for many real-time applications. Spectral learning of HMMs (SHMM), based on the method of moments (MOM) has been proposed in the literature to overcome these obstacles. Despite its promises, asymptotic theory for SHMM has been elusive, and the long-run performance of SHMM can degrade due to unchecked propagation of error. In this paper, we (1) provide an asymptotic distribution for the approximate error of the likelihood estimated by SHMM, (2) propose a novel algorithm called projected SHMM (PSHMM) that mitigates the problem of error propagation, and (3) develop online learning variants of both SHMM and PSHMM that accommodate potential nonstationarity. We compare the performance of SHMM with PSHMM and estimation through the B-W algorithm on both simulated data and data from real world applications, and find that PSHMM not only retains the computational advantages of SHMM, but also provides more robust estimation and forecasting.

翻译:Baum-Welch(B-W)算法是推断隐马尔可夫模型(HMM)最广泛接受的方法。但是,它容易陷入局部最优,并且对于许多实时应用程序而言速度太慢。基于矩的光谱学习(SHMM)的HMM已被提出在文献中以克服这些障碍。尽管它的承诺是令人满意的,但SHMM的渐近理论一直是难以捉摸的,并且由于未经检查的错误传播,SHMM的长期性能可能会降低。在本文中,我们(1)提供了由SHMM估计的似然误差的近似误差的渐近分布,(2)提出了一种名为投影SHMM(PSHMM)的新算法,以减轻错误传播问题,以及(3)开发了在线学习的变体,既包括SHMM,也包括PSHMM,适应潜在的非稳态。我们在模拟数据和来自真实世界应用程序的数据上比较了SHMM,PSHMM和通过B-W算法进行估计的性能,并发现PSHMM不仅保留了SHMM的计算优势,而且提供了更强大的估计和预测。