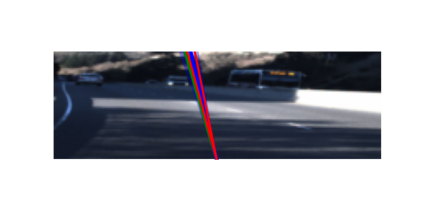

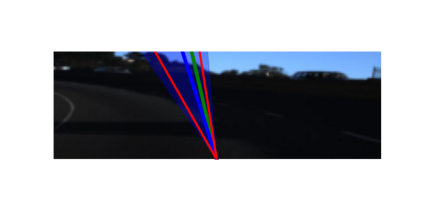

Formal verification of neural networks is critical for their safe and secure adoption in real-world applications. However, designing a precise and scalable verifier which can handle different activation functions, realistic network architectures and relevant specifications remains an open and difficult challenge. In this paper, we take a major step in addressing this challenge and present a new verification framework, called PRIMA. PRIMA is both (i) general: it handles any non-linear activation function, and (ii) precise: it computes precise convex approximations involving multiple neurons via novel convex hull approximation algorithms that leverage concepts from computational geometry. The algorithms have polynomial complexity, yield fewer constraints, and minimize precision loss. We evaluate the effectiveness of PRIMA on a variety of challenging image classifiers from prior work. Our results show that PRIMA is significantly more precise than state-of-the-art, verifying robustness for up to 14%, 30%, and 34% more images than existing work on ReLU-, Sigmoid-, and Tanh-based networks, respectively. Further, PRIMA enables, for the first time, precise verification of a realistic neural network for autonomous driving within a few minutes.

翻译:对神经网络进行正式核查对于在现实世界应用中安全可靠地采用神经网络至关重要。 但是,设计精确和可扩缩的核查器,能够处理不同的激活功能、现实的网络架构和相关规格,这仍然是一个公开和困难的挑战。 在本文件中,我们在应对这一挑战方面迈出了一大步,并提出了一个新的核查框架,称为PRIMA。 PRIMA是:(一) 一般性的:它处理任何非线性激活功能,和(二) 精确的:它通过利用计算几何学概念的新型convex 舱面近似算法,计算出涉及多个神经的精确的共振动近似值。这些算法具有多种复杂性,产生较少的限制,并最大限度地减少精确损失。我们评估了PRIMA在以前工作中对各种具有挑战性的形象分类者的有效性。我们的结果表明,PRIMA比当时的状态要精确得多,它分别核查高达14%、30%和34%的稳健度,比目前关于ReLU、Sigmoid-和Tanh网络的工作高出34%的图像。此外,PRIMA首次在几个分钟内可以对现实的网络进行自主的自动的核查。