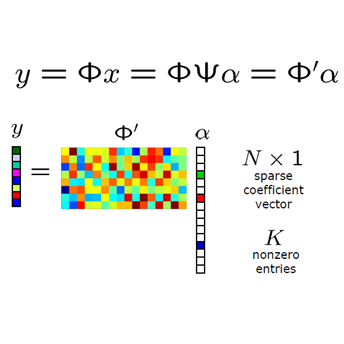

Objective: Parallel imaging accelerates the acquisition of magnetic resonance imaging (MRI) data by acquiring additional sensitivity information with an array of receiver coils resulting in reduced phase encoding steps. Compressed sensing magnetic resonance imaging (CS-MRI) has achieved popularity in the field of medical imaging because of its less data requirement than parallel imaging. Parallel imaging and compressed sensing (CS) both speed up traditional MRI acquisition by minimizing the amount of data captured in the k-space. As acquisition time is inversely proportional to the number of samples, the inverse formation of an image from reduced k-space samples leads to faster acquisition but with aliasing artifacts. This paper proposes a novel Generative Adversarial Network (GAN) namely RECGAN-GR supervised with multi-modal losses for de-aliasing the reconstructed image. Methods: In contrast to existing GAN networks, our proposed method introduces a novel generator network namely RemU-Net integrated with dual-domain loss functions including weighted magnitude and phase loss functions along with parallel imaging-based loss i.e., GRAPPA consistency loss. A k-space correction block is proposed as refinement learning to make the GAN network self-resistant to generating unnecessary data which drives the convergence of the reconstruction process faster. Results: Comprehensive results show that the proposed RECGAN-GR achieves a 4 dB improvement in the PSNR among the GAN-based methods and a 2 dB improvement among conventional state-of-the-art CNN methods available in the literature. Conclusion and significance: The proposed work contributes to significant improvement in the image quality for low retained data leading to 5x or 10x faster acquisition.

翻译:目标:平行成像加快获取磁共振成像(MRI)数据的速度,办法是通过一系列接收器卷圈获得更多的敏感信息,从而减少了阶段编码步骤;压缩的磁共振成像(CS-MRI)因其数据要求少于平行成像,在医学成像领域已变得受欢迎;平行成像和压缩感测(CS)都通过尽量减少在K-空间采集的数据数量,加快了传统的磁共振成像(MRI)数据的获取速度;由于获取时间与样品数量成反比,从减少的K-空间样品到更快获取图像,图像的获取速度会更快,但以别的方式获取。本文提议建立一个新型的GEN-Aversarial网络(GAN),即RECGAN-GR(C),以多模式损失方式监督医疗成像成像领域;与现有的GAN网络相比,我们提议的方法引入了一个新的发电机网络,即雷姆-Net,以包括加权质量和阶段损失功能与平行成像损失(即GRIPPA)的改进过程;K-B一致性损失;K-A-C-C-C-C-C-C-C-C-LA-C-C-C-C-C-C-C-LVILM-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-G-L-L-G-L-G-G-L-L-L-G-G-G-G-G-G-G-G-G-G-G-G-L-L-G-G-G-G-G-L-G-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-L-