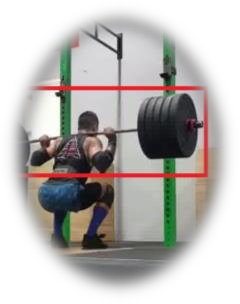

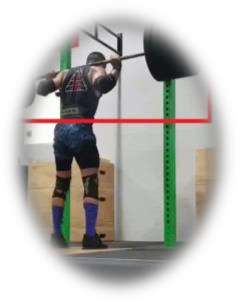

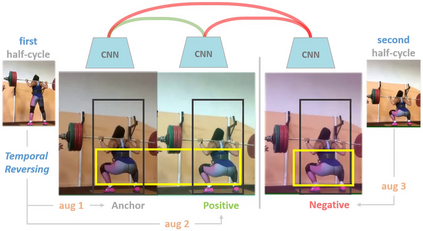

Maintaining proper form while exercising is important for preventing injuries and maximizing muscle mass gains. Detecting errors in workout form naturally requires estimating human's body pose. However, off-the-shelf pose estimators struggle to perform well on the videos recorded in gym scenarios due to factors such as camera angles, occlusion from gym equipment, illumination, and clothing. To aggravate the problem, the errors to be detected in the workouts are very subtle. To that end, we propose to learn exercise-oriented image and video representations from unlabeled samples such that a small dataset annotated by experts suffices for supervised error detection. In particular, our domain knowledge-informed self-supervised approaches (pose contrastive learning and motion disentangling) exploit the harmonic motion of the exercise actions, and capitalize on the large variances in camera angles, clothes, and illumination to learn powerful representations. To facilitate our self-supervised pretraining, and supervised finetuning, we curated a new exercise dataset, \emph{Fitness-AQA} (\url{https://github.com/ParitoshParmar/Fitness-AQA}), comprising of three exercises: BackSquat, BarbellRow, and OverheadPress. It has been annotated by expert trainers for multiple crucial and typically occurring exercise errors. Experimental results show that our self-supervised representations outperform off-the-shelf 2D- and 3D-pose estimators and several other baselines. We also show that our approaches can be applied to other domains/tasks such as pose estimation and dive quality assessment.

翻译:在锻炼过程中保持正确形式对于防止伤害和最大限度地提高肌肉质量十分重要。 检测锻炼形式的错误自然需要估计人体的姿势。 然而, 现成的显示显示显示显示显示显示器由于摄像角度、 体育设备隔热、 照明和衣着等因素,在健身场景中记录下来的视频效果良好。 使问题更加严重, 将在锻炼过程中检测到的错误是非常微妙的。 为此, 我们建议从未标定的样本中学习锻炼面向锻炼的图像和视频表现, 以便专家加注的小数据集足以监督地检测出错误。 特别是, 我们的以知识为基础的自我监督方法( 包括对比学习和运动不触动) 利用锻炼动作的和谐动作, 利用摄像角度、 衣着和污点的巨大差异来学习强力的演示。 为了便利我们自我超强力的训练、 监督的微调整、 我们重新整理的演练数据集器、 精度- 高级的解析器- 以及其它的自我演练、 基础- 自我演练、 自我演练的自我演练、 显示的自我演练、 展示、 展示、 展示、 高级- 展示- 展示- 演示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 展示- 常规- 等- 展示- 等- 展示- 等- 常规- 结构- 结构- 结构- 演练- 结构- 结构- 结构- 结构- 结构- 结构- 、 结构- 结构- 结构- 显示- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 、 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 结构- 、 、 、 、 、 、 、 结构- 、 、 结构- 结构- 展示- 结构- 结构- 结构- 结构- 、 、 、 、