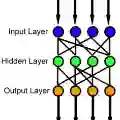

Physical neural networks are promising candidates for next generation artificial intelligence hardware. In such architectures, neurons and connections are physically realized and do not leverage digital concepts with their practically infinite signal-to-noise ratio to encode, transduce and transform information. They therefore are prone to noise with a variety of statistical and architectural properties, and effective strategies leveraging network-inherent assets to mitigate noise in an hardware-efficient manner are important in the pursuit of next generation neural network hardware. Based on analytical derivations, we here introduce and analyse a variety of different noise-mitigation approaches. We analytically show that intra-layer connections in which the connection matrix's squared mean exceeds the mean of its square fully suppresses uncorrelated noise. We go beyond and develop two synergistic strategies for noise that is uncorrelated and correlated across populations of neurons. First, we introduce the concept of ghost neurons, where each group of neurons perturbed by correlated noise has a negative connection to a single neuron, yet without receiving any input information. Secondly, we show that pooling of neuron populations is an efficient approach to suppress uncorrelated noise. As such, we developed a general noise mitigation strategy leveraging the statistical properties of the different noise terms most relevant in analogue hardware. Finally, we demonstrate the effectiveness of this combined approach for trained neural network classifying the MNIST handwritten digits, for which we achieve a 4-fold improvement of the output signal-to-noise ratio and increase the classification accuracy almost to the level of the noise-free network.

翻译:物理神经网络是下一代人工智能硬件的有希望的候选人。 在这类建筑中,神经元和连接实现了物理上,并且不利用数字概念,其信号-噪音比率与编码、转换和转换信息之间几乎是无限的信号-噪音比率,因此,它们容易出现噪音,具有各种统计和建筑特性,而利用网络内在资产以硬件效率方式减少噪音的有效战略,对于追求下一代神经网络硬件十分重要。根据分析得出的结果,我们在这里引入和分析各种不同的减少噪音的方法。我们分析表明,连接矩阵正方形的精确度几乎超过其正方形平均值的数字概念,从而完全压制与非气候有关的噪音。我们超越并开发了两种协同战略,以各种神经群体之间不相干和相互联系的噪音。首先,我们引入了幽灵神经概念,每个受关联噪音困扰的神经群体与单一的神经网络有负面联系,但没有获得任何投入信息。 其次,我们表明,将神经人口连接成一个高效的方法,几乎超过其信号键值的准确度,完全压制其平方形的平方形神经网络水平,我们最后用一个经过训练的硬体级的硬体级的硬体级的硬体结构战略来显示,我们用这种硬体的硬体的硬体变的硬体变的硬体变的硬体的硬体的硬体结构的硬体结构,我们发展了这个等的硬体的硬体的硬体的硬体的硬体的硬体的硬体的硬体的硬体的硬体的硬体结构的硬体战略。