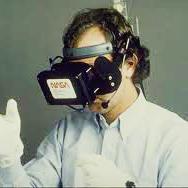

Visual neuroprostheses (bionic eyes) have the potential to treat degenerative eye diseases that often result in low vision or complete blindness. These devices rely on an external camera to capture the visual scene, which is then translated frame-by-frame into an electrical stimulation pattern that is sent to the implant in the eye. To highlight more meaningful information in the scene, recent studies have tested the effectiveness of deep-learning based computer vision techniques, such as depth estimation to highlight nearby obstacles (DepthOnly mode) and semantic edge detection to outline important objects in the scene (EdgesOnly mode). However, nobody has attempted to combine the two, either by presenting them together (EdgesAndDepth) or by giving the user the ability to flexibly switch between them (EdgesOrDepth). Here, we used a neurobiologically inspired model of simulated prosthetic vision (SPV) in an immersive virtual reality (VR) environment to test the relative importance of semantic edges and relative depth cues to support the ability to avoid obstacles and identify objects. We found that participants were significantly better at avoiding obstacles using depth-based cues as opposed to relying on edge information alone, and that roughly half the participants preferred the flexibility to switch between modes (EdgesOrDepth). This study highlights the relative importance of depth cues for SPV mobility and is an important first step towards a visual neuroprosthesis that uses computer vision to improve a user's scene understanding.

翻译:视觉神经假眼( 双眼) 有可能治疗导致视力低或完全失明的变异性眼睛疾病。 这些装置依靠外部摄像头来捕捉视觉场景, 然后将框架转换成电子刺激模式, 发送到眼睛中的植入器。 为了在现场突出更有意义的信息, 最近的研究测试了基于深层次学习的计算机视觉技术的有效性, 比如深度估计以突出附近障碍( DephOnly 模式) 和语义边缘检测以描述现场重要对象( 仅视模式 ) 。 但是, 没有人试图将两者结合起来, 要么一起展示( Edgesand- Depeh ), 要么让用户能够灵活地在它们之间转换( Edges Or Depth ) 。 在那里,我们用一个神经生物学启发模型模拟假肢视觉视觉( SPV) 模拟虚拟现实环境来测试语义边缘和相对深度提示的相对重要性, 支持避免障碍和识别物体的能力。 然而, 我们发现, 参与者们更愿意将两者结合起来, 在深度深度研究中, 相对的直观模型中, 更需要使用S- 直观的深度中, 选择了一种直观的路径, 在深度研究中, 的深度中, 直观的深度中, 直观的深度中, 直观的深度中, 。