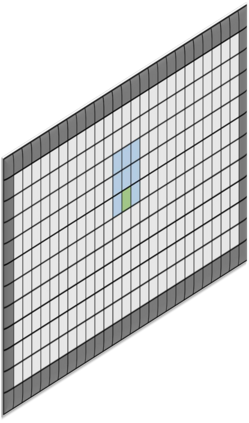

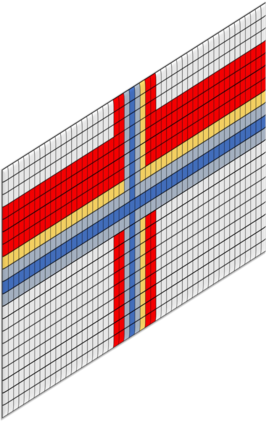

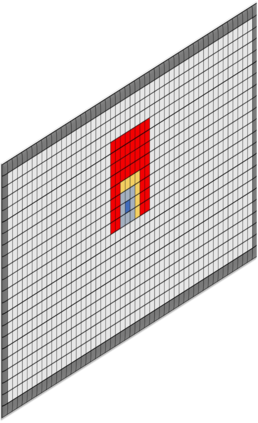

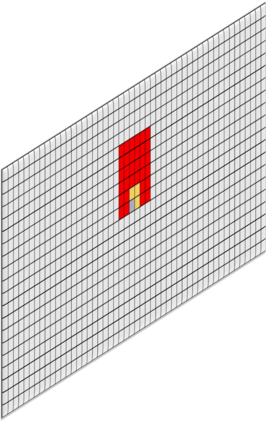

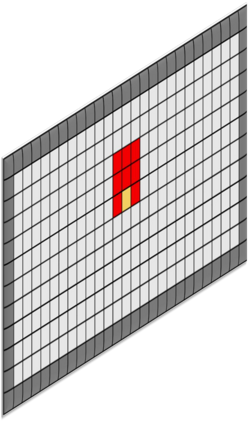

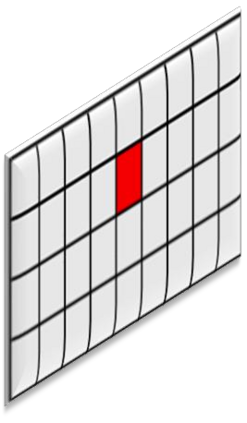

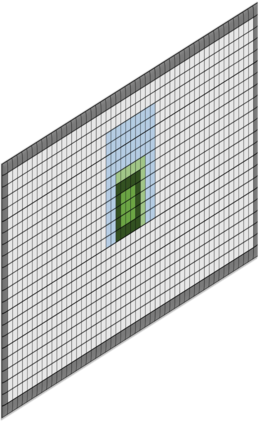

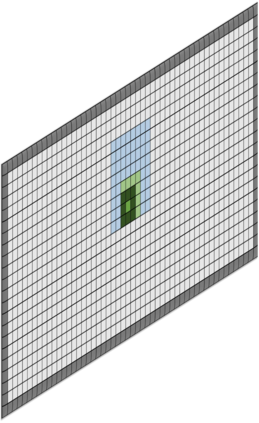

Deep learning techniques have become prominent in modern fault diagnosis for complex processes. In particular, convolutional neural networks (CNNs) have shown an appealing capacity to deal with multivariate time-series data by converting them into images. However, existing CNN techniques mainly focus on capturing local or multi-scale features from input images. A deep CNN is often required to indirectly extract global features, which are critical to describe the images converted from multivariate dynamical data. This paper proposes a novel local-global CNN (LG-CNN) architecture that directly accounts for both local and global features for fault diagnosis. Specifically, the local features are acquired by traditional local kernels whereas global features are extracted by using 1D tall and fat kernels that span the entire height and width of the image. Both local and global features are then merged for classification using fully-connected layers. The proposed LG-CNN is validated on the benchmark Tennessee Eastman process (TEP) dataset. Comparison with traditional CNN shows that the proposed LG-CNN can greatly improve the fault diagnosis performance without significantly increasing the model complexity. This is attributed to the much wider local receptive field created by the LG-CNN than that by CNN. The proposed LG-CNN architecture can be easily extended to other image processing and computer vision tasks.

翻译:深层学习技巧在复杂过程的现代断层诊断中变得十分突出。特别是,进化神经网络(CNNNs)已经显示出通过将其转换成图像来处理多变时间序列数据的诱人能力,然而,现有的CNN技术主要侧重于从输入图像中捕捉本地或多尺度的特征。通常需要一个深层次CNN来间接提取全球特征,这些特征对于描述从多变动态数据转换成的图像至关重要。本文件提议了一个全新的本地-全球CNN(LG-CNN)结构,它直接反映地方和全球的缺陷诊断特征。具体地说,当地特征是由传统的本地内核内核获得的,而全球特征则通过使用覆盖图像整个高度和宽度的1D高和脂肪内核来提取。然后将本地和全球的功能合并,以便使用完全连接的层进行分类。拟议的LGNNN(LGN) 数据库与传统的CNCN(LGN)数据库比较表明,拟议的LG-CN(LG)系统(LG-G)所创建的更宽得多的本地化域图象处理,这归因于LG(LG-G-G)所拟议的计算机图象化的更宽得多的地方化的域,而LG-G(LG)的图象化的图象化的图象化的图象化的图象,比LG.G-G-G.N(LG-G-G-G-G-G-LG)可以扩大的图的图的图的图的图象的图象化的图的图的图的图的图的图象的图象可以更宽得多。