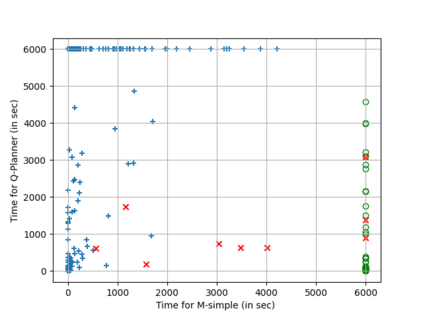

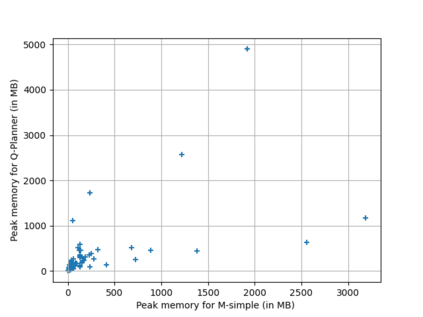

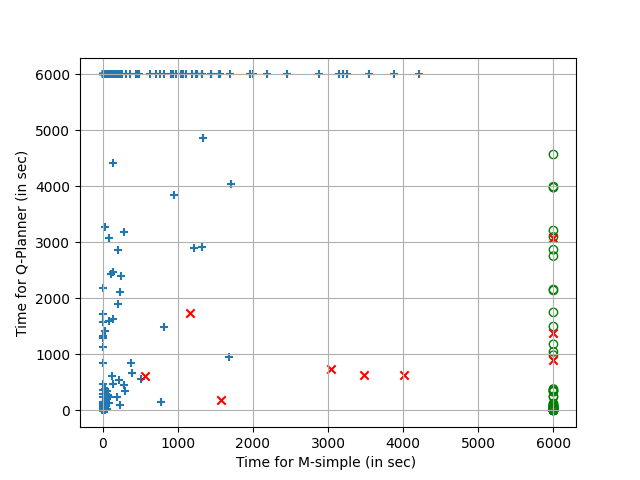

Most classical planners use grounding as a preprocessing step, reducing planning to propositional logic. However, grounding comes with a severe cost in memory, resulting in large encodings for SAT/QBF based planners. Despite the optimisations in SAT/QBF encodings such as action splitting, compact encodings and using parallel plans, the memory usage due to grounding remains a bottleneck when actions have many parameters, such as in the Organic Synthesis problems from the IPC 2018 planning competition (in its original non-split form). In this paper, we provide a compact QBF encoding that is logarithmic in the number of objects and avoids grounding completely by using universal quantification for object combinations. We compare the ungrounded QBF encoding with the simple SAT encoding and also show that we can solve some of the Organic Synthesis problems, which could not be handled before by any SAT/QBF based planners due to grounding.

翻译:多数古典规划者将地基用作预处理步骤,将规划缩减为假设逻辑。然而,地基工作在记忆中成本高昂,导致SAT/QBF基规划者大量编码。尽管SAT/QBF编码优化,如行动分割、紧凑编码和使用平行计划,但是,在行动有许多参数,如2018年IPC规划竞争的有机合成问题(原非分裂形式)中,地基工作仍是一个瓶颈。在本文中,我们提供了对物体数进行对数的QBF编码,并避免通过对物体组合进行普遍量化而完全地落地。我们比较了无地基的QBF编码与简单的SAT编码,还表明我们可以解决一些有机合成问题,因为这些问题以前不可能由任何基于SAT/QBF的规划者处理,因为要立地工作。