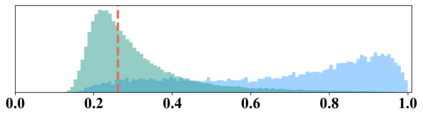

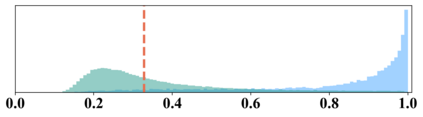

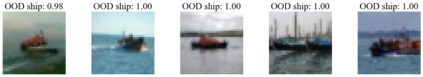

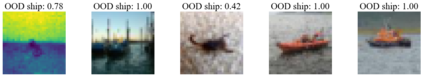

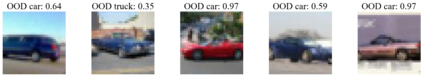

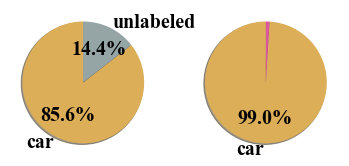

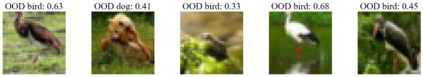

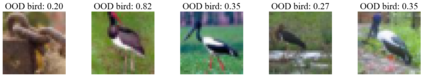

Current out-of-distribution (OOD) detection benchmarks are commonly built by defining one dataset as in-distribution (ID) and all others as OOD. However, these benchmarks unfortunately introduce some unwanted and impractical goals, e.g., to perfectly distinguish CIFAR dogs from ImageNet dogs, even though they have the same semantics and negligible covariate shifts. These unrealistic goals will result in an extremely narrow range of model capabilities, greatly limiting their use in real applications. To overcome these drawbacks, we re-design the benchmarks and propose the semantically coherent out-of-distribution detection (SC-OOD). On the SC-OOD benchmarks, existing methods suffer from large performance degradation, suggesting that they are extremely sensitive to low-level discrepancy between data sources while ignoring their inherent semantics. To develop an effective SC-OOD detection approach, we leverage an external unlabeled set and design a concise framework featured by unsupervised dual grouping (UDG) for the joint modeling of ID and OOD data. The proposed UDG can not only enrich the semantic knowledge of the model by exploiting unlabeled data in an unsupervised manner, but also distinguish ID/OOD samples to enhance ID classification and OOD detection tasks simultaneously. Extensive experiments demonstrate that our approach achieves state-of-the-art performance on SC-OOD benchmarks. Code and benchmarks are provided on our project page: https://jingkang50.github.io/projects/scood.

翻译:目前的分配外(OOD)检测基准通常是通过将一个数据集定义为分布(ID)而将所有其他数据集定义为OOD来构建的。然而,不幸的是,这些基准引入了一些不必要和不切实际的目标,例如,将CIFAR狗与图像网狗完全区分开来,即使它们具有同样的语义和可忽略的共变性变化。这些不切实际的目标将导致模型能力范围极为狭窄,大大限制了它们在实际应用中的使用。为了克服这些缺陷,我们重新设计基准,并提议具有一致性的分布外检测(SC-OOOD)。在SC-OOOD基准方面,现有方法存在一些不必要的和不切实际的目标,例如,将CIFAR狗与图像网狗与图像网狗完全区分开去。为了开发一个有效的SC-OOD检测方法,我们利用外部未加标签的数据集设计了一个简明框架,用不超标的双组(UDG)为ID和OD数据的联合建模。拟议的UDG不仅可以丰富关于S-OD基准的语义知识,而且通过探索未加标签的OD/D(OD/D)的模型的模型,还能够在不升级的SDDDD/D/DDBD/DBDM 上实现我们的项目的测试方法的升级的模型的模型,还提供了一种不透明性标定。