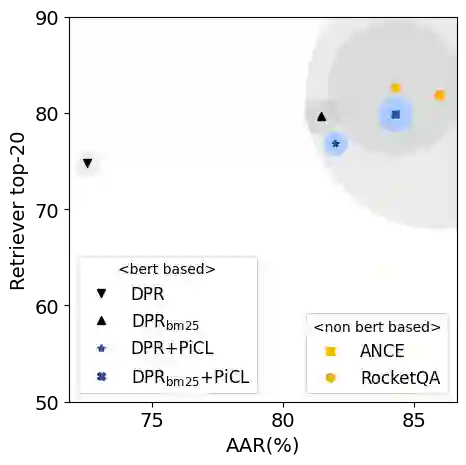

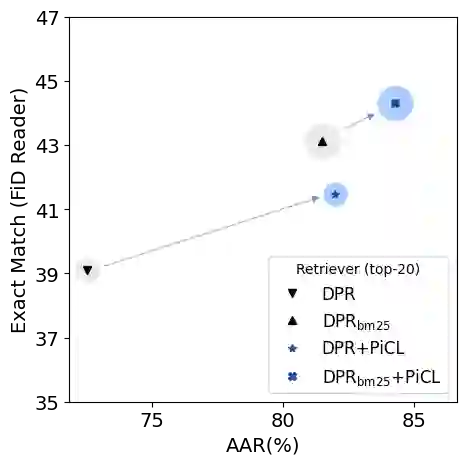

The retriever-reader framework is popular for open-domain question answering (ODQA), where a retriever samples for the reader a set of relevant candidate passages from a large corpus. A key assumption behind this method is that high relevance scores from the retriever likely indicate high answerability from the reader, which implies a high probability that the retrieved passages contain answers to a given question. In this work, we empirically dispel this belief and observe that recent dense retrieval models based on DPR often rank unanswerable counterfactual passages higher than their answerable original passages. To address such answer-unawareness in dense retrievers, we seek to use counterfactual samples as additional training resources to better synchronize the relevance measurement of DPR with the answerability of question-passage pairs. Specifically, we present counterfactually-Pivoting Contrastive Learning (PiCL), a novel representation learning approach for passage retrieval that leverages counterfactual samples as pivots between positive and negative samples in their learned embedding space. We incorporate PiCL into the retriever training to show the effectiveness of PiCL on ODQA benchmarks and the robustness of the learned models.

翻译:检索器-读者框架在开放领域问答(ODQA)中很受欢迎,其中检索器从大型语料库中对读者抽取一组相关候选段落。这种方法背后的一个关键假设是,检索器得分高的段落很可能意味着读者具有高的可回答性,这意味着检索到的段落很有可能包含给定问题的答案。在这项工作中,我们通过实验证明这种信念是错误的,发现基于DPR的最新密集检索模型通常会将无法回答的反事实段落排名高于可回答的原始段落。为了解决密集检索器中的这种无法回答性,我们试图使用反事实样本作为额外的训练资源,以更好地将DPR的相关度量与问题-段落对的可回答性同步。具体而言,我们提出了反事实中心对比学习(PiCL),一种新颖的表示学习方法,用于段落检索,该方法利用反事实样本作为他们学习嵌入空间中正负样本间的中心点。我们将PiCL纳入检索器的训练中,以展示PiCL在ODQA基准测试中的有效性以及学习模型的鲁棒性。