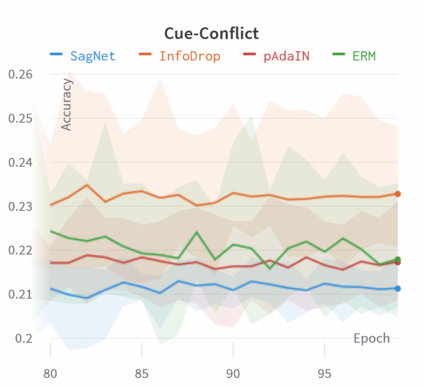

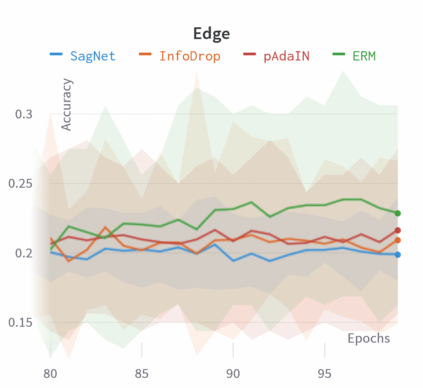

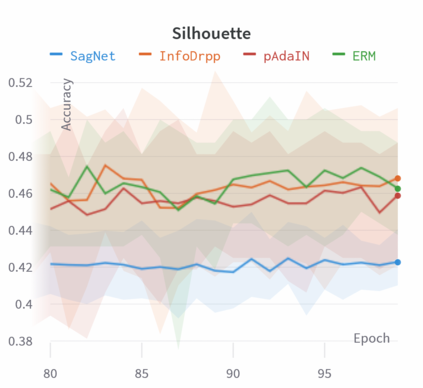

The well-documented presence of texture bias in modern convolutional neural networks has led to a plethora of algorithms that promote an emphasis on shape cues, often to support generalization to new domains. Yet, common datasets, benchmarks and general model selection strategies are missing, and there is no agreed, rigorous evaluation protocol. In this paper, we investigate difficulties and limitations when training networks with reduced texture bias. In particular, we also show that proper evaluation and meaningful comparisons between methods are not trivial. We introduce BiasBed, a testbed for texture- and style-biased training, including multiple datasets and a range of existing algorithms. It comes with an extensive evaluation protocol that includes rigorous hypothesis testing to gauge the significance of the results, despite the considerable training instability of some style bias methods. Our extensive experiments, shed new light on the need for careful, statistically founded evaluation protocols for style bias (and beyond). E.g., we find that some algorithms proposed in the literature do not significantly mitigate the impact of style bias at all. With the release of BiasBed, we hope to foster a common understanding of consistent and meaningful comparisons, and consequently faster progress towards learning methods free of texture bias. Code is available at https://github.com/D1noFuzi/BiasBed

翻译:在现代卷发神经网络中,有充分证据证明存在质谱偏见,现代卷发神经神经网络中存在有文字偏见的现象,这导致了大量的算法,这些算法促进了对形状提示的强调,往往支持对新领域的概括化。然而,缺乏共同的数据集、基准和一般模式选择战略,而且没有商定的严格评价程序。在本文件中,我们调查了在培训网络时,由于纹理偏差减少,我们调查了困难和限制。特别是,我们还表明,在方法之间进行适当评价和有意义的比较并非微不足道。我们引入了BiasBed,这是对质谱和风格偏差培训的测试,包括多个数据集和一系列现有的算法。它伴随着广泛的评估协议,其中包括严格的假设测试,以衡量结果的重要性,尽管一些风格偏差方法在培训方面相当不稳定。我们的广泛实验,揭示了需要谨慎、统计基础的对风格偏差(及以后)的评价协议。我们发现,文献中提议的一些算法并没有显著减轻风格偏见的影响。随着BasBed文本的发布,我们希望促进对AB的一致和有意义的比较方法/Babrcom的共同理解,从而更快地了解。