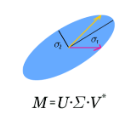

The joint bidiagonalization(JBD) process is a useful algorithm for the computation of the generalized singular value decomposition(GSVD) of a matrix pair. However, it always suffers from rounding errors, which causes the Lanczos vectors to loss their mutual orthogonality. In order to maintain some level of orthongonality, we present a semiorthogonalization strategy. Our rounding error analysis shows that the JBD process with the semiorthogonalization strategy can ensure that the convergence of the computed quantities is not affected by rounding errors and the final accuracy is high enough. Based on the semiorthogonalization strategy, we develop the joint bidiagonalization process with partial reorthogonalization(JBDPRO). In the JBDPRO algorithm, reorthogonalizations occur only when necessary, which saves a big amount of reorthogonalization work compared with the full reorthogonalization strategy. Numerical experiments illustrate our theory and algorithm.

翻译:联合多角化( JBD) 进程是计算一个矩阵配对的通用单值分解( GSVD) 的有用算法。 但是, 它总是受到四舍五入错误的影响, 导致朗索斯矢量失去双向正方。 为了保持某种水平的正方位, 我们提出了一个半方位化战略 。 我们的四舍五入错误分析显示, JBD 进程与半方位化战略可以确保计算的数量不会受到四舍五入错误的影响, 最后的精确度足够高 。 根据分解战略, 我们开发了以部分正方位化( JBDPRO) 联合的双向方位化进程 。 在 JBDPRO 算法中, 只有在必要的时候才会出现二次方位化。 这可以节省大量与完全再二次化战略相比的二次化工作。 数字实验可以说明我们的理论和算法 。