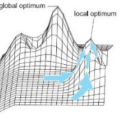

One hope when using non-elitism in evolutionary computation is that the ability to abandon the current-best solution aids leaving local optima. To improve our understanding of this mechanism, we perform a rigorous runtime analysis of a basic non-elitist evolutionary algorithm (EA), the $(\mu,\lambda)$ EA, on the most basic benchmark function with a local optimum, the jump function. We prove that for all reasonable values of the parameters and the problem, the expected runtime of the $(\mu,\lambda)$~EA is, apart from lower order terms, at least as large as the expected runtime of its elitist counterpart, the $(\mu+\lambda)$~EA (for which we conduct the first runtime analysis on jump functions to allow this comparison). Consequently, the ability of the $(\mu,\lambda)$~EA to leave local optima to inferior solutions does not lead to a runtime advantage. We complement this lower bound with an upper bound that, for broad ranges of the parameters, is identical to our lower bound apart from lower order terms. This is the first runtime result for a non-elitist algorithm on a multi-modal problem that is tight apart from lower order terms.

翻译:当在进化计算中使用非扩张性时,一种希望是放弃当前最佳解决方案的能力能够帮助离开本地奥秘。为了改进我们对这个机制的理解,我们对基本的非精英进化算法(EA)($(mu, lambda) EA)进行严格的运行时间分析,该算法($)(mu,\lambda) EA) 以最基本的基准函数为基础,具有当地最佳的跳跃功能。因此,对于参数和问题的所有合理值,我们证明,对于参数和问题,预期的( mu,\lambda) $ ~EA的运行时间,除了较低排序条件之外,至少是与其精英对应方的预期运行时间( $( mu ⁇ lambda) $( $) ~ EA( $( mu,\ lambda) $) 来进行严格的运行时间分析。 因此, $( mu,\ lambda) 美元 ~ EA 将本地opimma) 留给低级解决方案的能力不会带来运行时间上的优势。 我们对这一较低的约束加以补充, 其上限是, 范围范围与我们较低的约束, 与低级参数的比低级参数要与低级参数相同。