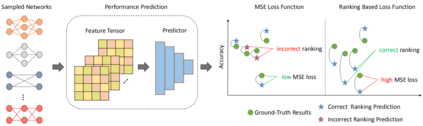

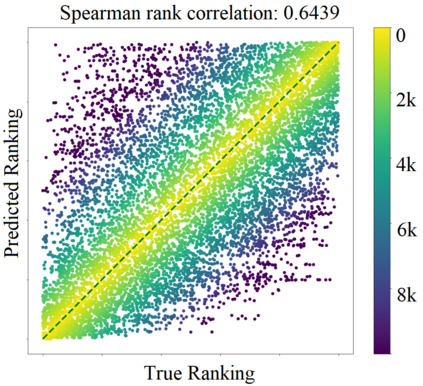

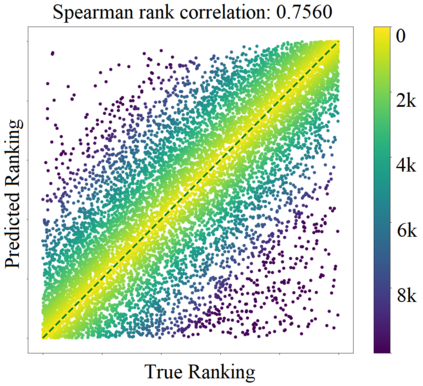

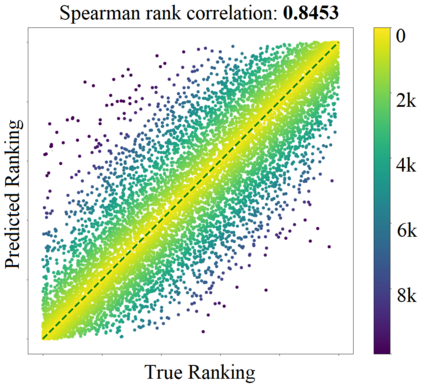

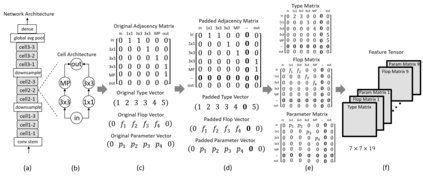

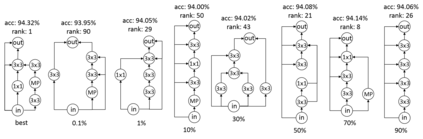

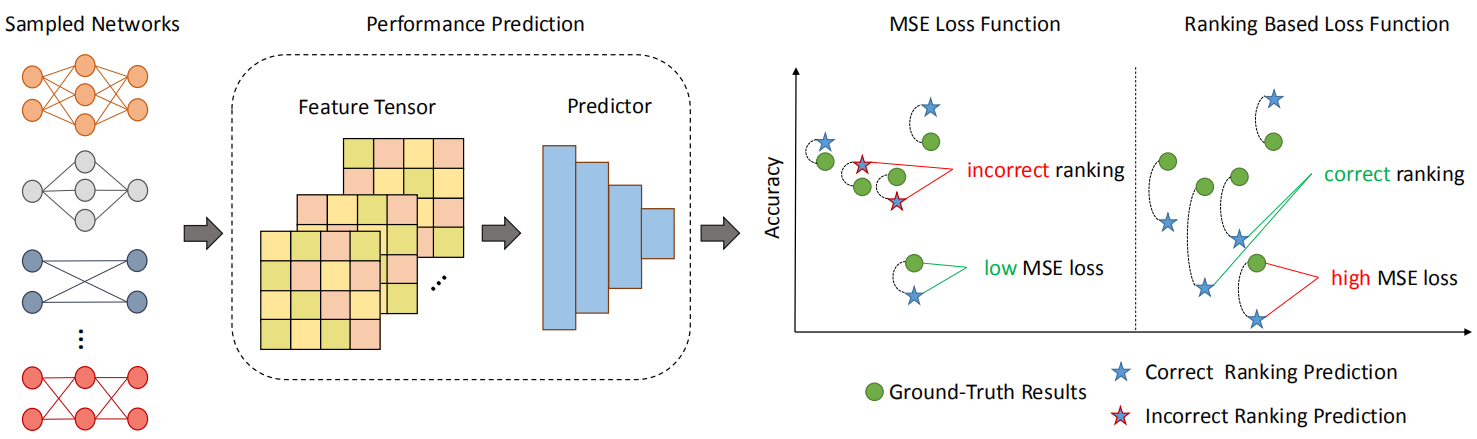

An effective and efficient architecture performance evaluation scheme is essential for the success of Neural Architecture Search (NAS). To save computational cost, most of existing NAS algorithms often train and evaluate intermediate neural architectures on a small proxy dataset with limited training epochs. But it is difficult to expect an accurate performance estimation of an architecture in such a coarse evaluation way. This paper advocates a new neural architecture evaluation scheme, which aims to determine which architecture would perform better instead of accurately predict the absolute architecture performance. Therefore, we propose a \textbf{relativistic} architecture performance predictor in NAS (ReNAS). We encode neural architectures into feature tensors, and further refining the representations with the predictor. The proposed relativistic performance predictor can be deployed in discrete searching methods to search for the desired architectures without additional evaluation. Experimental results on NAS-Bench-101 dataset suggests that, sampling 424 ($0.1\%$ of the entire search space) neural architectures and their corresponding validation performance is already enough for learning an accurate architecture performance predictor. The accuracies of our searched neural architectures on NAS-Bench-101 and NAS-Bench-201 datasets are higher than that of the state-of-the-art methods and show the priority of the proposed method.

翻译:为了节省计算成本,大多数现有的NAS算法经常在一个有限的培训时代的小型代用数据集中训练和评价中间神经结构。但很难期望以如此粗糙的评价方式准确估计一个结构的性能。本文主张一个新的神经结构评价计划,其目的是确定哪个结构将更好地运作,而不是准确预测绝对建筑绩效。因此,我们提议在NAS(RENAS)中设置一个计算成本预测器。我们将神经结构编码成特性强器,并进一步完善与预测器的表述。拟议的相对性性性能预测器可以在不进行额外评估的情况下被分散地用于搜索所需的结构。NAS-Bench-101数据集的实验结果表明,抽样424美元(整个搜索空间的0.1美元)神经结构及其相应的验证性能已经足以学习准确的结构性能预测器。我们搜索型神经结构的搜索型预测法和高级神经系统系统系统系统系统系统系统系统显示,搜索型神经系统系统系统系统系统结构的搜索方法比国家神经系统系统系统系统系统系统系统系统系统系统系统更优先的系统。