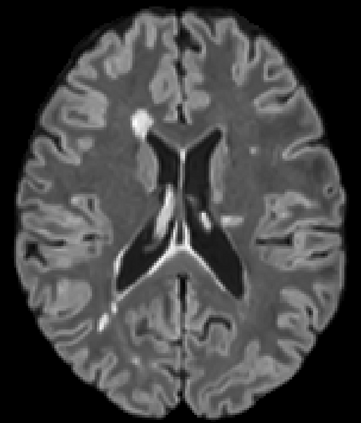

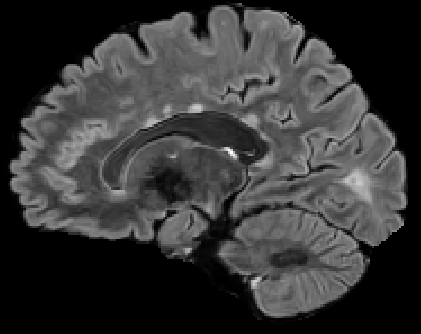

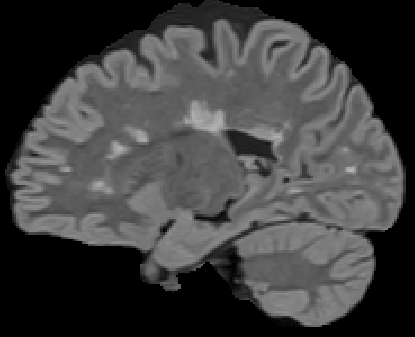

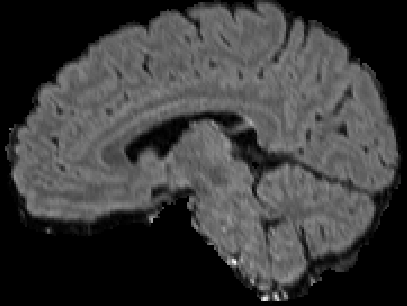

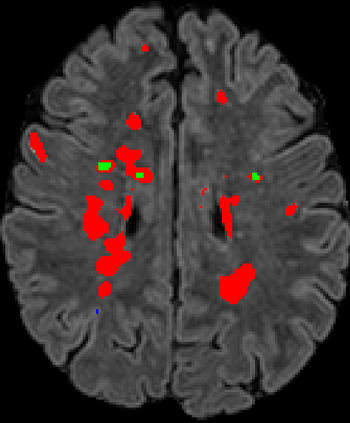

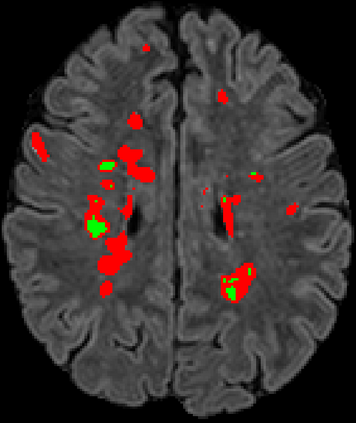

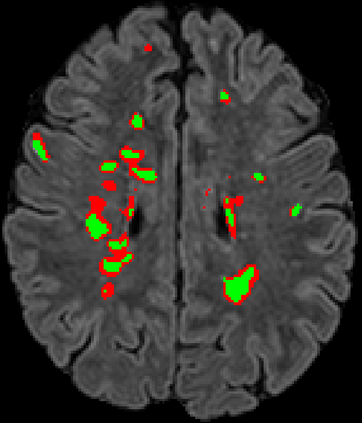

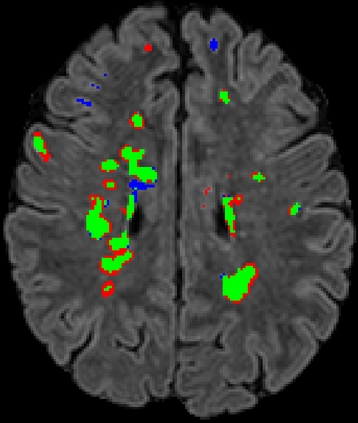

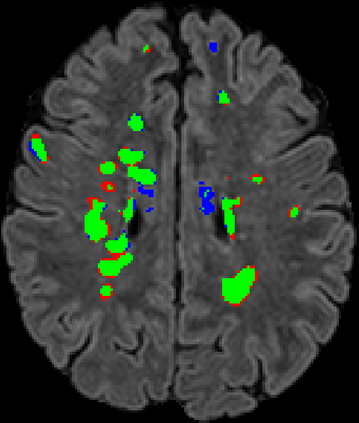

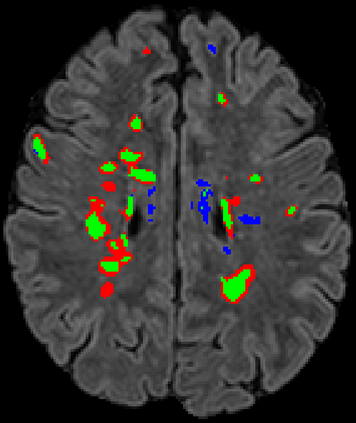

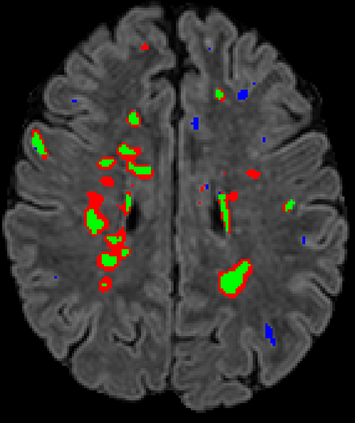

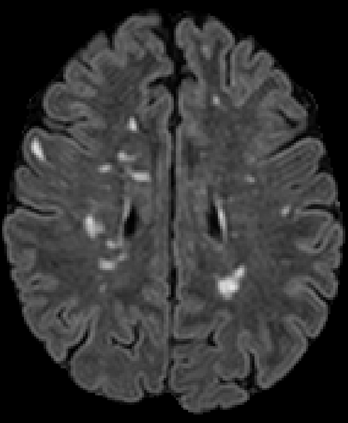

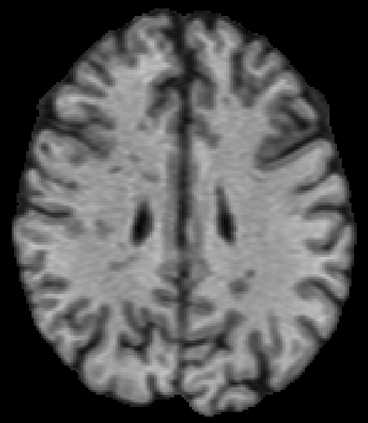

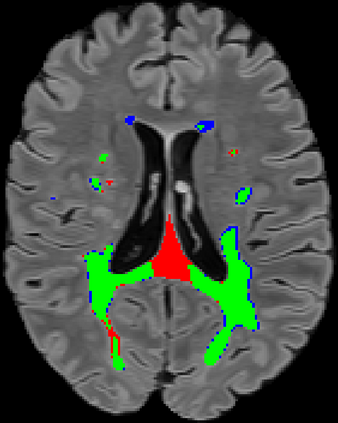

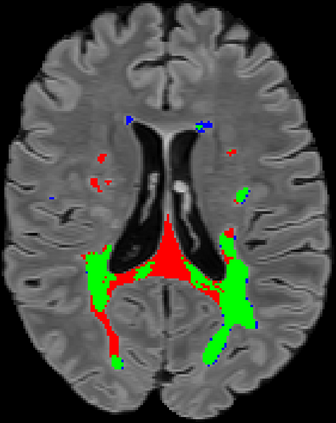

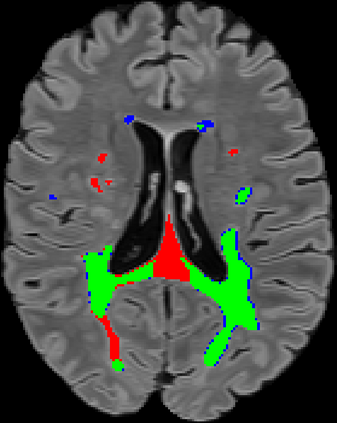

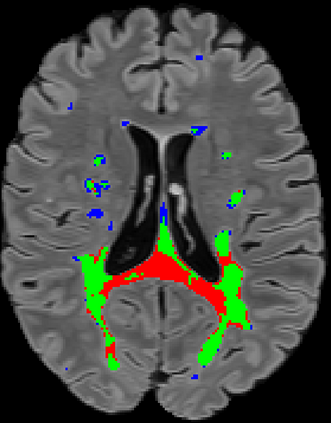

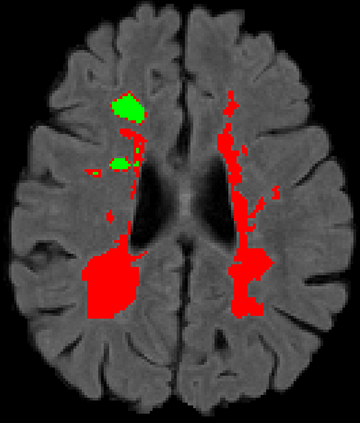

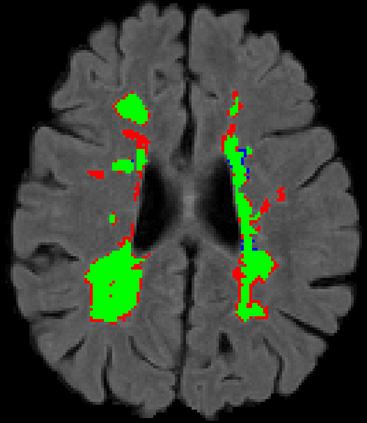

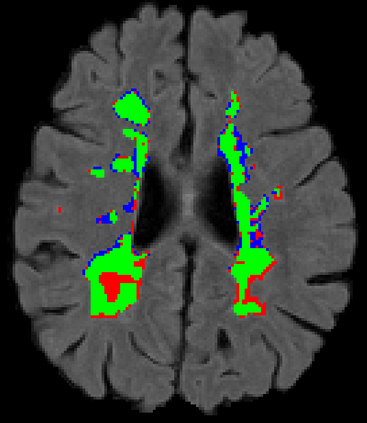

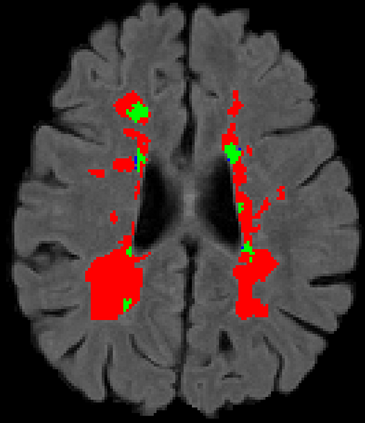

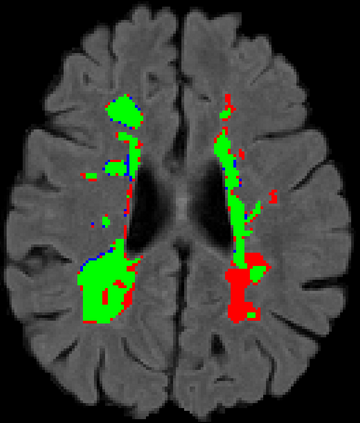

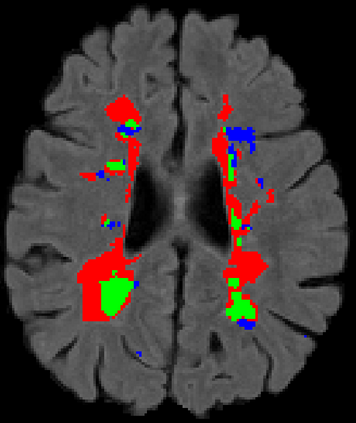

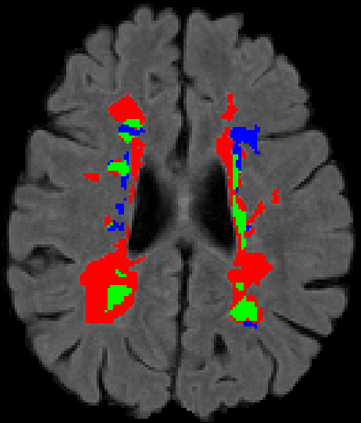

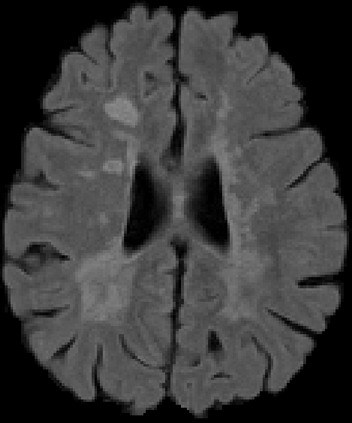

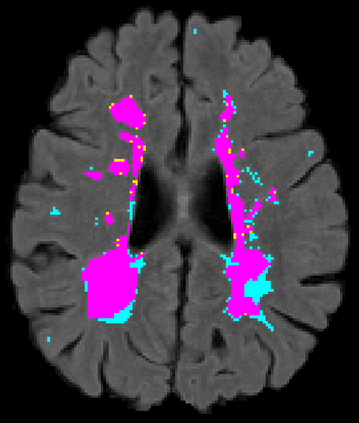

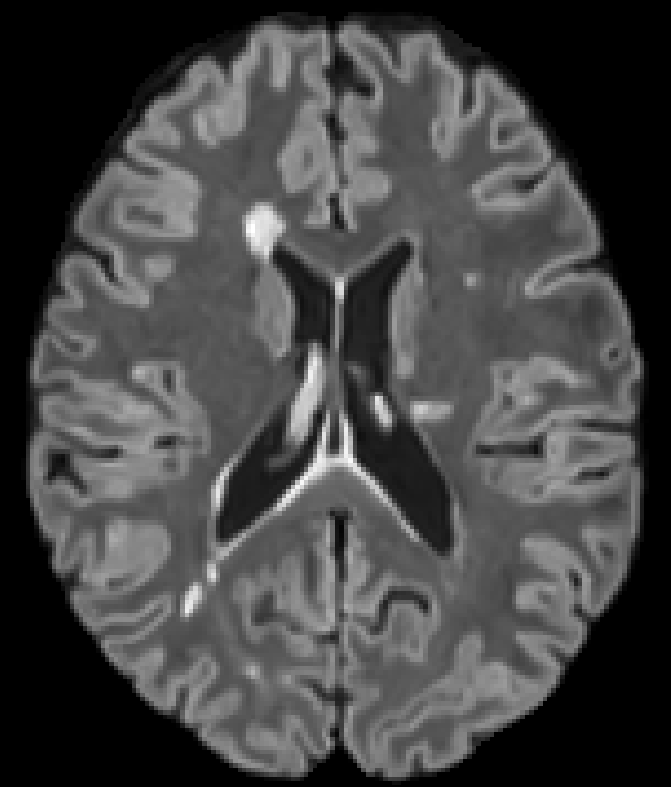

Recently, segmentation methods based on Convolutional Neural Networks (CNNs) showed promising performance in automatic Multiple Sclerosis (MS) lesions segmentation. These techniques have even outperformed human experts in controlled evaluation conditions such as Longitudinal MS Lesion Segmentation Challenge (ISBI Challenge). However state-of-the-art approaches trained to perform well on highly-controlled datasets fail to generalize on clinical data from unseen datasets. Instead of proposing another improvement of the segmentation accuracy, we propose a novel method robust to domain shift and performing well on unseen datasets, called DeepLesionBrain (DLB). This generalization property results from three main contributions. First, DLB is based on a large group of compact 3D CNNs. This spatially distributed strategy ensures a robust prediction despite the risk of generalization failure of some individual networks. Second, DLB includes a new image quality data augmentation to reduce dependency to training data specificity (e.g., acquisition protocol). Finally, to learn a more generalizable representation of MS lesions, we propose a hierarchical specialization learning (HSL). HSL is performed by pre-training a generic network over the whole brain, before using its weights as initialization to locally specialized networks. By this end, DLB learns both generic features extracted at global image level and specific features extracted at local image level. DLB generalization was validated in cross-dataset experiments on MSSEG'16, ISBI challenge, and in-house datasets. During experiments, DLB showed higher segmentation accuracy, better segmentation consistency and greater generalization performance compared to state-of-the-art methods. Therefore, DLB offers a robust framework well-suited for clinical practice.

翻译:最近,基于进化神经网络(CNNs)的分解方法显示,在自动多缩缩缩(MS)损伤分解中,在自动多缩缩缩(MS)偏移(DLB)的分解中,分解方法表现良好。这些技术甚至优于人类专家在控制的评价条件下的表现,如纵向MS Lesion分解挑战(ISBI挑战 挑战 ) 。然而,在高度控制的数据集中,经过良好表现训练的先进方法未能对临床数据进行概括化分析。我们建议采用一种新颖的方法,以稳健的方式进行域变换,并很好地表现在未知的数据集(DeepLeLeB)的分解(DLB ) 。这种概括化的特性源自三大主要贡献。首先, DLB 以大型的3DCNNC 分解(I 挑战 挑战 挑战 ) 。尽管某些个人网络存在超常态化失败的风险,但这种空间分布式战略还是确保了可靠的预测。第二,DLB 包含新的图像质量数据增强,以减少对数据特殊DL(egal 协议(e) 协议) 难度。最后,我们提议在GEGalalalalalalalalalalalal 一级进行更深入的分解(HL) 一级,在Galalalalalalalalalal) 一级,在G) 一级进行更深入的分解到G) 一级的分解,在开始学习一个通用的分解。