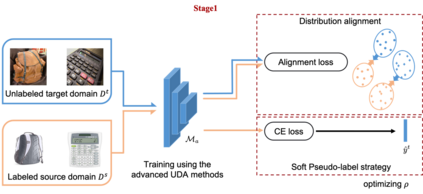

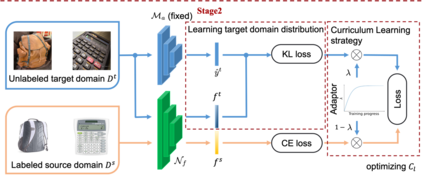

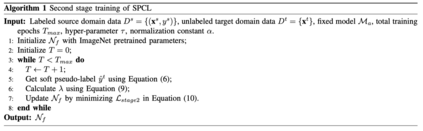

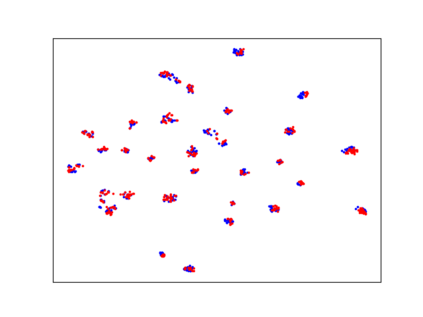

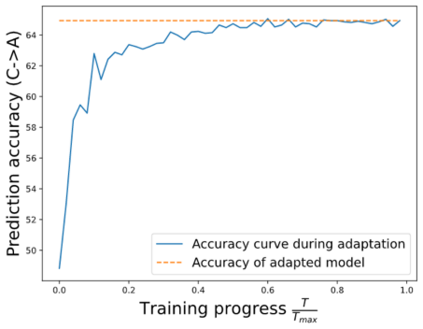

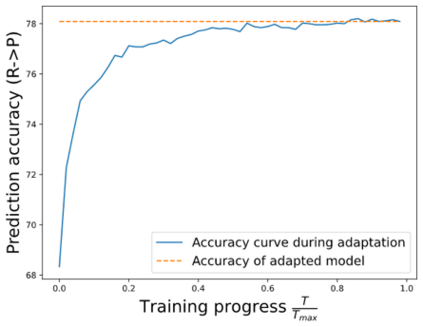

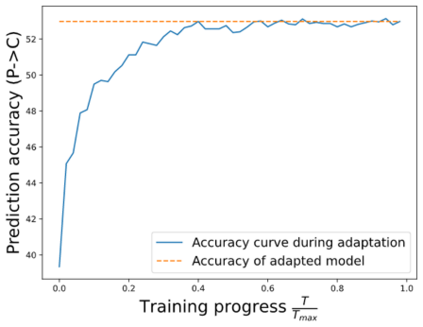

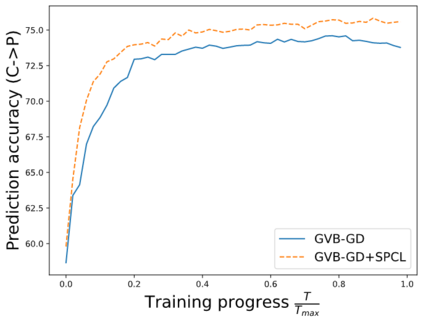

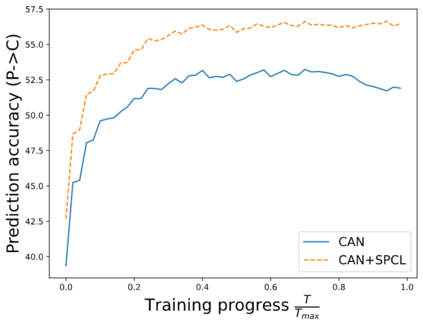

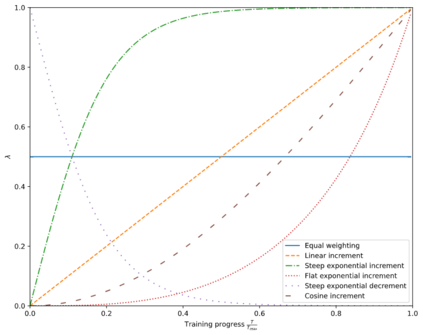

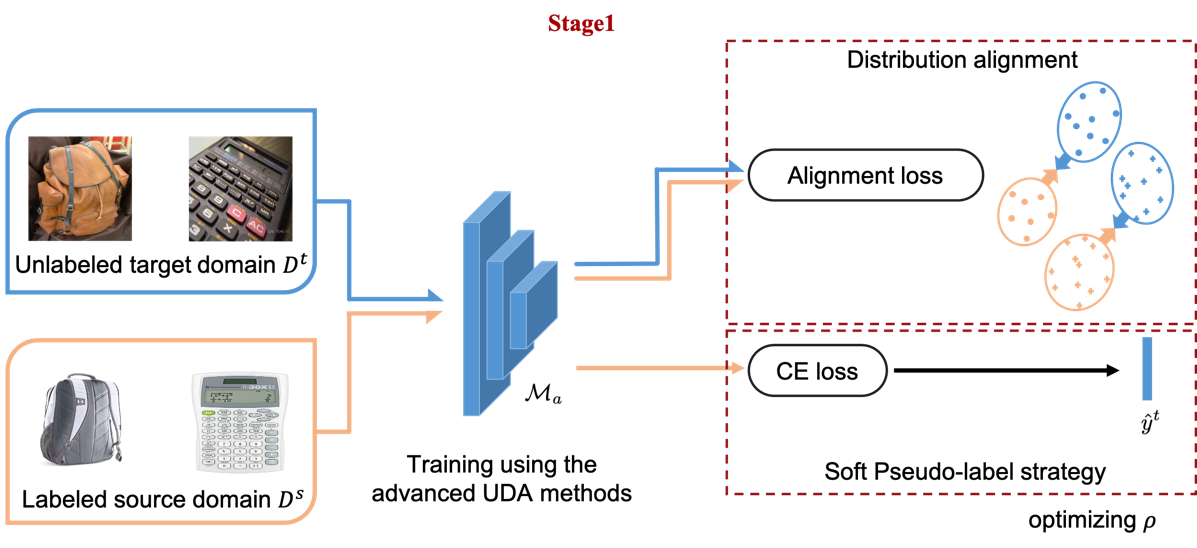

By leveraging data from a fully labeled source domain, unsupervised domain adaptation (UDA) improves classification performance on an unlabeled target domain through explicit discrepancy minimization of data distribution or adversarial learning. As an enhancement, category alignment is involved during adaptation to reinforce target feature discrimination by utilizing model prediction. However, there remain unexplored problems about pseudo-label inaccuracy incurred by wrong category predictions on target domain, and distribution deviation caused by overfitting on source domain. In this paper, we propose a model-agnostic two-stage learning framework, which greatly reduces flawed model predictions using soft pseudo-label strategy and avoids overfitting on source domain with a curriculum learning strategy. Theoretically, it successfully decreases the combined risk in the upper bound of expected error on the target domain. At the first stage, we train a model with distribution alignment-based UDA method to obtain soft semantic label on target domain with rather high confidence. To avoid overfitting on source domain, at the second stage, we propose a curriculum learning strategy to adaptively control the weighting between losses from the two domains so that the focus of the training stage is gradually shifted from source distribution to target distribution with prediction confidence boosted on the target domain. Extensive experiments on two well-known benchmark datasets validate the universal effectiveness of our proposed framework on promoting the performance of the top-ranked UDA algorithms and demonstrate its consistent superior performance.

翻译:通过利用完全标签源域的数据,无人监督的域适应(UDA)通过明确缩小数据分布的差异或对抗性学习,提高了未标记目标域的分类绩效。作为一种改进,在调整过程中涉及类别调整,利用模型预测,强化目标特征歧视。然而,在目标域错误的分类预测导致的假标签不准确以及过度配置源域造成分布偏差方面,仍然存在尚未探讨的问题。在本文件中,我们提议了一个示范性、不可知性的两阶段学习框架,通过软假标签战略,大大减少有缺陷的模型预测,避免在源域上过于适合课程学习战略。理论上,它成功地降低了目标域预期错误上限的综合风险。在第一阶段,我们用基于分配一致性的UDA方法培训一个模型,以便在目标域域上获取软的语义标签。为了避免在源域上过度配置,我们提议一个课程学习战略,以适应两个域间损失之间的加权,从而避免在课程上过度匹配源域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域内的集中,以便重点培训重点提升提高提高对提高对目标域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域内已逐渐提升已逐渐提升已逐渐提升已逐渐提高、已逐渐提升已逐渐提升已逐渐提升已逐渐提高扩大扩大扩大的交付的交付域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域域内订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订订