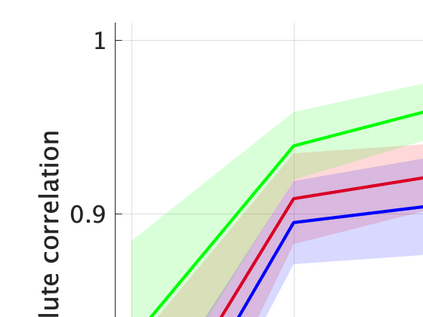

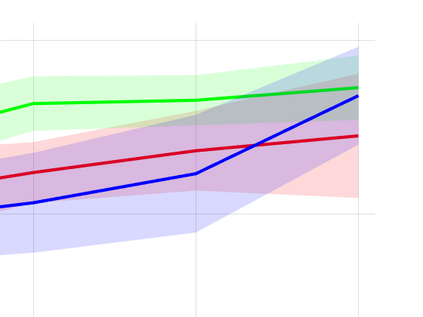

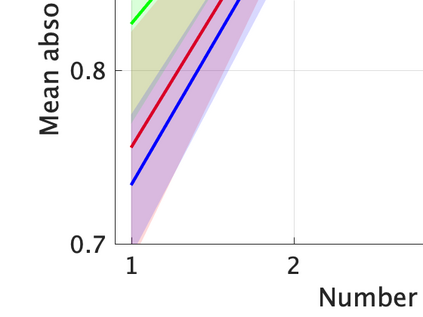

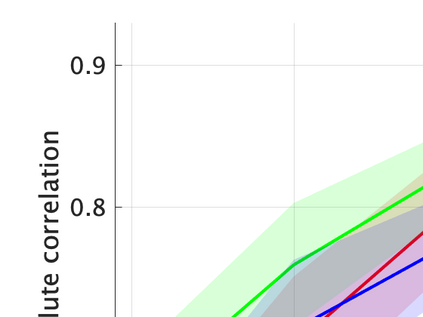

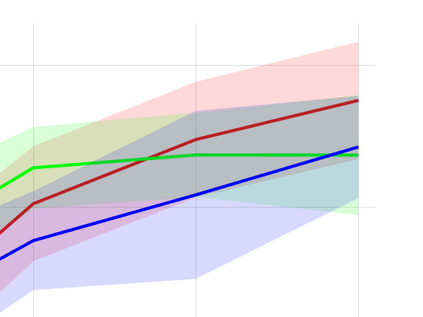

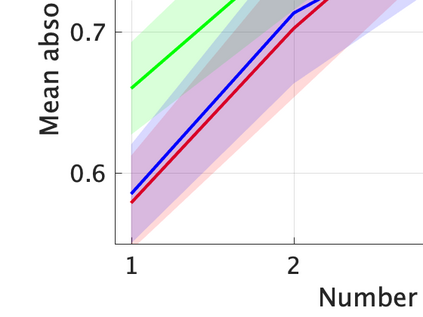

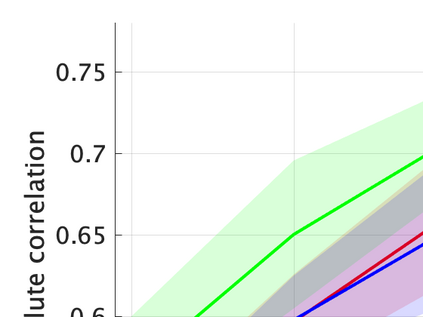

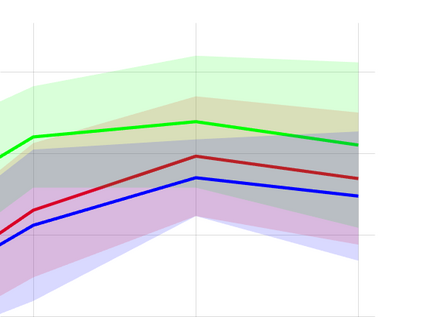

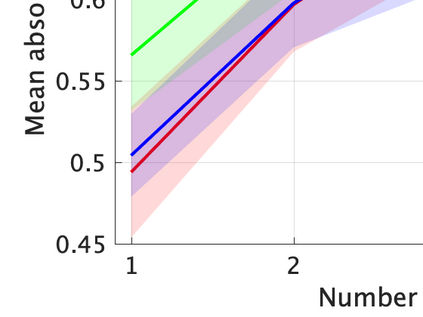

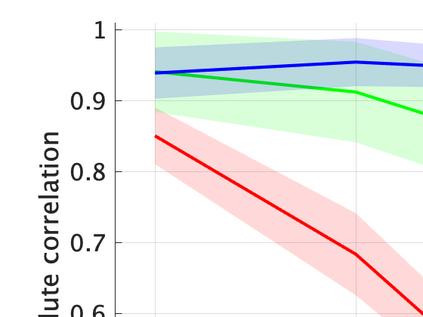

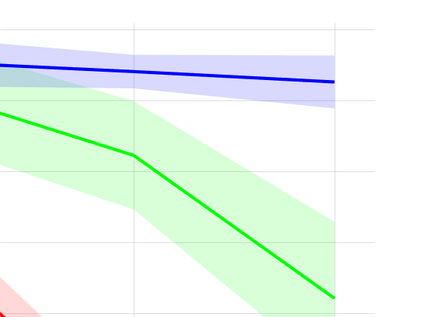

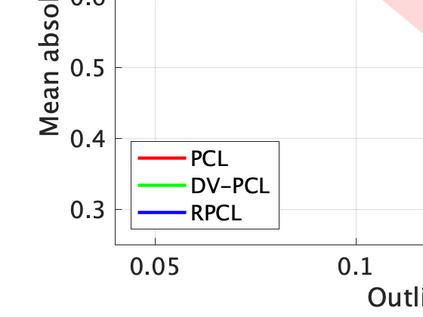

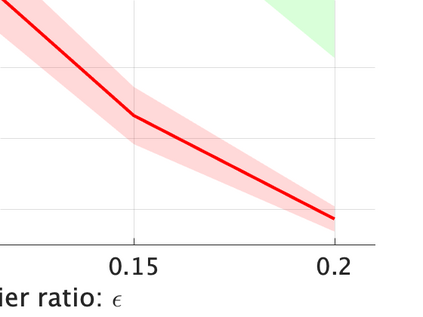

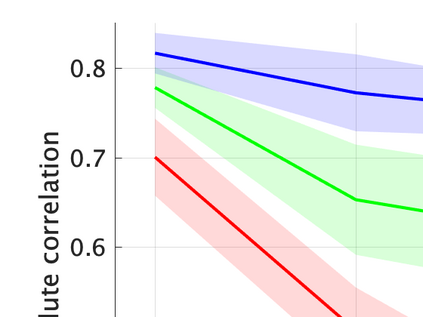

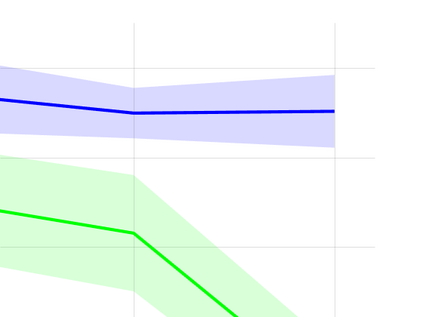

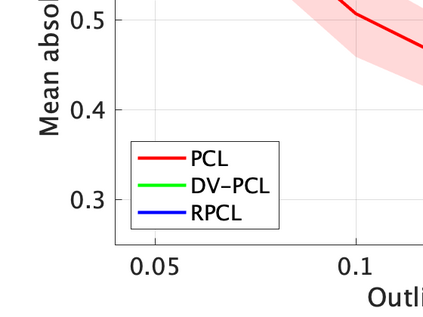

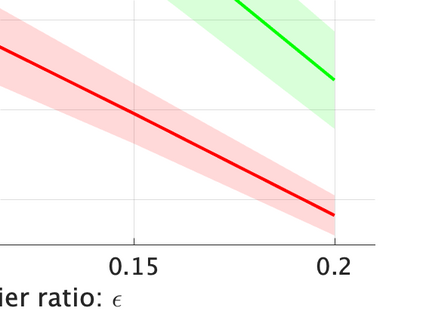

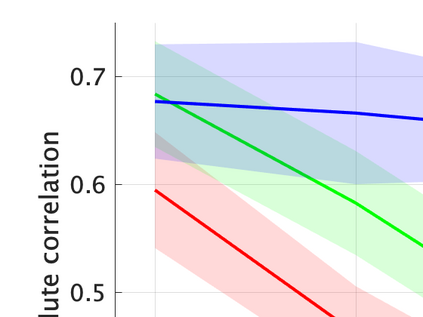

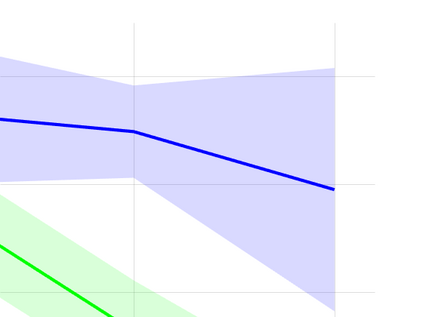

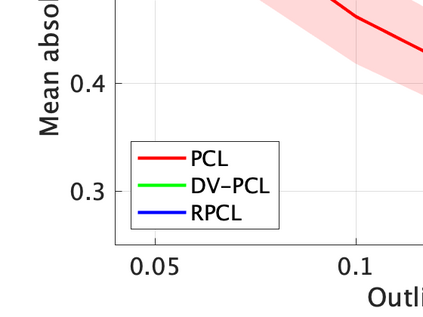

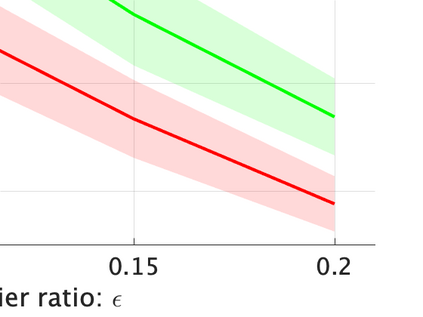

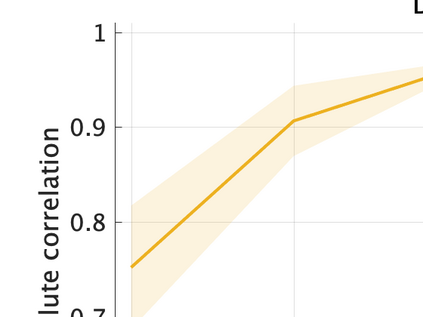

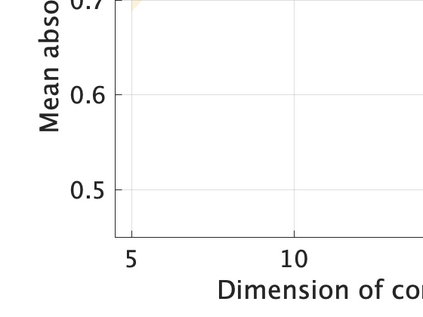

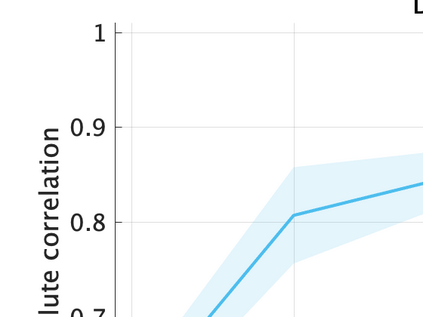

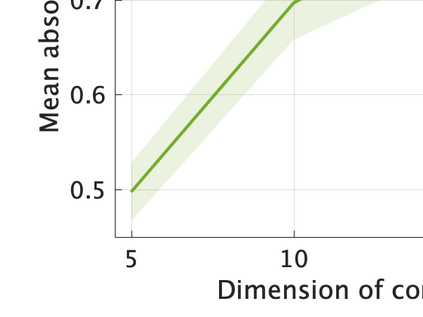

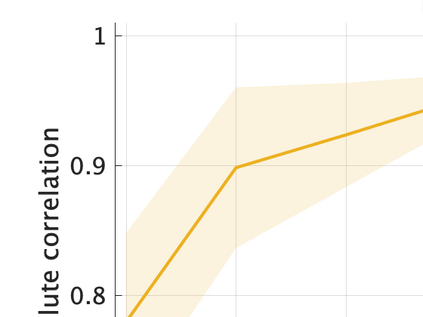

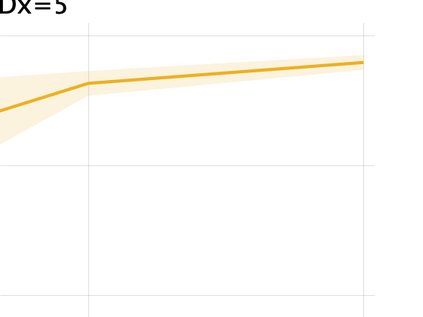

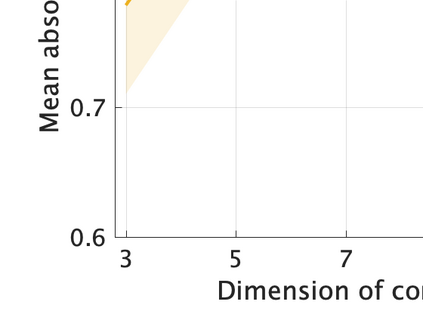

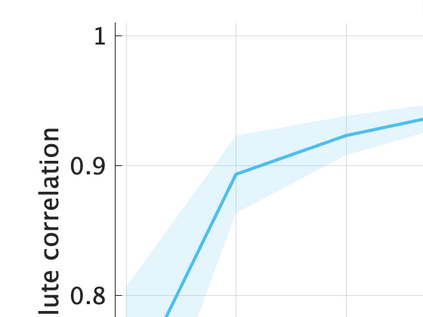

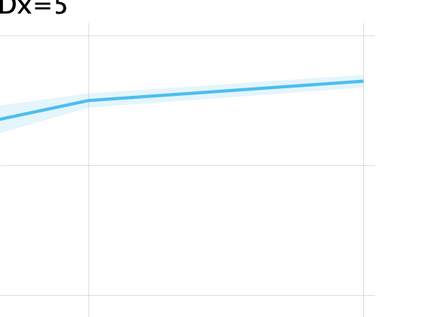

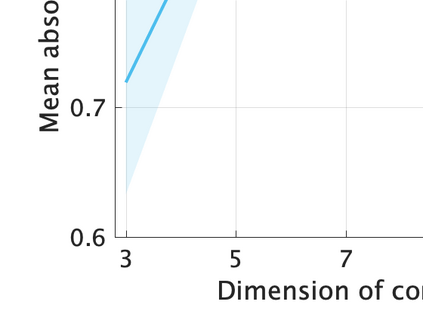

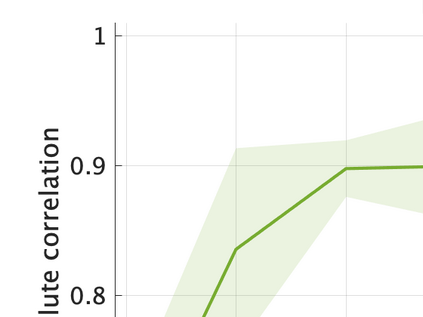

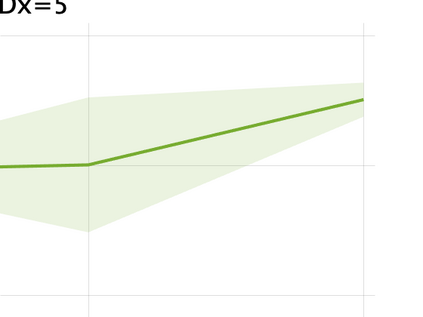

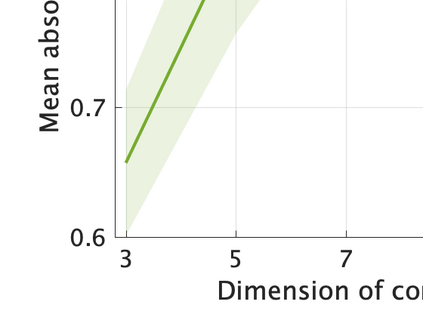

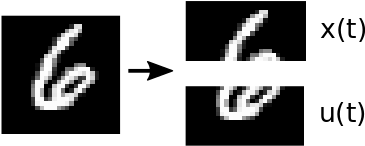

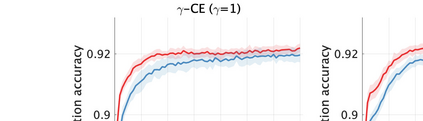

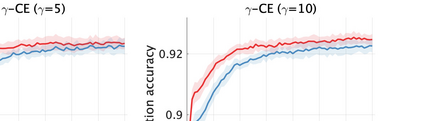

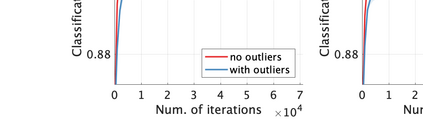

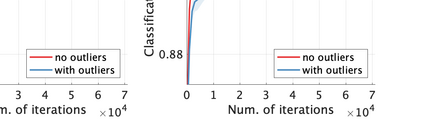

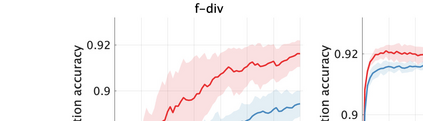

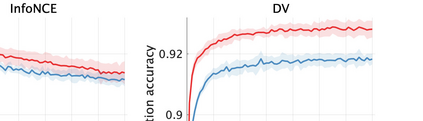

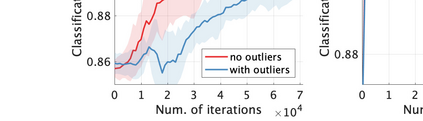

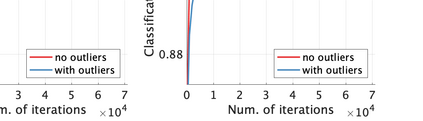

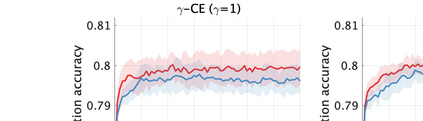

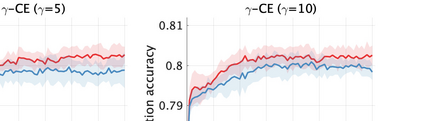

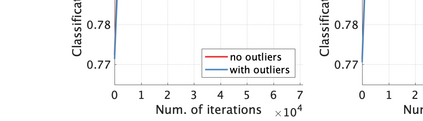

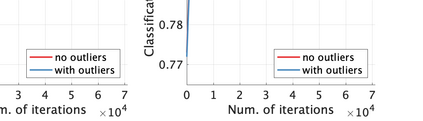

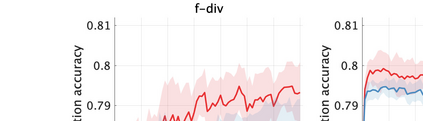

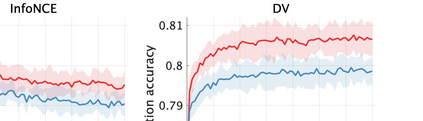

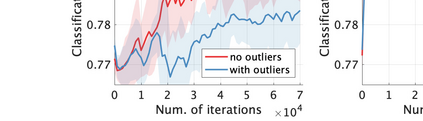

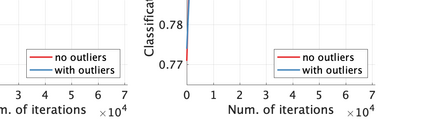

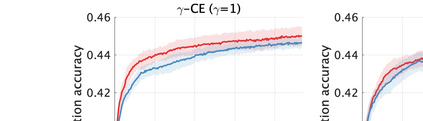

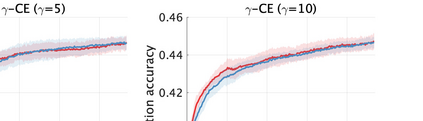

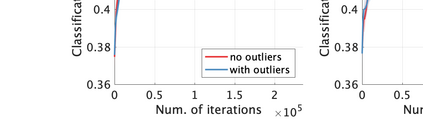

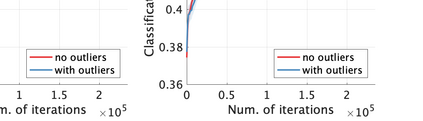

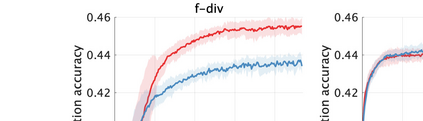

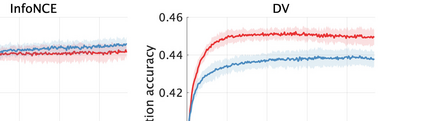

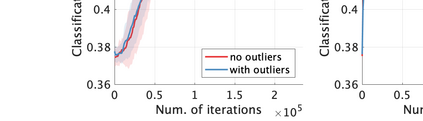

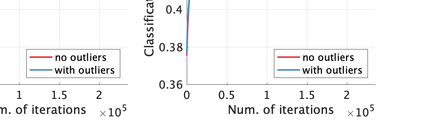

Unsupervised representation learning is one of the most important problems in machine learning. Recent promising methods are based on contrastive learning. However, contrastive learning often relies on heuristic ideas, and therefore it is not easy to understand what contrastive learning is doing. This paper emphasizes that density ratio estimation is a promising goal for unsupervised representation learning, and promotes understanding to contrastive learning. Our primal contribution is to theoretically show that density ratio estimation unifies three frameworks for unsupervised representation learning: Maximization of mutual information (MI), nonlinear independent component analysis (ICA) and a novel framework for estimation of a lower-dimensional nonlinear subspace proposed in this paper. This unified view clarifies under what conditions contrastive learning can be regarded as maximizing MI, performing nonlinear ICA or estimating the lower-dimensional nonlinear subspace in the proposed framework. Furthermore, we also make theoretical contributions in each of the three frameworks: We show that MI can be maximized through density ratio estimation under certain conditions, while our analysis for nonlinear ICA reveals a novel insight for recovery of the latent source components, which is clearly supported by numerical experiments. In addition, some theoretical conditions are also established to estimate a nonlinear subspace in the proposed framework. Based on the unified view, we propose two practical methods for unsupervised representation learning through density ratio estimation: The first method is an outlier-robust method for representation learning, while the second one is a sample-efficient nonlinear ICA method. Finally, we numerically demonstrate usefulness of the proposed methods in nonlinear ICA and through application to a downstream task for classification.

翻译:不受监督的代表学习是机器学习中最重要的问题之一。 最近有希望的方法是基于对比性学习。 但是,对比性学习往往依赖于超光速理论,因此不容易理解对比性学习正在做什么。 本文强调,密度比率估计是不受监督的代表学习的一个很有希望的目标,有助于理解对比性学习。 我们的原始贡献是理论上显示,密度比率估计统一了不受监督的代表学习的三个框架:相互信息最大化、非线性独立部分分析以及本文提出的低度非线性非线性亚空间估算新颖框架。 这种统一的观点澄清了在什么条件下对比性学习可以被视为最大程度的MI、执行非线性ICA或估计拟议框架中的较低度非线性非线性亚空间。 此外,我们在三个框架中的每一个框架都做出了理论贡献:我们表明,在某些条件下,MI可以通过密度比率估计实现最大化,而我们对非线性独立部分分析(ICA)的分析揭示了一种对潜在源组成部分的新的洞察度,而这种预测在非线性非线性非线性非线性亚的亚空间分析中得到了明确的支持。 在数字性代表性估算中, 预估中, 一种理论推算法是对一种非亚法的预估法的预估。 。在一种非数字性研究方法的理论性估算中, 在一种非级的理论性估算中,在一种理论性方法中,在一种预估测算法中, 一种理论性方法中, 一种理论性估算法在一种理论性评估法在一种方法中, 。