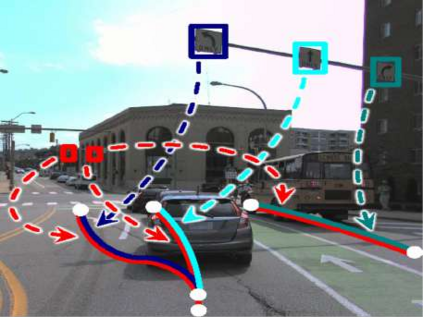

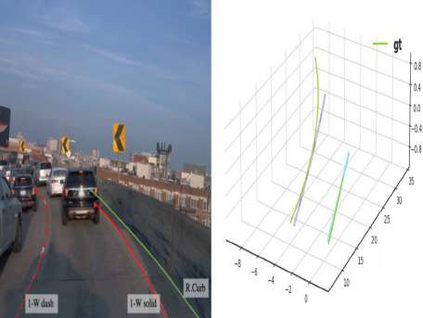

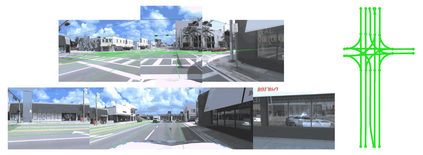

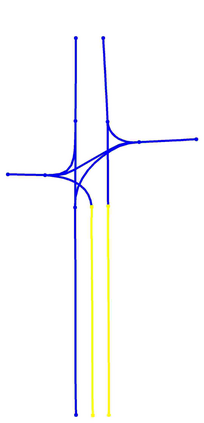

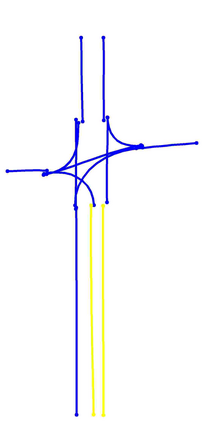

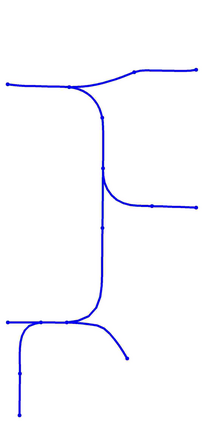

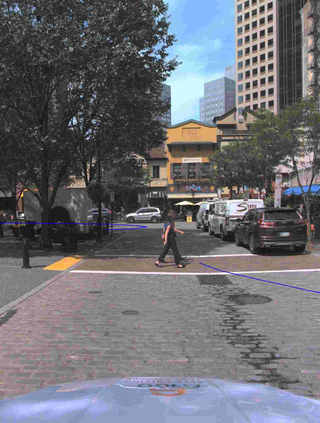

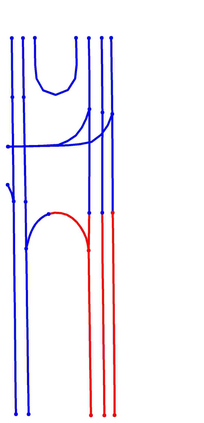

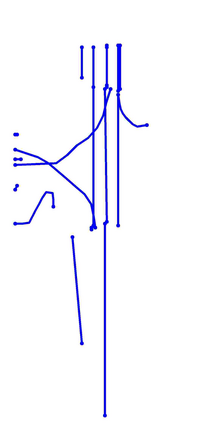

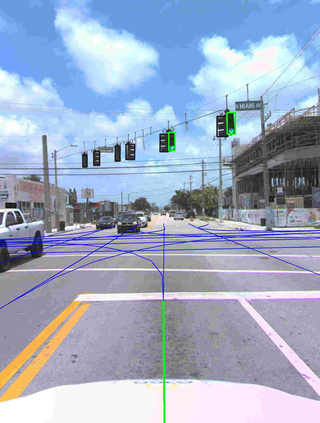

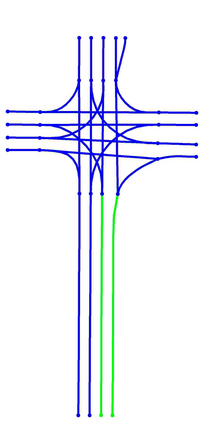

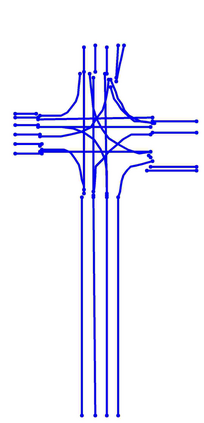

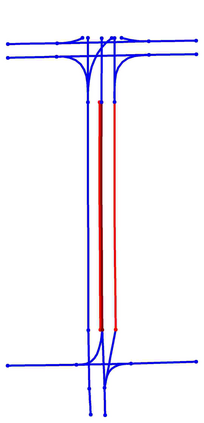

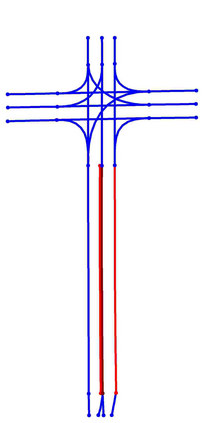

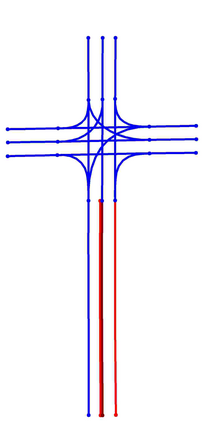

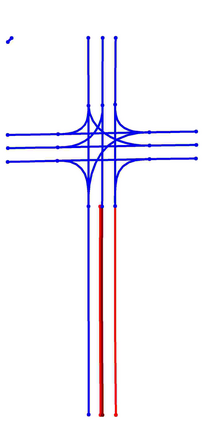

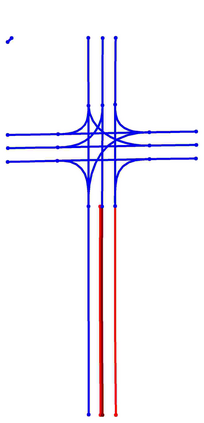

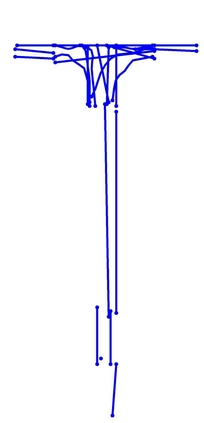

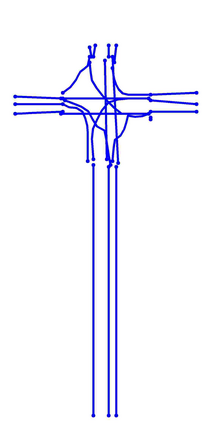

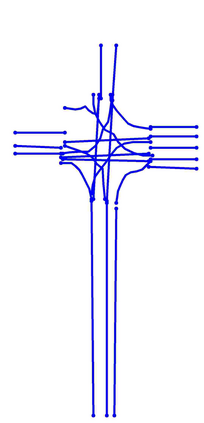

Understanding the complex traffic environment is crucial for self-driving vehicles. Existing benchmarks in autonomous driving mainly cast scene understanding as perception problems, e.g., perceiving lanelines with vanilla detection or segmentation methods. As such, we argue that the perception pipeline provides limited information for autonomous vehicles to drive in the right way, especially without the aid of high-definition (HD) map. For instance, following the wrong traffic signal at a complicated crossroad would lead to a catastrophic incident. By introducing Road Genome (OpenLane-V2), we intend to shift the community's attention and take a step further beyond perception - to the task of topology reasoning for scene structure. The goal of Road Genome is to understand the scene structure by investigating the relationship of perceived entities among traffic elements and lanes. Built on top of prevailing datasets, the newly minted benchmark comprises 2,000 sequences of multi-view images captured from diverse real-world scenarios. We annotate data with high-quality manual checks in the loop. Three subtasks compromise the gist of Road Genome, including the 3D lane detection inherited from OpenLane. We have/will host Challenges in the upcoming future at top-tiered venues.

翻译:理解复杂的交通环境对于无人驾驶汽车至关重要。现有的自动驾驶基准主要将场景理解视为感知问题,例如使用普通检测或分割方法感知车道线。因此,我们认为感知管道为自动驾驶汽车以正确的方式行驶提供了有限的信息,特别是在没有高清地图(HD)的情况下。例如,在复杂的十字路口中跟随错误的交通信号将导致灾难性事件。通过引入 Road Genome(OpenLane-V2),我们意欲转移社区的注意力并走得更远——超越感知,以探究场景结构的拓扑推理任务。 Road Genome 的目标是通过研究交通要素和车道之间的感知实体的关系来理解场景结构。新近制定的基准测试建立在现有数据集的基础上,包括从多种现实场景中捕获的2000个序列的多视图图像数据。我们在循环中使用高质量的手动检查对数据进行注释。 Road Genome 的主要任务包括从 OpenLane 继承的3D 车道检测。我们将在未来的顶级活动中举办挑战赛。