【泡泡图灵智库】视觉惯性里程计中运动冲突的检测与解决方法(ICRA)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Detection and Resolution of Motion Conflict in Visual Inertial Odometry

作者:Benzun Pious Wisely Babu, David Cyganski

, James Duckworth, Soohwan Kim

来源:ICRA2018

编译:汤文俊

审核:张国强

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——Detection and Resolution of Motion Conflict in Visual Inertial Odometry:视觉惯性里程计中运动冲突的检测与解决方法,该文章发表于ICRA2018。

本文提出了一种检测与解决视觉惯性里程计中运动冲突问题的新方法。近年来,在VO算法中结合IMU预积分来提高相机定位精度与鲁棒性成为了一种普遍做法。然而,当两个传感器模态之间出现不一致问题时,定位精度将严重下降,并产生不可逆误差。在这种情形下,有必要进行基于一套观测数据的多运动估计。但是,这将导致运动冲突问题的发生,即判定将哪些测量用于精确的自运动估计。因此,本文基于每一帧位置估计之间的差异和每一个地标的重投影误差,提出了一种运动冲突的检测方法。此外,本文还提出了一种通过消除不一致的IMU和地标测量数据来解决运动冲突的方法。最后,本文执行MC-VIO算法来同时检测和解决运动冲突问题。我们基于具有挑战性的视觉和惯性数据库,来评估MC-VIO的定量和定性性能。实验结果表明,MC-VIO算法将绝对轨迹误差和相对位姿误差的增长分别减少了80%和60%。

主要贡献

本文提出了一种MC-VIO算法,来同时检测和解决视觉里程计中的运动冲突问题。

主要贡献有:

1. 提出了运动冲突的检测方法。

2. 提出了运动冲突的解决方法。

3. 在具有挑战性的视觉惯性场景中对MC-VIO算法性能进行评估。

算法流程

运动冲突:指在装载多传感器的运动器件上,不同类型的观测量之间发生了不一致,从而导致运动估计的精度和鲁棒性下降。这和噪声对运动估计产生的影响是不同的。

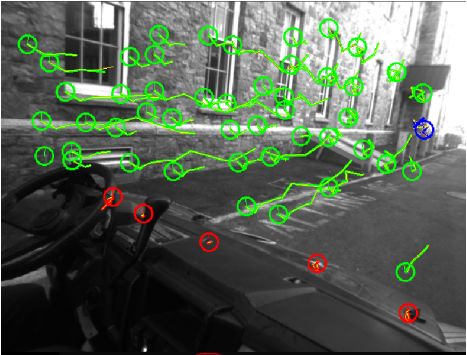

图1 运动冲突示例

汽车内的移动相机同时观测到车外的带有大光流的静态地标(绿色)和仪表盘上带有小光流的动态地标。每一组地标均会产生一个不同的自运动估计。带有噪声光流的地标(蓝色)将给出错误的自运动估计。

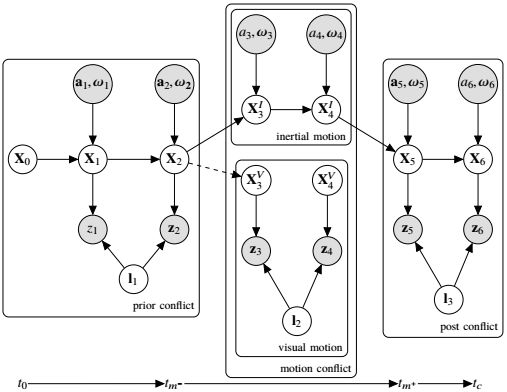

图2 VIO在运动冲突场景中的隐马尔科夫模型

图中灰色圆圈代表相机的观测量,白色圆圈代表相机位姿状态。在运动冲突发生的时段内,系统的状态(惯性组件敏感的运动状态和相机视觉敏感的运动状态)发生了交叉。

1. 检测运动冲突

检测运动冲突实质上是判别运动估计过程中哪些时段发生了状态交叉。

如果在运动估计中发生了运动冲突,那么相应的环境地标状态估计会有大的残差。以此为依据,设计一种per-landmark运动冲突检测算子。同时,根据惯性组件敏感运动状态和相机视觉敏感运动状态之间的差异,设计per-frame运动冲突检测算子。

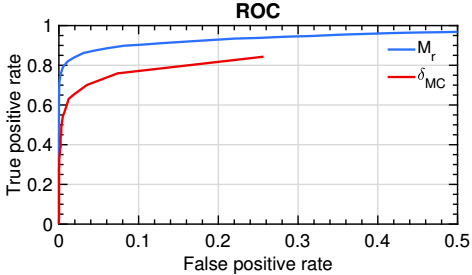

图3 运动冲突判别

当匹配率低于per-landmark运动冲突检测阈值,并且惯性组件敏感运动状态和相机视觉敏感运动状态之间的差异超过per-frame运动冲突检测阈值,则判定此时发生了运动冲突。

2. 检测运动冲突

在运动冲突发生期间,惯性组件敏感运动状态是可靠的,所以当一次运动冲突结束时,可以用惯性组件敏感运动状态来作为初始值来估计相机自运动,同时,为了防止漂移,估计结果中还必须融入相机视觉敏感状态的更新。

依据惯性测量数据和视觉测量数据之间是否完全独立和部分独立的假设,提出两种运动冲突的解决方法。

(1)IMU主导的运动冲突解决方法

假设惯性测量数据和视觉测量数据之间完全独立,在运动冲突期间完全放弃视觉估计状态。

(2)选择性的运动冲突解决方法

假设惯性测量数据和视觉测量数据之间只是部分独立,从而可以将不独立的部分视觉数据融入惯性数据。

3. MC-VIO

将运动冲突检测和解决环节组合起来执行,称其为MC-VIO算法。

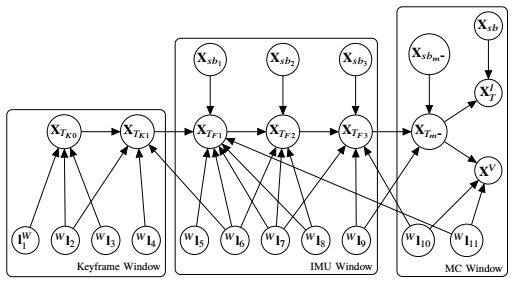

图4 三级滑动窗

在MC-VIO中,一种基于最优化的滑动窗被用于状态估计。滑动窗分为三级。在关键帧窗口,边缘化状态和对应的地标被维护;在IMU窗口,没有边缘化的连贯帧被维护; MC窗口只在运动冲突发生时维护。

主要结果

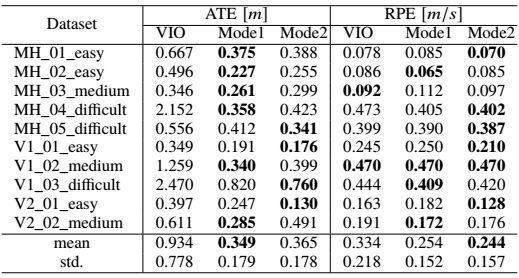

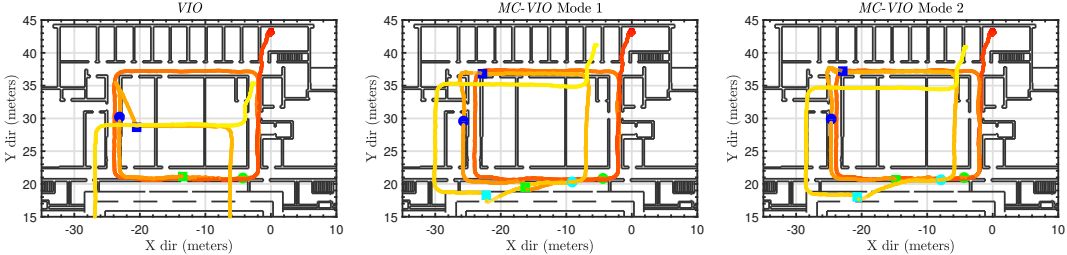

记IMU主导的MC-VIO为Mode1,选择性的MC-VIO为Mode2,将两者与文献[11]中的VIO算法进行对比试验,将绝对跟踪误差(ATE)和相对位置误差(RPE)作为定位精度的评判标准,进行定量和定性两个方面的性能评估。

1. 定量分析

表1 运动冲突EuROC数据集上的结果

在EuROC数据集中设置运动冲突,实验结果如表1所示。MC-VIO算法精度更高。

表2 无运动冲突EuROC数据集上的结果

在正常EuROC数据集中,实验结果如表2所示。MC-VIO算法和其他VIO算法精度相近,同时可以看出,运动冲突对定位精度由不良影响。

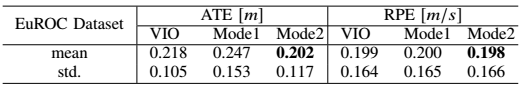

图5 运动冲突期间的ATE增长

在运动冲突期间,相对于VIO,MC-VIO的ATE增长要慢得多。

2. 定性分析

(1)视觉挑战环境

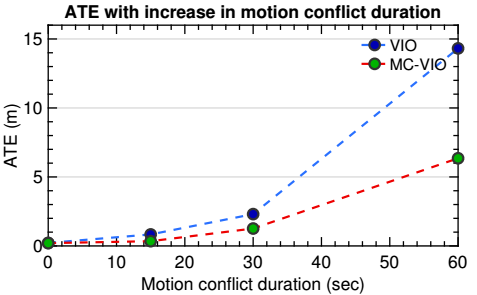

图6 手持笔记本在室内运动,运动冲突被引进

图7 视觉挑战环境结果

第一周,VIO和MC-VIO算法均成功估计,在第二周和第三周,只有MC-VIO在运动冲突期间未发生大的漂移,并且Mode2解雇更好。

(2)视觉和惯性挑战环境

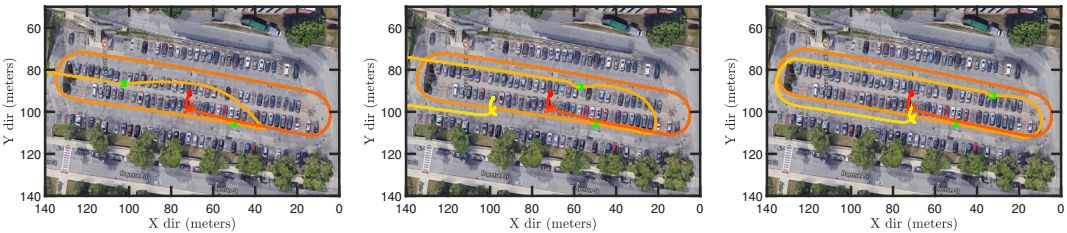

图8 视觉挑战环境结果

绕停车场运动两周,第一周没有运动冲突,在第二周中引入了运动冲突时段。

图9 视觉和惯性挑战环境结果

第一周,VIO和MC-VIO算法均成功估计,在第二周,只有MC-VIO在运动冲突期间未发生大的漂移,并且Mode2解雇更好。

Abstract

In this paper, we present a novel method to detect and resolve motion conflicts in visual-inertial odometry. Recently, it has been common to integrate an IMU sensor with visual odometry in order to improve localization accuracy and robustness. However, when a disagreement between the two sensor modalities occurs, the localization accuracy reduces drastically and leads to irreversible errors. In such conditions, multiple motion estimates based on the set of observations used are possible. This creates a conflict (motion conflict) in determining which observations to use for accurate ego-motion estimation. Therefore, we present a method to detect motion conflicts based on per-frame positional estimate discrepancy and per-landmark reprojection errors. Additionally, we also present a method to resolve motion conflicts by eliminating inconsistent IMU and landmark measurements. Finally, we implement Motion Conflict aware Visual Inertial Odometry (MCVIO) by combining both detection and resolution of motion conflicts. We perform quantitative and qualitative evaluation of MC-VIO on visually and inertially challenging datasets. Experimental results indicate that the MC-VIO algorithm reduces the increase in absolute trajectory error by 80% and the relative pose error by 60% for scenes with motion conflict, in comparison to the state-of-the-art reference VIO algorithm.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com