【泡泡一分钟】基于级联特征网络的RBG-D图像语义分割(ICCV-2017)

每天一分钟,带你读遍机器人顶级会议文章

标题:Cascaded Feature Network for Semantic Segmentation of RGB-D Images

作者:Di Lin, Guangyong Chen, Daniel Cohen-Or, Pheng-Ann Heng, Hui Huang

来源:International Conference on Computer Vision (ICCV 2017)

编译:杨雨生

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

全卷积网络已经被成功应用在RGB图像表示的场景下进行语义分割。不难理解当图像包含深度通道时,可以对场景中的几何信息有更多的理解。但目前的问题在于如何利用这额外的信息,并提高语义分割的性能。

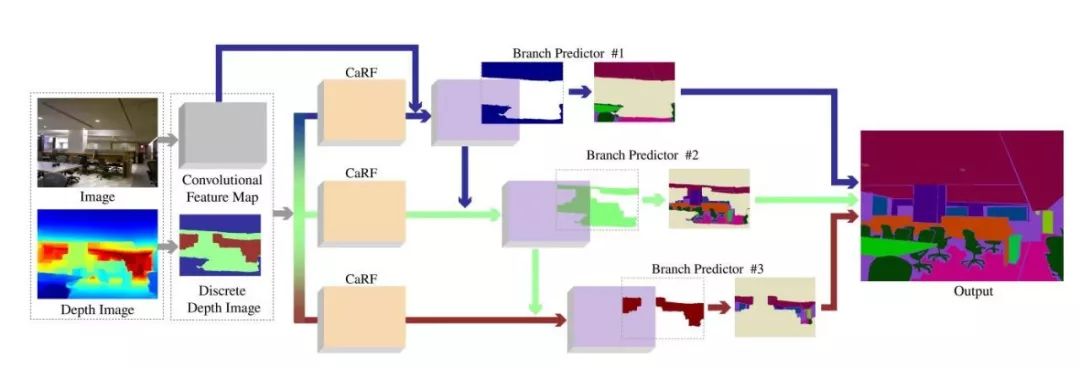

在本文中,作者提出一种多分支神经网络,用于分割RGB-D图像。作者利用图像的深度信息,将图像划分成多个层,每一个层中的对象、场景具有相同的视觉特征或所谓的“场景分辨率”(scene-resolution)。作者引入了上下文感知接受域(CaRF)的概念,从而更好的控制学习到的特征的相关上下文信息。采用CaRF的方法,网络的每一个分支对相对近似的场景分辨率进行语义分割,从而产生更易于学习的集中区域。此外,作者的网络中特征是级联的,网络中一个分支的特征可以增强相邻分支的特征。作者验证了这种特征之间的级联可以丰富每一条分支之间的上下文信息,从而提升了整体性能。作者在两个公开数据集上进行了测试,所提出的算法优于现有的方法。

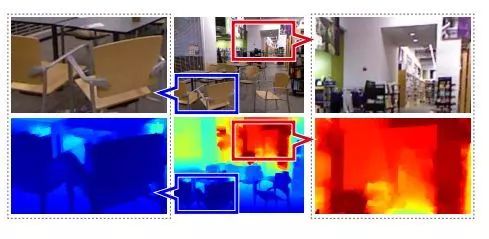

图1 上图的例子显示了图像的深度与场景分辨率的关系,图中较近的区域(蓝色矩形圈出区域)场景的分辨率较高,编者理解即较近的区域中的语义对象,包含更多的像素,比如蓝色区域中大部分的像素都是椅子的一部分,图中较远的区域,场景分辨率较低,比如红色区域中的书架,只占据图像很少一部分像素。

图2 上图是作者提出的网络的示意图。最后的输出结果是所有分支预测结果的结合。

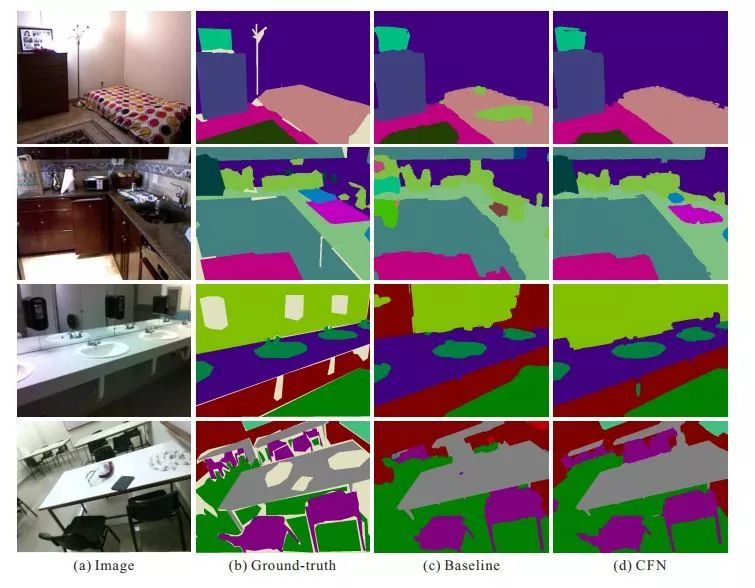

图3 上图是作者算法的一些实验结果。

Abstract

Fully convolutional network (FCN) has been successfully applied in semantic segmentation of scenes represented with RGB images. Images augmented with depth channel provide more understanding of the geometric information of the scene in the image. The question is how to best exploit this additional information to improve the segmentation performance. In this paper, we present a neural network with multiple branches for segmenting RGB-D images. Our approach is to use the available depth to split the image into layers with common visual characteristic of objects/scenes, or common“scene-resolution”. We introduce context-aware receptive field (CaRF) which provides a better control on the relevant contextual information of the learned features. Equipped with CaRF, each branch of the network semantically segments relevant similar scene-resolution, leading to a more focused domain which is easier to learn. Furthermore, our network is cascaded with features from one branch augmenting the features of adjacent branch. We show that such cascading of features enriches the contextual information of each branch and enhances the overall performance. The accuracy that our network achieves outperforms the stateof-the-art methods on two public datasets.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com