【泡泡一分钟】无监督域适应的张量表示方法(ICCV2017-58)

每天一分钟,带你读遍机器人顶级会议文章

标题:When Unsupervised Domain Adaptation Meets Tensor Representations

作者:Hao Lu, Lei Zhang, Zhiguo Cao, Wei Wei, Ke Xian, Chunhua Shen, Anton van den Hengel

来源:International Conference on Computer Vision (ICCV 2017)

播音员:格子

编译:Fei 周平(63)

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

域适应(DA)允许应用机器学习方法训练一个分布中采样的数据,并将其应用于另一个分布中采样的数据。因此,这种方法的应用具有十分重要的现实意义。

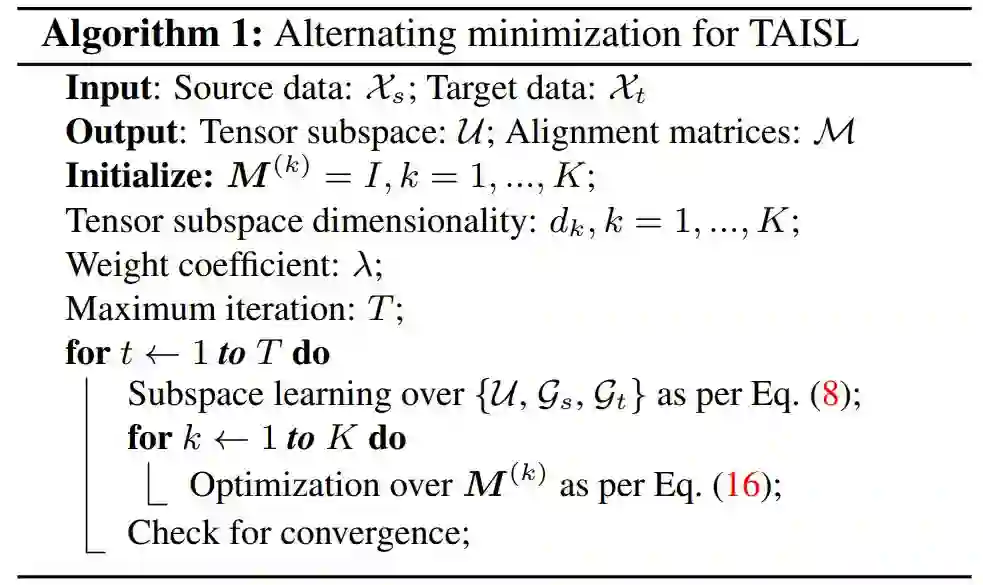

尽管在计算机视觉中广泛使用张量表示来捕捉影响数据的多线性关系,但大多数现有的DA方法仅适用于向量。这使许多问题中的重要结构得不到很好地反映和维护。因此,本文提出了一种基于学习的方法来直接调整源域和目标域的张量表示,而不需要矢量化。特别地,引入了一组对齐矩阵,将两个域的张量表示形式对应到不变张量子空间中。将这些对齐矩阵和张量子空间建模为一个联合优化问题,并利用所提出的交替最小化方案对数据进行自适应地学习。

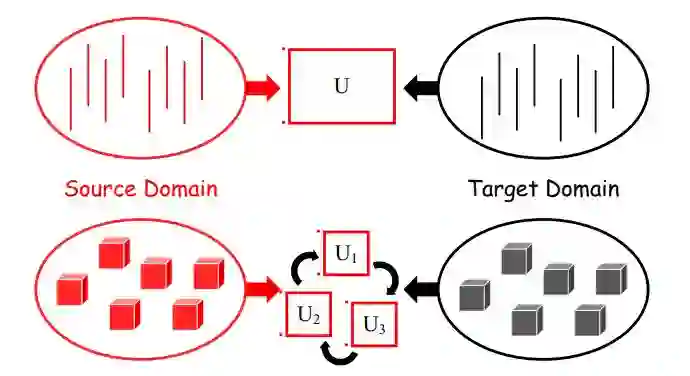

图1 向量子空间(上)和张量子空间(下)

以三阶(3种模式)张量为例。与向量子空间相比,张量子空间由一组子空间组成,每个子空间分别描述了一种模式。高阶张量模型为我们提供了一个研究多重交互性和耦合性的机会,可以捕捉域之间的共性和差异。

广泛的实验表明,文中方法能保留源域的判别能力,抵抗标签噪声的影响,并可以应用于小样本问题,甚至是一次性完成的DA问题。结果表明,本文的方法在效能和效率上都优于跨域视觉识别的技术,特别是应用到CNN的DA问题时,它的表现明显优于其他方法。

具体的算法推导过程以及实验结果请参见原文

论文源码:https://github.com/poppinace/TAISL

Abstract

Domain adaption (DA) allows machine learning methods trained on data sampled from one distribution to be applied to data sampled from another. It is thus of great practical importance to the application of such methods. Despite the fact that tensor representations are widely used in Computer Vision to capture multi-linear relationships that affect the data, most existing DA methods are applicable to vectors only. This renders them incapable of reflecting and preserving important structure in many problems. We thus propose here a learning-based method to adapt the source and target tensor representations directly, without vectorization. In particular, a set of alignment matrices is introduced to align the tensor representations from both domains into the invariant tensor subspace. These alignment matrices and the tensor subspace are modeled as a joint optimization problem and can be learned adaptively from the data using the proposed alternative minimization scheme. Extensive experiments show that our approach is capable of preserving the discriminative power of the source domain, of resisting the effects of label noise, and works effectively for small sample sizes, and even one-shot DA. We show that our method outperforms the state-of-the-art on the task of cross-domain visual recognition in both efficacy and efficiency, and particularly that it outperforms all comparators when applied to DA of the convolutional activations of deep convolutional networks.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com