博客 | 总结+paper分享 | 任务型对话中的跨领域&个性化&迁移学习

本文原载于微信公众号:AI部落联盟(AI_Tribe),AI研习社经授权转载。欢迎关注 AI部落联盟 微信公众号、知乎专栏 AI部落、及 AI研习社博客专栏。

社长提醒:本文的相关链接请点击文末【阅读原文】进行查看

1.迁移学习

什么是迁移学习? 人们利用之前的经验和知识进行推理和学习的能力。一个系统将别的相关领域中的知识应用到本领域中的学习模式。

1.1为何需要迁移学习?

1.1.1 目标领域的训练数据太少,导致效果不佳甚至过拟合;

1.1.2 很多情况下,很多已有模型只需要fine-tuning就可以用,从头训练费时费力,甚至还不讨好;

1.1.3迁移学习可以可以做多任务多目标的学习;

另外从模型角度说下迁移学习的好处:

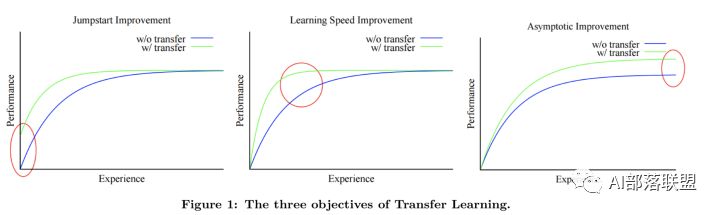

Lisa Torrey和Jude Shavlik在迁移学习的章节中描述了使用迁移学习的三个好处:

1.更高的起点。源模型的初始技能比其它模型要高。

2.更高的提升效率。训练源模型过程中提升技能的效率比其它模型要高。

3.较高的渐近线。训练好的模型的融合技能比其它模型要好。

1.2 迁移学习的分类

1.2.1 按特征空间分:同构迁移学习、异构迁移学习

1.2.2 按transfer方法分:Model-based、Feature-based、Instance-based、Relation-based。

1.2.3 按场景分:归纳迁移、直推迁移、无监督迁移。

1.3 迁移学习跟机器学习的比较

1.3.1 机器学习需要train data 和test data有相同数据分布,如果数据分布不同,最终结果可能是灾难式的,可能一点不亚于特征选择的重要性(决定任务的上限,而模型选择只是无限逼近于这个上限);而迁移学习不需要train data 和test data有相同数据分布,相反可能很多时候数据分布是不同的。

1.3.2 遇到新任务时,机器学习需要重新建模和训练;迁移学习可以复用之前的建模和训练。

1.3.3 机器学习需要有足够数据;迁移学习不一定需要有足够数据。

2.任务型对话中为啥需要迁移学习

2.1 目前任务型对话的标准数据集个数比较少,而且每个数据集的数据量非常非常小,而任务型对话中涉及到的领域远远大于目前数据集包含的领域个数,这就导致了很多目标领域数据非常有限;

2.2 任务型对话中的数据标注非常的费时费力,一个可能的思路是复用已经标注好数据的其他领域训练的模型;

2.3 任务型对话中很多模型都是用了神经网络,训练时间较长,如果每次都从头训练的话,得不偿失;

3.迁移学习在任务型对话中的应用

迁移学习在任务型对话中的可能应用包括:跨领域(系统角度的迁移)、个性化(用户角度的迁移)、跨语言(数据角度的迁移)等。目前跨领域和个性化角度都有一些不错的工作,而跨语言方面的工作我看到的相对较少,如果有人了解,欢迎告知。

下面分别介绍一下迁移学习在任务型对话系统的不同模块的应用方式:

3.1 迁移学习在SLU中的用法:

3.1.1 Instance based transfer for SLU

用源域和目标域分布之间的KL散度对目标域模型进行规则化。

Multitask learning for spoken language understanding.

3.1.2 Model adaptation for SLU

在域之间自动映射相似的classes,并在域之间传递类似的instances。

Model adaptation for spoken language understanding

3.1.3 Parameter transfer

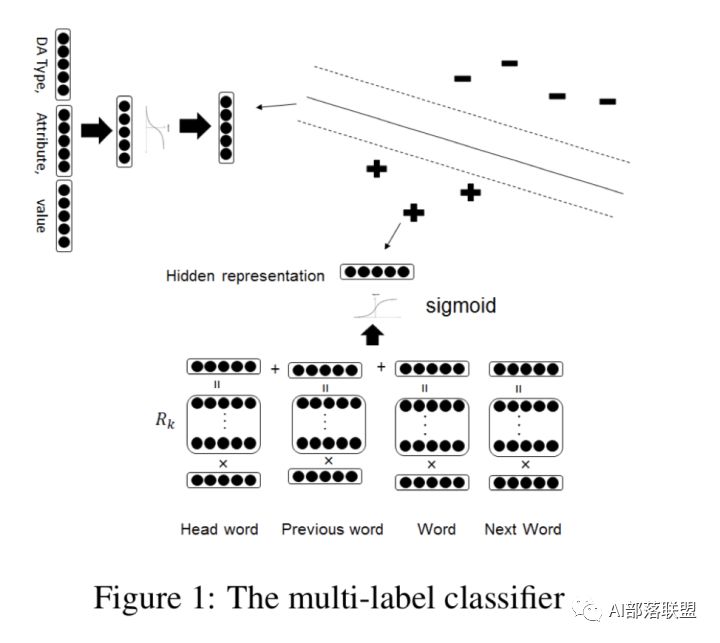

使用词嵌入向量和相似标签分类器之间的参数共享,相似的分类器具有相似的超平面。

A Model of Zero-Shot Learning of Spoken Language Understanding

3.2 迁移学习在DST中的用法:

3.2.1 Feature based transfer for DST

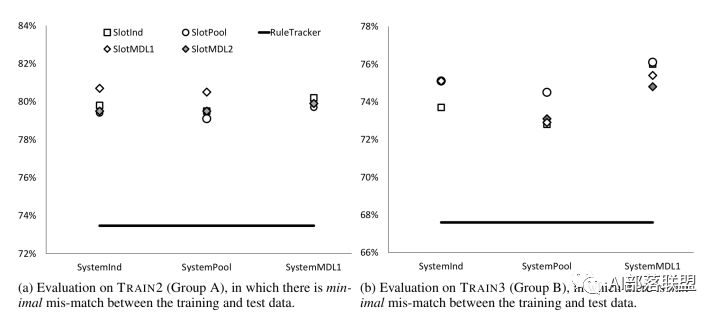

Multi-domain learning and generalization in dialog state tracking

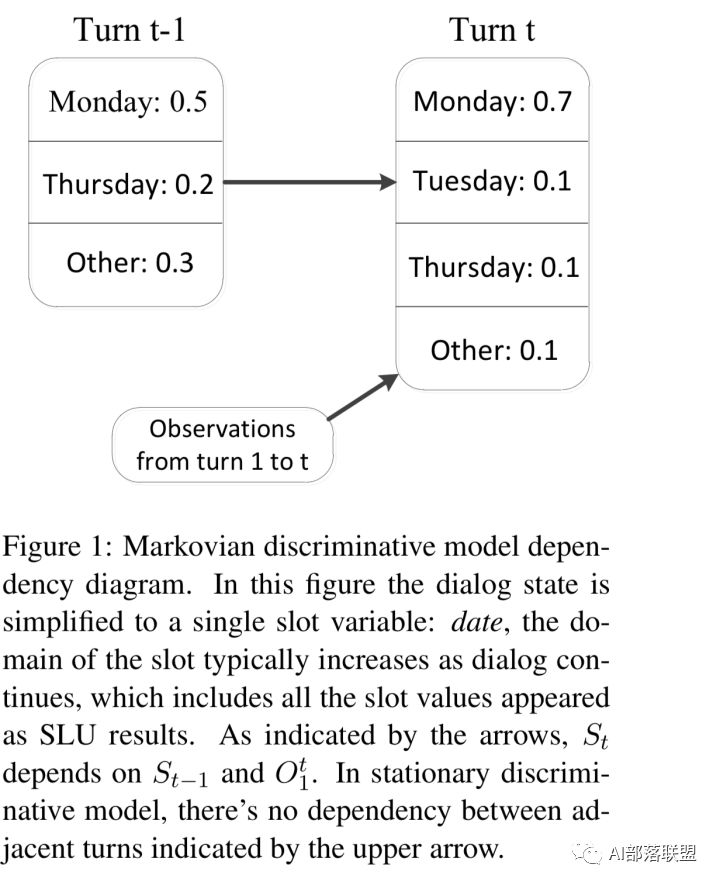

Markovian discriminative modeling for cross-domain dialog state tracking

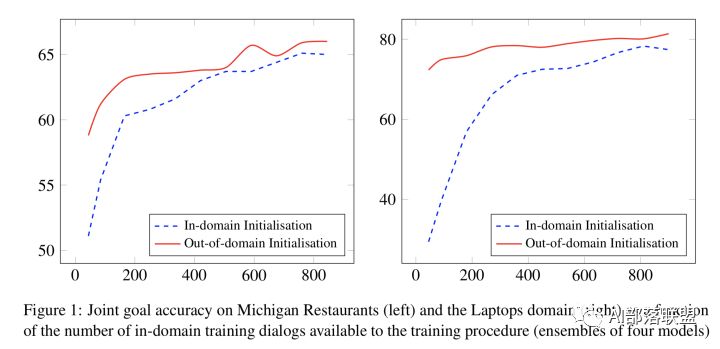

3.2.2 Model based transfer for DST

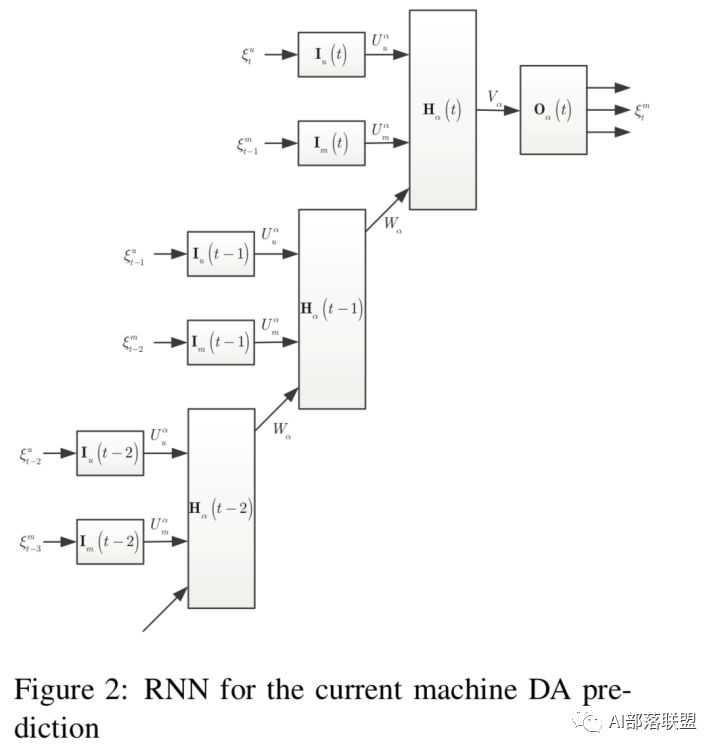

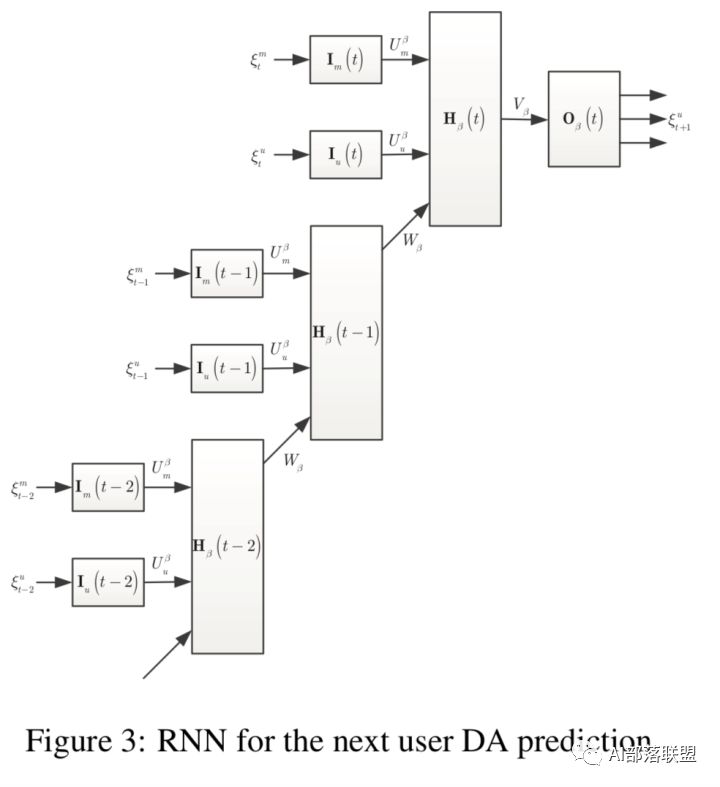

Multi- domain dialog state tracking using recurrent neural networks

3.3 迁移学习在DPL中的用法:

3.3.1 Linear Model transfer for Q-learning

Transfer learning for user adaptation in spoken dialogue systems.

3.3.2 Gaussian Process transfer for Q-learning

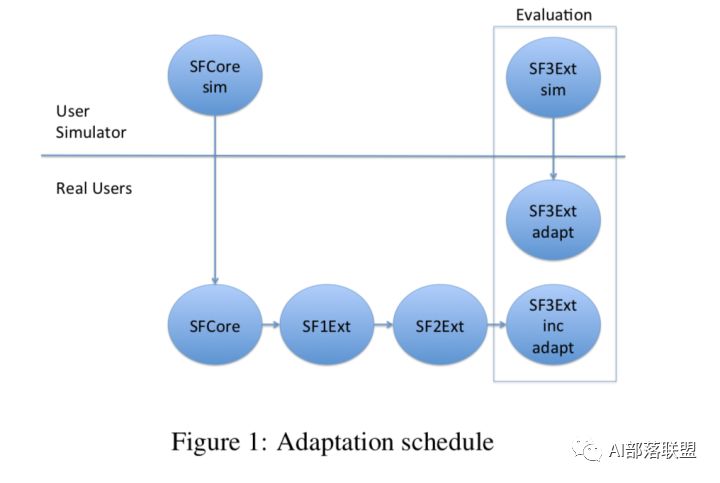

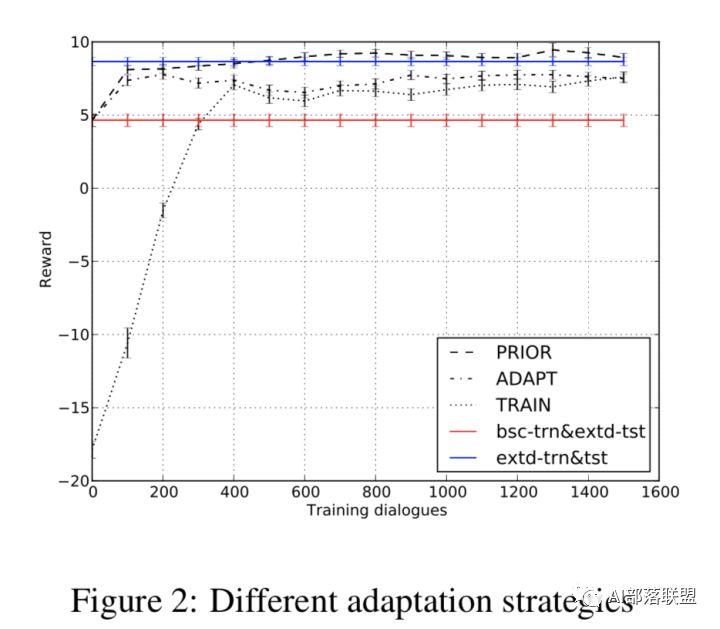

Incremental on-line adaptation of POMDP-based dialogue managers to extended domains

POMDP-based dialogue manager adaptation to extended domains

Distributed dialogue policies for multi domain statistical dialogue management

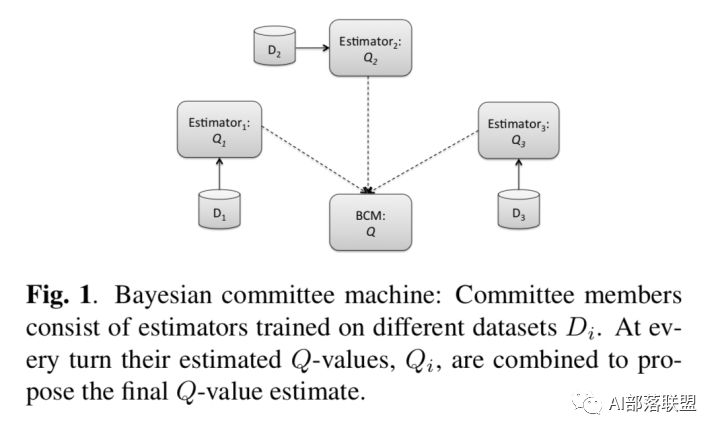

3.3.3 Bayesian Committee Machine transfer for Q-learning

Policy committee for adaptation in multi-domain spoken dialogue systems

3.4 迁移学习在NLG中的用法:

3.4.1 Model fine-tuning Transfer for NLG

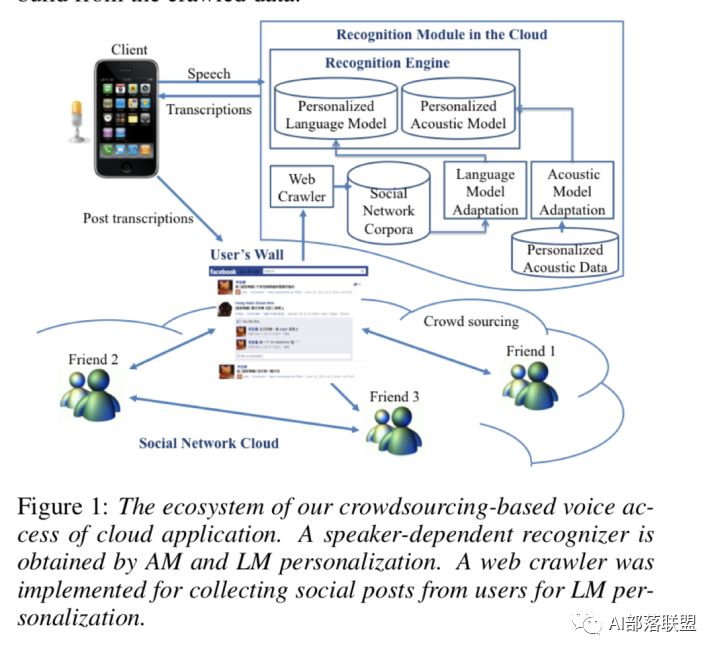

Recurrent neural network based languagemodel personalization by social network crowdsourcing

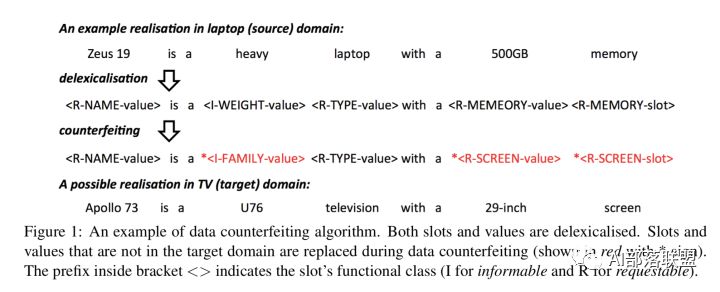

3.4.2 Instance Synthesis Transfer for NLG

Multi-domain neural network language generation for spoken dialogue systems

以上就是我对“任务型对话中的跨领域&个性化&迁移学习”的一个简单总结,文中贴了部分论文。

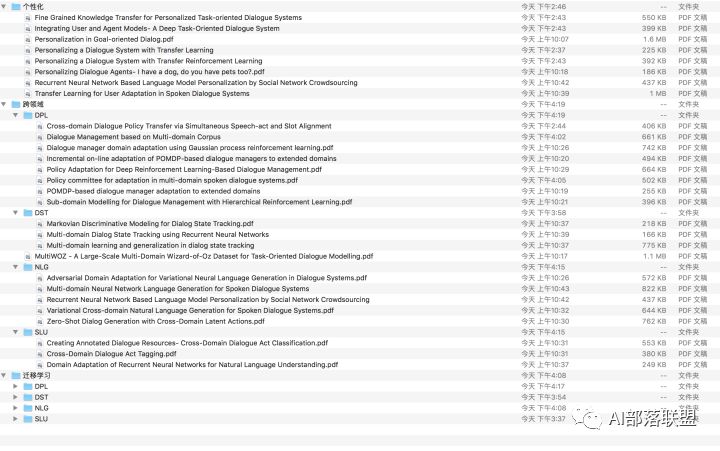

完整的论文集请关注微信公众号“AI部落联盟”并回复“TL”获取下载链接。论文集截图如下。

AI求职百题斩已经悄咪咪上线啦,点击下方小程序卡片,开始愉快答题吧!

点击 阅读原文 查看本文更多内容↙