论文浅尝 | P-Adapters: 从具有不同提示的语言模型中鲁棒地提取事实信息

笔记整理:田玺,浙江大学硕士研究生。研究方向:知识图谱、自然语言处理

论文地址:https://openreview.net/forum?id=DhzIU48OcZh,录用于ICLR2022

摘要

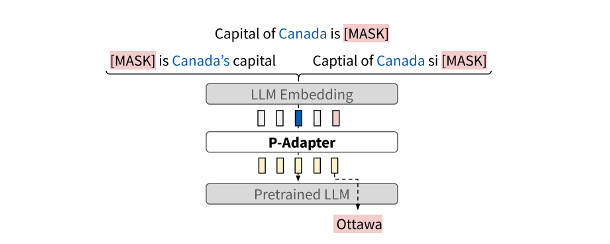

之前的工作发现,从大型语言模型(LLMs)中提取事实信息的质量取决于用于查询的Prompt,但用不同的Prompt来查询相同的信息应该得到相同的答案。本文作者通过引入P-Adapters来解决这一问题:一个位于LLMs的embedding层和第一个attention层之间的轻量级模型。此外,作者还研究了混合专家(MoE)模型,在从BERT和RoBERTa中提取事实信息方面,P-Adapters的表现与更复杂的MoE模型相当,同时不需要额外注释。最后,作者研究发现是获得原始自然语言Prompt的LLM embedding,特别是实体对的主语是使P-Adapters成功的重要因素。

论文动机

为了使LLMs成为有效的知识库,它们必须对用户可能提供的不同查询具有鲁棒性。然而先前的工作表明LLMs并不鲁棒:语义等同的查询可能导致不一致的预测。之前的许多工作试图为一个给定的关系找到最佳的一个或一组prompt来让模型更好地提取事实信息,而本文中,作者提出P-Adapters的模型来帮助LLMs克服这种变化性,通过将自然语言prompt改变为连续的表征,使LLMs能够准确预测事实信息。它们是端到端的优化,在训练时只需要(prompt,宾语)对,并通过学习将不同的训练prompt映射到相同的宾语,从而隐性地鼓励一致性。

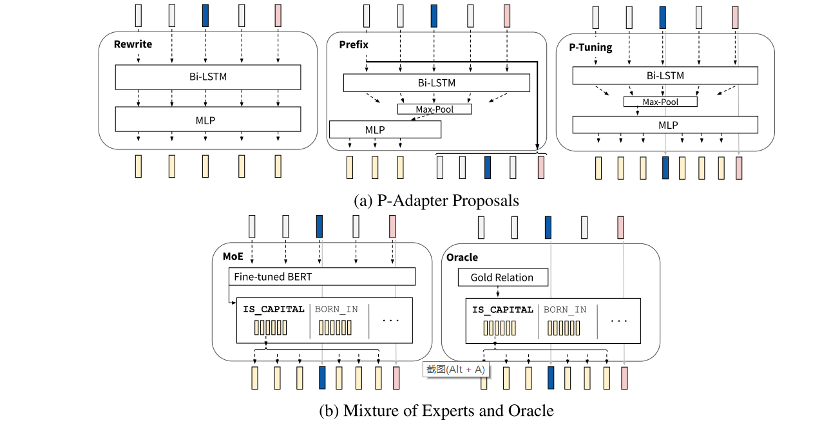

图1 P-Adapters的框架

作者还研究了其他可以提高自然语言prompt一致性的模型:专家混合(MoE)模型。并在四种情况中对模型进行了评估:

1.ID模板和宾语:模板和宾语来自同一个分布。

2.OOD Prompt:不同的自然语言prompt集

3.OOD Objects:不同的实体分布。

4.OOD Keyboard Errors:有拼写错误的自然语言prompt。

最后,作者深入研究了什么使P-Adapter有效,发现保持一些原始的自然语言prompt 的embedding,特别是主语的embedding很重要。

模型

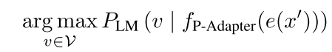

P-Adapter模型训练函数

Rewrite P-Adapter:原始的embedding经过一个双向的LSTM和一个MLP后全部被改写,成为完全不同的embedding。

Prefix P-Adapter:原始的embedding经过Bi-LSTM、max-pool和MLP后作为原始的embedding的前缀。

P-Tuning P-Adapter:基于P-Tuning的方法,只有主语和[MASK] token的embedding保持不变,但是此方法中需要知道主语的身份。

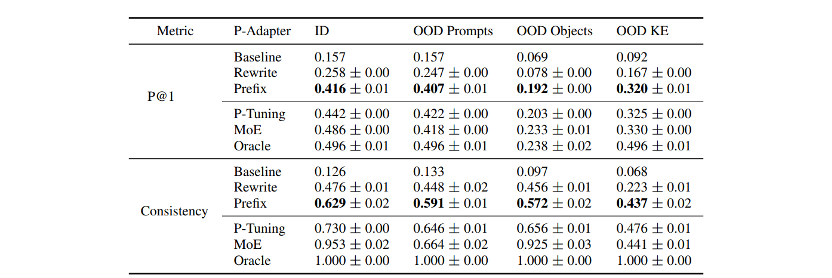

MoE模型:由一个预测自然语言prompt实体之间关系的分类器和一个用于将预测的关系映射到典型的连续prompt的查找表组成(见图2(b))。

Oracle方法:与MoE方法类似,只是不是使用分类器来预测关系,而是在推理时使用gold关系(见图2(b))。

Baseline:将自然语言prompt作为输入,没有任何前缀或优化。

图2 P-Adapter、MoE和Oracle模型

实验

数据集:实体对方面,作者使用了LAMA进行评估,使用Shin等人[1]为每个关系收集的独立的实体对集进行训练和验证,对于OOD Objects的情况,使用了Cao等人[2]的uniform-wikidata数据集中的实体对;模板方面,作者使用了LAMA、LPAQA和ParaRel数据集,并使用Lee等人[3]的BERT词汇替换系统为每个模板生成五个改述来补充ParaRel模板,将这些模板分成两个同等大小的组,一个用于训练,一个用于OOD Prompt评估,OOD Keyboard Errors的情况,作者使用了训练的模板,然后使用nlpaug包在每个模板中引入至少一个拼写错误。

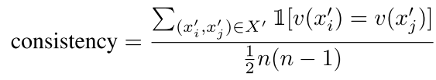

评价指标为P@1和一致性,一致性定义为

其中,

表1中为BERT Base的实验结果,BERT Large和RoBERTa Large的结果显示了类似的趋势,详细见文章附录。在所有的评估设置中,优化的prompt比自然语言的prompt有更高的精确度。

表1 BERT Base的P@1和一致性实验结果

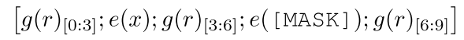

从表1的结果中观察到,让LLM访问其未修改的自然语言prompt的embedding是有帮助的。因此作者进行了消融实验,探究自然语言prompt的哪一部分是需要保留的。

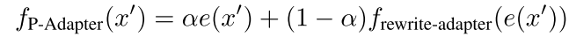

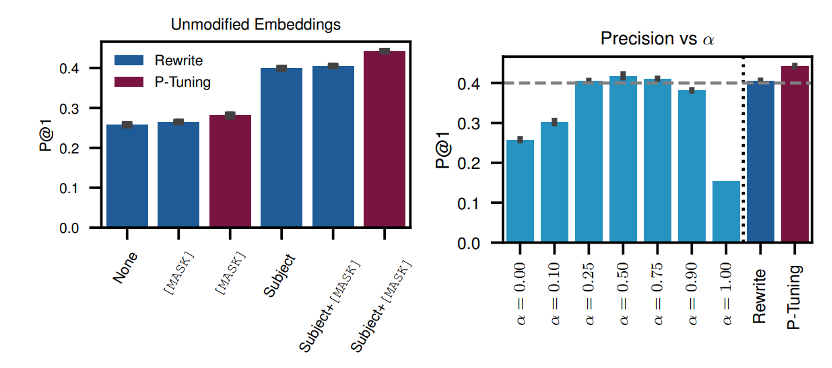

图3(左)显示了LLM的哪些embedding是重要的,可以保持不修改。作者得出结论,prompt中主语token的embedding不被修改使得P-Adapter表现突出,但需要在训练和推理时知道主语token的索引,这与之前不使用额外注释的要求相矛盾。因此,作者提出了另一种版本的P-Adapter将未经修改的LLM的自然语言prompt加入到P-Adapter的输出中,如下:

图3(右)显示了α等于0.5时,模型表现最好。当主语和[MASK] token被替换进来时,尽管表现比P-Tuning P-Adapter差,但优于Rewrite P-Adapter。

图3 左图为LLM的哪些embedding是重要的,可以保持不修改。右图为不同的α与P-Tuning P-Adapter和Rewrite P-Adapter进行比较。

参考文献

[1] Auto- Prompt: Eliciting Knowledge from Language Models with Automatically Generated Prompts. (EMNLP2020)

[2] Knowledgeable or educated guess? revisiting language models as knowledge bases. (ACL2021)

[3] Swords: A benchmark for lexical substitution with improved data coverage and quality. (NAACL2021)

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。