计算机视觉领域中有很多任务,如目标检测、图像转换、风格迁移等,但你听说过「图像情感迁移」吗?

罗切斯特大学罗杰波教授团队提出了这项研究任务 [1]。与其他计算机视觉任务相比,图像情感迁移更有挑战性,需要对图像中的每个物体进行不同的情感迁移。该研究提出一种灵活有效的物体级图像情感迁移框架和新模型 SentiGAN,实验证明该框架可以有效执行物体级图像情感迁移。

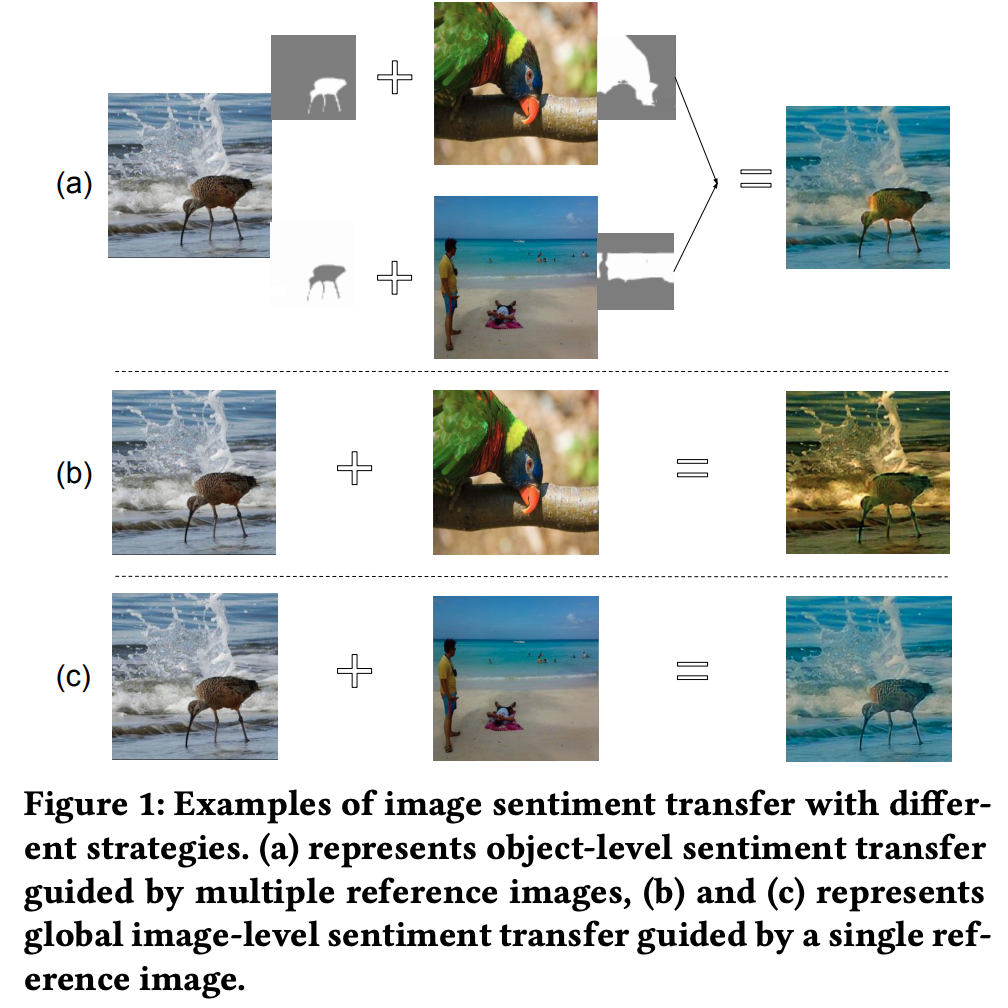

图像情感迁移是一个待探索的新型研究任务。与图像转换、图像风格迁移和面部表情迁移任务相比,图像情感迁移关注更高级更抽象的对图像整体外观和感觉的修改,而不改变其场景内容。如图 1a 所示,将浑浊的海水变得清澈并给海鸟着色后,原本传递中性或消极情感的图像变得积极温暖,而图像中的内容并未被更改。

与图像转换和图像风格迁移相比,该研究认为图像情感迁移更具挑战性。其中一个难点在于对不同类别的物体进行情感迁移时需要使用不同的规则。这有别于风格迁移,后者可以将一种绘画风格统一添加给图像中的所有物体。如图 1 所示,要让输入图像具备积极情感,应把海水迁移成清澈的蓝色,海鸟迁移成彩色的。这两种操作不是基于同一张参考图像,否则就会像图 1b 和 1c 那样不真实。

![]()

为了解决这一挑战,该研究提出了一种有效框架,可以在物体级别执行图像情感迁移。整个过程可分为两步:

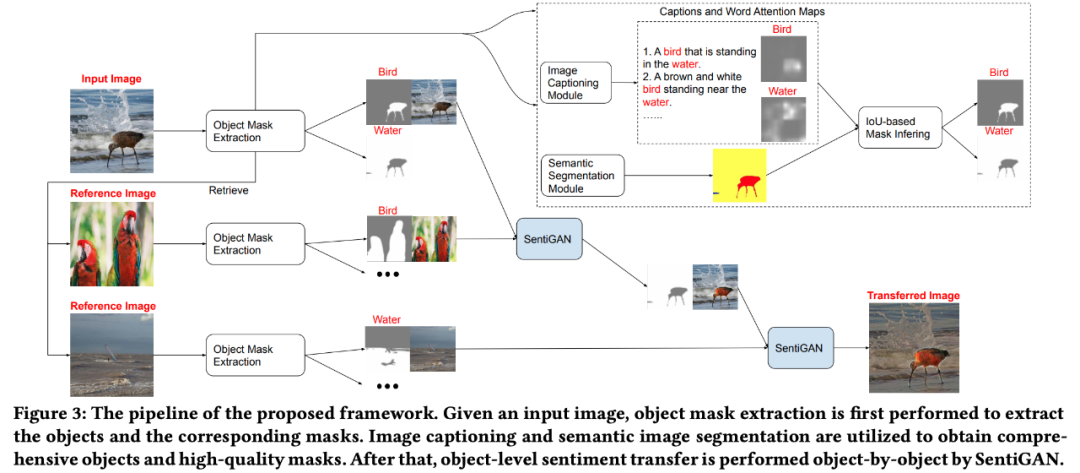

1. 给定一张输入图像,该框架利用图像描述生成模型和语义分割模型检测所有物体,找出其像素级掩码。结合使用两个模型的目的是,维护高质量的物体掩码,同时大幅扩大物体集的范围。

2. 对于输入图像中每一个检测出的物体,使用包含同样物体的参考图像进行情感迁移。该设计成功地解决了前述问题,并使框架保持强大的灵活性,例如用户可以给输入图像中的每一个物体赋予不同的情感。此外,它还可以使用户无需提供参考图像,

直接输入想要赋予每一个检测出物体的情感词汇即可执行情感迁移

(如对鸟输入「colorful」、对天空输入「sunny」、对山输入「magnificent」)。有了物体和情感词汇,系统就可以自动检索对应的参考图像,并执行情感迁移。

该框架的整体性能由第二步决定,即目标级情感迁移。这里可以直接应用风格迁移模型,但是情感迁移任务需要迁移后的图像看起来自然,不需要局部模式(如纹理)的显式迁移,而这正是风格迁移模型的固有元素。因此,研究人员转而利用多模态图像转换模型,如 MUNIT 和 DRIT。它们可以分离内容和风格信息,为输入图像保存更多基于内容的元素。只需要对这些双领域映射模型做简单的修改,就可以使其适用于情感迁移任务,而这并不会明显限制输入和迁移图像的域。

但是,使用以上模型仍然存在缺陷。首先,MUNIT 和 DRIT 最初是为图像级变换任务设计的,它们在细粒度物体级迁移任务上表现不好。第二个问题与情感迁移的本质有关。相比于轮廓、纹理和绘画风格,图像情感更敏感,往往与基于颜色的元素有关,如对比度、饱和度、亮度和主色。

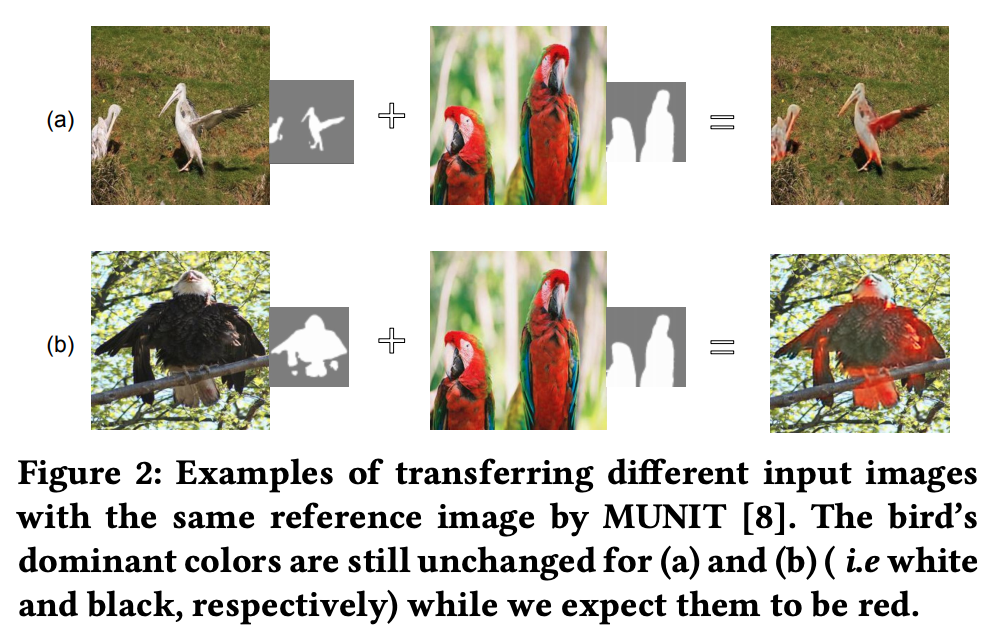

理想情况下,我们希望模型能够将输入图像的这些元素完全迁移为参考图像。现有的多模态模型通常将视觉表示分解为内容码和风格码。迁移即通过自适应实例归一化 (AdaIN),将参考图像 / 物体的风格码注入输入图像 / 物体的内容码。但是,如下图 2 所示,具备不同内容码的物体即使使用相同的风格码,得到的整体色彩分布仍然大不相同。这表明,现有模型无法充分将色彩信息和内容码分离开,因而导致不完全的颜色迁移。

![]()

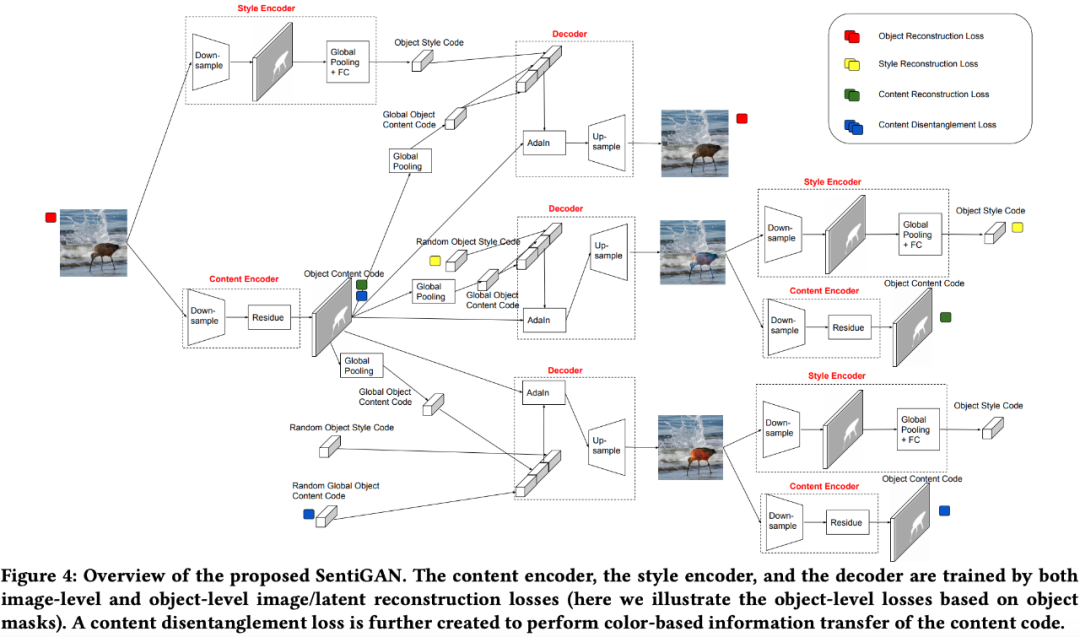

为解决以上缺陷,该研究提出了一种新方法 Sentiment-aware GAN (SentiGAN)。对于第一种缺陷,该研究创建了对应的物体级损失函数,与图像级损失一起训练模型。对于第二种缺陷,其解决方案基于以下观察:额外迁移内容码全局信息可以更好地迁移输入物体的颜色信息。同时,研究人员还通过维护空间信息来阻止其他内容信息(如纹理)的改变。为此,他们使用有效的约束,使迁移物体的内容码与参考物体的内容码全局接近,但与输入物体的内容码局部接近。这些约束通过训练过程中的内容分离损失和推断过程中的内容对齐步骤来实现。该研究表明这两种方法具备互补性,能够显著提高情感迁移的性能。

![]()

给定输入图像,首先执行物体掩码提取来提取物体和对应的掩码;然后使用图像描述生成和图像语义分割来获取所有物体和高质量掩码;最后,使用 SentiGAN 逐个物体地执行情感迁移。

![]()

研究人员创建了三个任务来评估图像情感迁移模型的性能。这三个任务均基于 50 张选自测试集的输入图像,这些图像具备精确的物体掩码和相对中性或模糊的情感信息(方便向积极或消极情感方向迁移)。

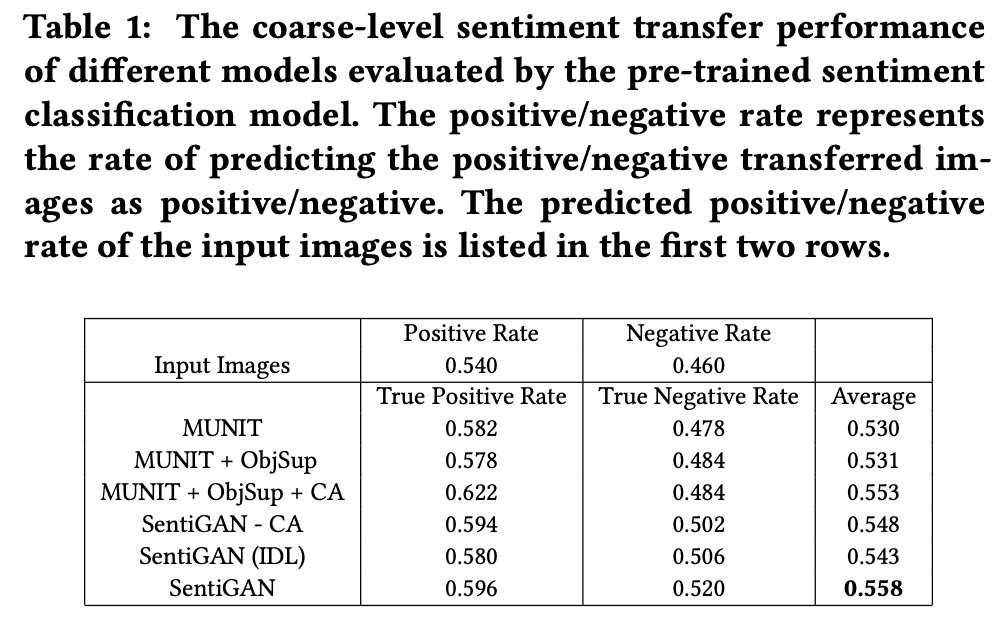

第一个任务旨在衡量模型在执行图像粗粒度情感迁移时的性能。研究人员训练一个图像情感二分类模型来用于预测提取测试集中的典型积极图像和典型消极图像。对于每一张输入图像,不同的情感迁移模型可从十组采样的积极参考图像和十组采样的消极参考图像中,对输入图像进行情感迁移。图像情感分类模型对于各个情感迁移模型得到的迁移图形评估结果参见下表 1:

![]()

从表 1 中可以看出,SentiGAN 获得了最高的平均真正率和真负率。这表明,SentiGAN 可以有效执行图像粗粒度情感迁移。

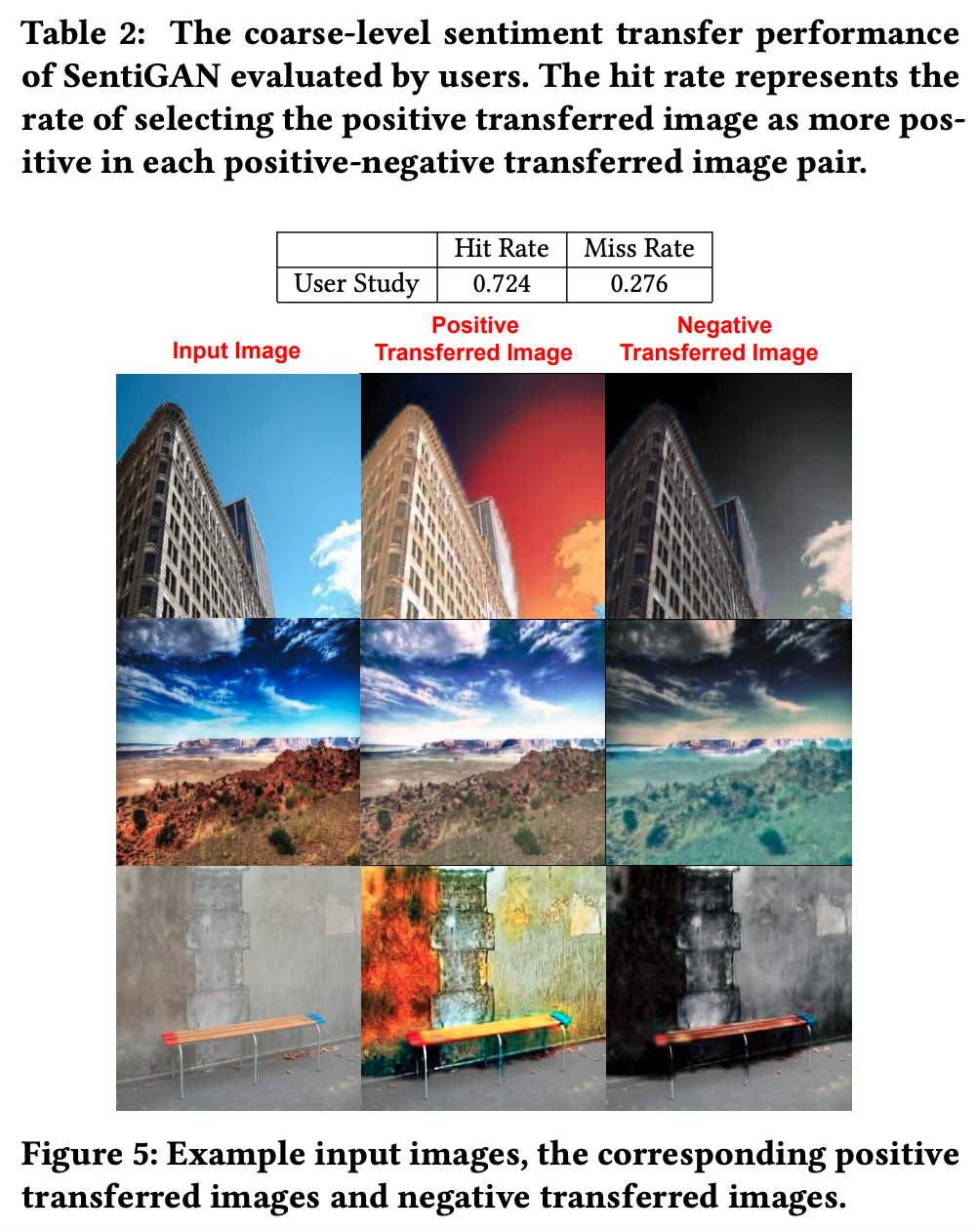

此外,研究人员还请五位志愿者从 SentiGAN 输出的 500 张迁移图像对(积极图像和消极图像)中选择积极图像。如表 2 所示,选择正确的概率为 72.4%,这表明情感迁移效果可以被用户观察到。图 5 展示了 SentiGAN 输出的情感迁移示例。

![]()

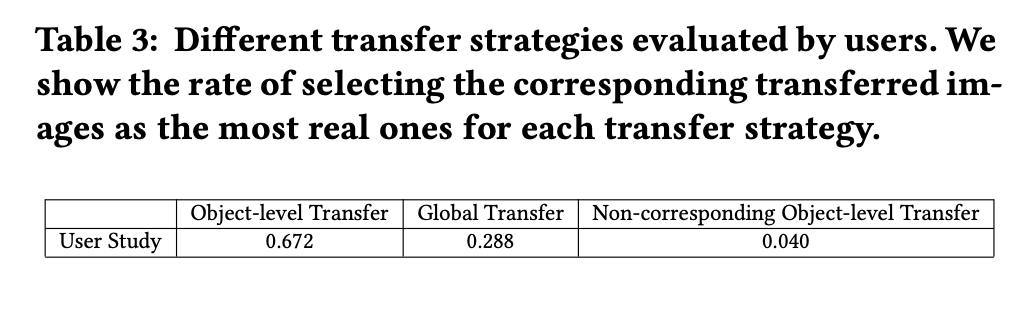

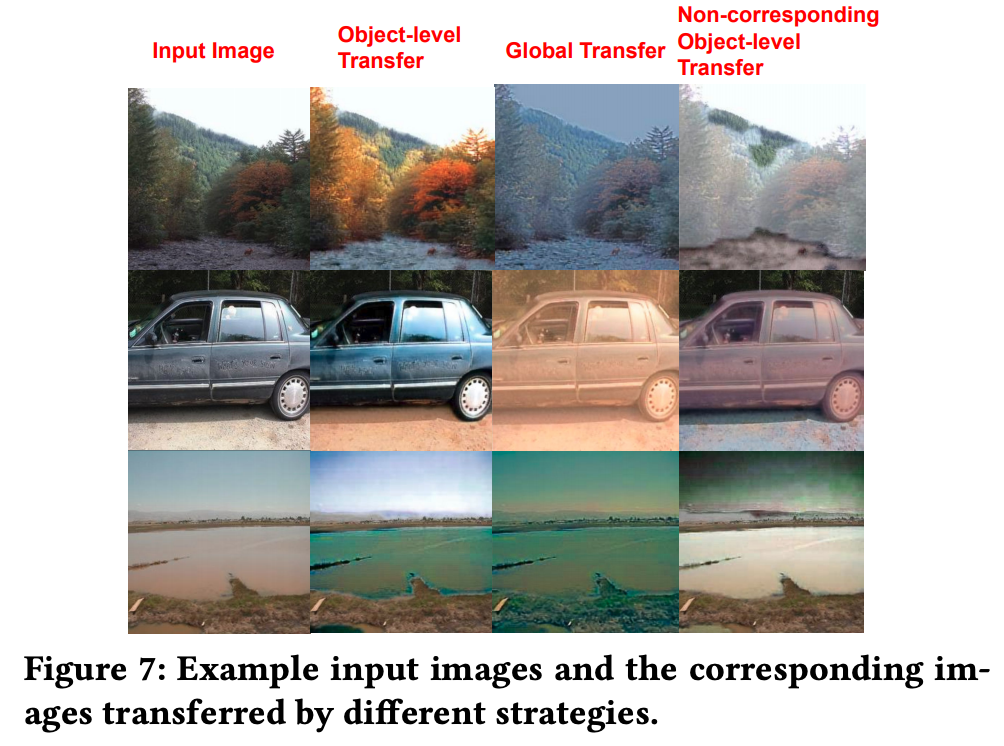

研究人员令 SentiGAN 执行三种迁移策略——物体 级迁移、全局迁移、非对应物体的物体级迁移,并生成 50 组迁移图像。令五位志愿者在每组中选择最真实的图像,每人负责 50 组。如表 3 所示,对于大多数组,志愿者认为目标级情感迁移生成的图像最真实,这与图 7 示例表现一致。

![]()

![]()

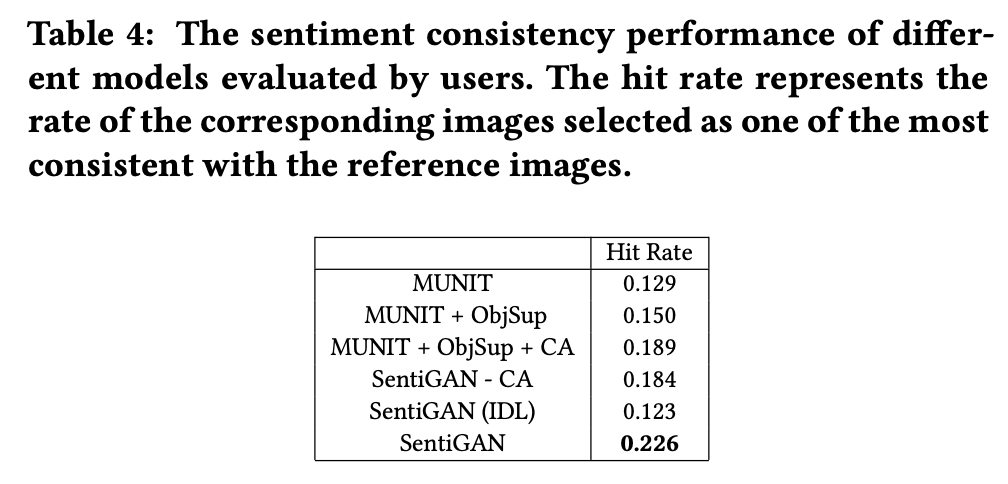

第三个任务是评估迁移图像和参考图像之间的情感一致性(sentiment consistency)。研究者对每个输入图像收集了不同模型预测的迁移图像,并请五位志愿者从中选择出一或多个与参考图像最具情感一致性的迁移图像。

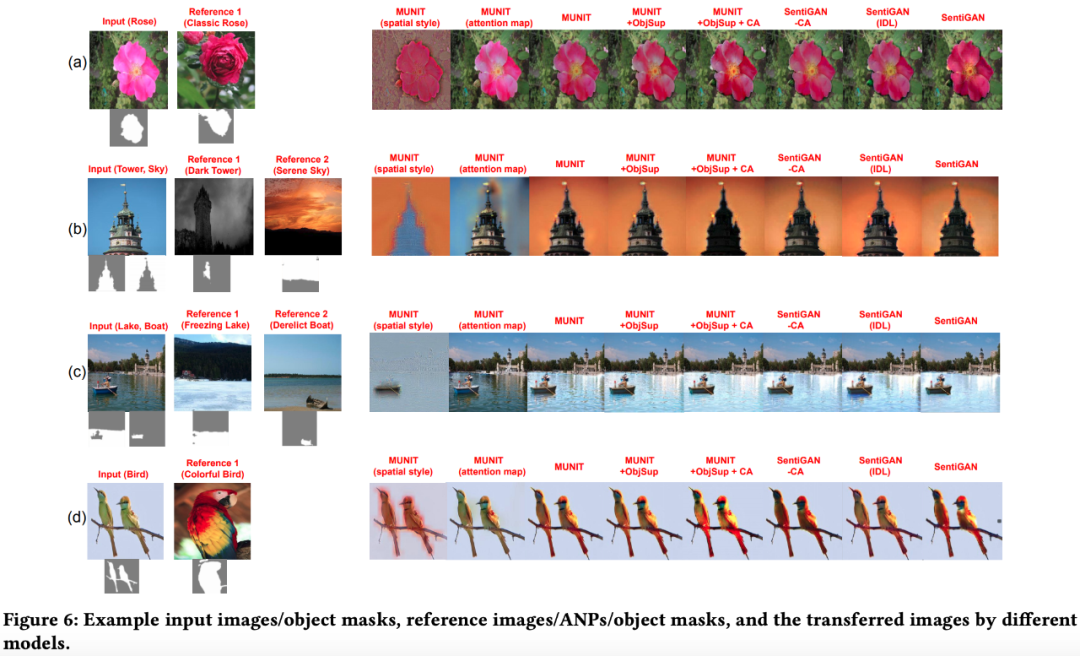

如下表 4 所示,SentiGAN 获得了最高的选中率,而且大幅领先,这表明它在迁移参考图像的情感中实现了最优性能。示例参见图 6。

![]()

![]()

罗杰波教授团队还提出了一种基于全局的图像情感迁移方法 [2],

感兴趣的读者可查看原论文。

[1] Image Sentiment Transfer

Authors: Tianlang Chen, Wei Xiong, Haitian Zheng, Jiebo Luo. 2020 ACM Multimedia Conference. arXiv: 2006.11337.

[2] Global Image Sentiment Transfer

Authors: Jie An, Tianlang Chen, Songyang Zhang, Jiebo Luo. 2020 International Conference on Pattern Recognition. arXiv:2006.11989.

11 月 14 日,DevRun 开发者沙龙华为云即将登陆上海。华为云技术大咖将带领开发者玩转 ModelArts,并解读华为云 IoT 服务与 AI 如何实现互通;聚焦华为云 ModelArts 和 IoT 智能设备,为开发者带来一场干货满满的技术盛宴。扫描二维码,参与报名。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com