机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周的重要论文有张航、李沐等研究者提出的性能提升 3% 但参数不增的 ResNet 最强改进版,以及 OpenAI 牵头、Bengio 等 59 位学者呼吁构建可信赖 AI。

ResNeSt: Split-Attention Networks

XTREME: A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization

An Optimistic Perspective on Offline Reinforcement Learning

A THEORY OF USABLE INFORMATION UNDER COMPUTATIONAL CONSTRAINTS

Flexible Transmitter Network

Toward Trustworthy AI Development: Mechanisms for Supporting Verifiable Claims

FineGym: A Hierarchical Video Dataset for Fine-grained Action Understanding

ArXiv Weekly Radiostation:NLP、CV、ML更多精选论文(附音频)

论文 1:ResNeSt: Split-Attention Networks

摘要:

2015 年,ResNet 横空出世,一举斩获 CVPR 2016 最佳论文奖,而且在 Imagenet 比赛的三个任务以及 COCO 比赛的检测和分割任务上都获得了第一名。四年过去,这一论文的被引量已超 40000 次,也陆续出现了很多变体。最近,

来自亚马逊、加州大学戴维斯分校的张航、李沐、Alexander Smola 等研究者进一步改进了 ResNet,性能显著提升,但参数量并没有显著增加,超越了之前的 ResNeXt、SENet 等模型

。

该研究的一作,亚马逊应用科学家张航表示:「分类网络通常作为下游应用的核心,但是最近很多分类问题的工作没有保持之前 ResNet 那样的模块化的设计,导致目标检测等主流应用的研究还在使用 ResNet。所以我们设计了

新的 ResNet 变体 ResNeSt,可以直接应用到已有的主流模型中,显著提高 Mask R-CNN,Cascade R-CNN 等模型的结果(~3%)

。」

![]()

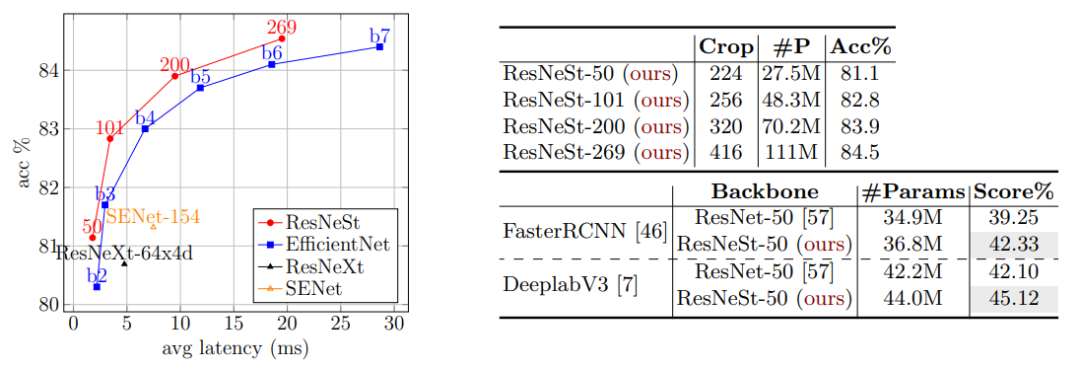

如左图所示,在速度与准确率的平衡方面,ResNeSt 达到了 SOTA 水平;右上图为 ResNeSt 在 ImageNet 上的 Top-1 准确率;右下图为迁移学习结果:MS-COCO 上的目标检测 mAP 以及 ADE20K 上的语义分割 mIoU。

![]()

![]()

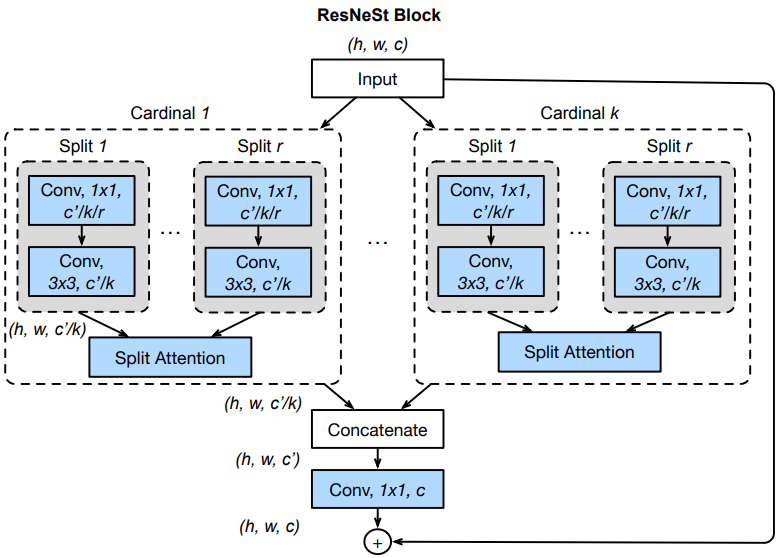

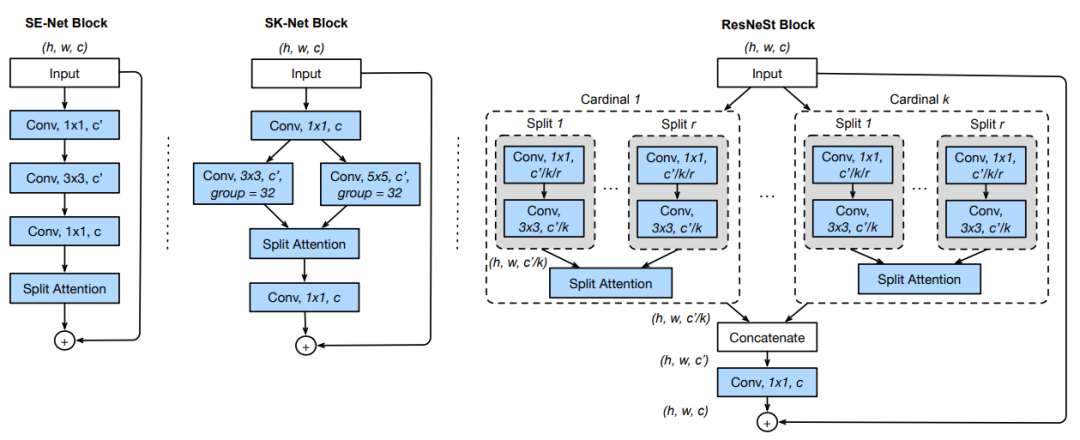

ResNeSt 块与 SE-Net 和 SK-Net 块的整体对比。

推荐:

性能显著提升,参数量却没有明显增加

。最新的 Split-Attention Networks 继承了 ResNet 简洁通用的特性。

论文 2:XTREME: A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization

摘要:

近几年,得益于深度学习的进展,有更多的方法试图学习通用的多语言表示(如 mBERT、XLM 和 XLM-R),这些方法旨在捕获跨语言间共享且对多任务有用的知识。但

在实践中,这类方法的评估却大多侧重于一小部分任务以及相似的语言

。

因此,为了鼓励人们在多语言学习领域开展更多研究,

谷歌研究院联合 CMU、DeepMind

发表了研究论文《XTREME: A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization》,

该研究覆盖了 40 种类型不同的语言(跨 12 个语系),并包含了 9 项需要对不同句法或语义层面进行推理的任务

。在 XTREME 大规模多语言多任务基准上选择 40 种不同类型的语言,这是为了实现语言多样性、现有任务覆盖以及训练数据可用性的最大化。

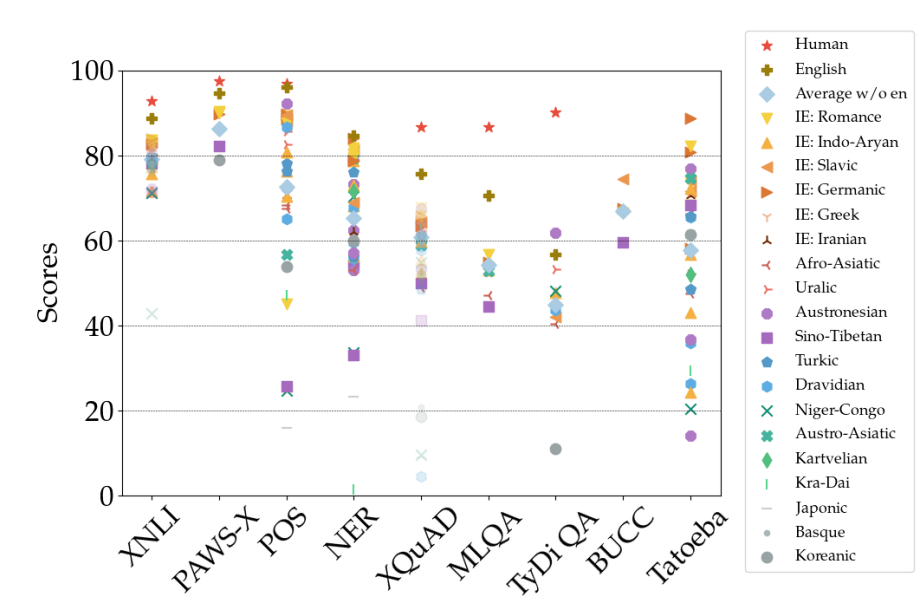

![]()

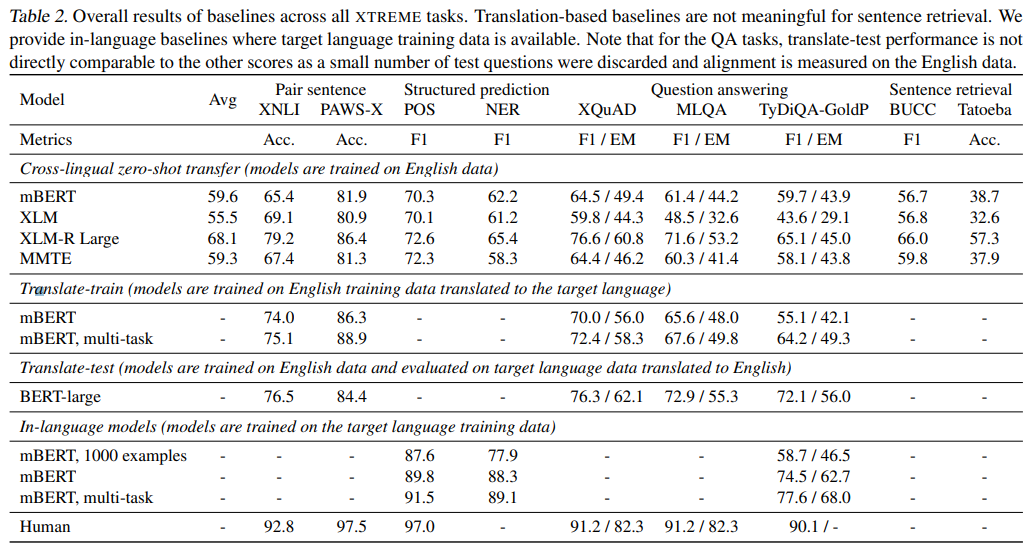

所有 XTREME 任务上基线方法(baseline)的总体结果。

![]()

在所有语言中,XLM-R 在 XTREME 任务上的性能概览。

![]()

mBERT 在不同任务和语言上的性能随 Wikipedia 文章数量的变化曲线。

推荐:

论文的并列一作是 CMU 语言技术研究所的在读博士胡俊杰和 DeepMind 著名的研究科学家 Sebastian Ruder。

论文 3:An Optimistic Perspective on Offline Reinforcement Learning

推荐:

现有的交互数据可以实现离线强化学习的有效训练,后者是完全的异策略(off-policy)强化学习设置,智能体从一个固定的数据集中学习,不与环境进行交互。在这篇论文中,根据 DQN 智能体记录下的经验,

谷歌大脑团队的研究者提出了一种在 Atari 2600 游戏中进行离线强化学习的简单实验设置

。他们展示了不通过对任何错配分布的显式修正,仍然可能训练出性能超越使用标准异策略 RL 算法收集数据的智能体。同时,研究者还提出了一种鲁棒的 RL 算法,在离线 RL 中表现出可观的结果,称作随机混合集成(random ensemble mixture,REM)。

总的来说,

研究者提出一种全新的优化角度,即鲁棒的 RL 算法在足够大且多样化的离线数据集中训练可产生高质量的行为,巩固了新兴的数据驱动 RL 范式

。为促进离线 RL 方法的开发与评估,研究者公开了他们的 DQN 回溯数据集并开源了论文的代码。

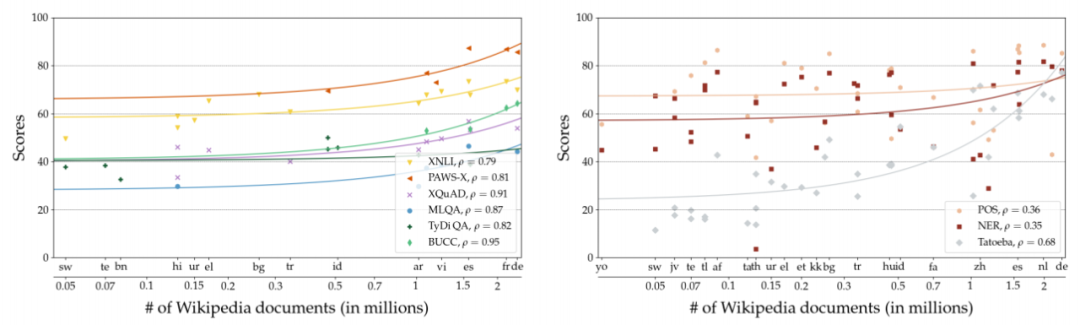

![]()

雅达利游戏上的离线 RL,包括离线 REM、离线 QR-DQN 和离线 DQN 以及它们随迭代次数的 Median Normalized Score 变化曲线。

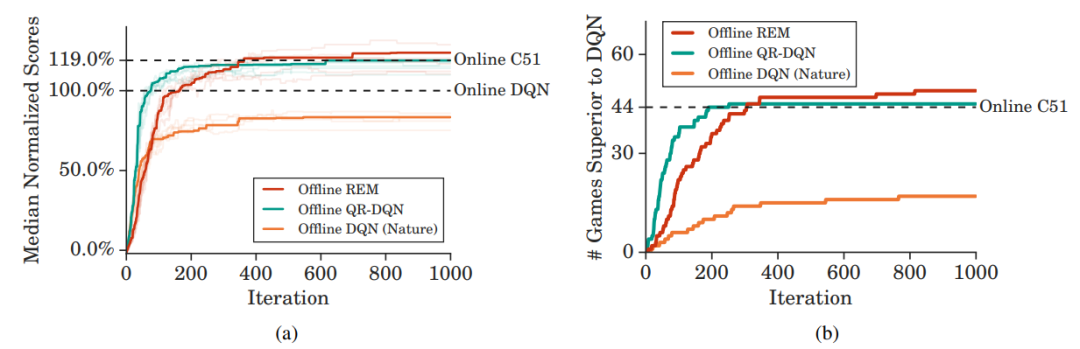

![]()

DQN、值函数分布 QR-DQN 以及期望的 RL 变体,即具有与 QR-DQN 相同 multi-head 架构的集成 DQN 和 REM 的神经网络架构。

![]()

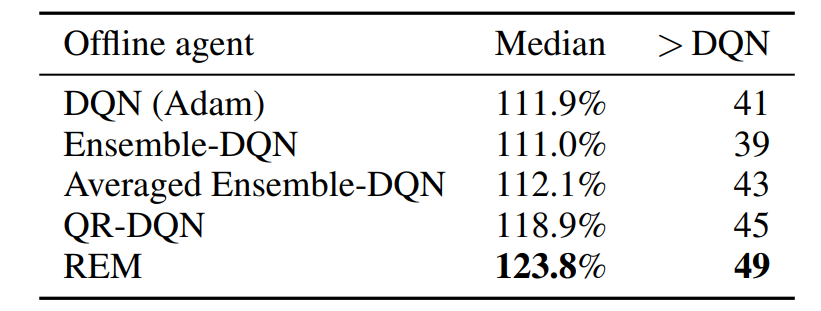

DQN(Adam)、集成 DQN、Averaged 集成 DQN、QR-DQN 和 REM 这 5 种离线智能体的渐进性能(Asymptotic performance)。

推荐:

值的注意的一点是,

谷歌的这项研究需要的算力非常

大,训练数据集共包含 60 个雅达利游戏环境,大小约为 ImageNet 的 60 x 3.5 倍。

论文 4:A THEORY OF USABLE INFORMATION UNDER COMPUTATIONAL CONSTRAINTS

摘要:

在本文中,

来自北大和斯坦福的研究者提出了一种用于复杂系统中信息推理的新型框架,该框架基于香农信息论的变分扩展(variational extension),其中考虑了观察器的建模能力和计算约

束

。所得到的预测性 V-信息包含交互信息以及其他信息性概念,例如确定系数。与香农的交互信息不同,并且没有出现数据处理不平等的情况,V-信息可以通过计算来创建。这与深度神经网络在表示学习中提取具有更多信息特征的层次结构相一致。此外,实验表明,通过合并计算约束,在使用 PAC-style 保证的情况下,V-信息也能够以高维的形式在数据中实现可靠地估计。从实证研究的角度来看,对于结构学习和 fair 表示学习而言,预测性 V-信息较交互信息更有效。

![]()

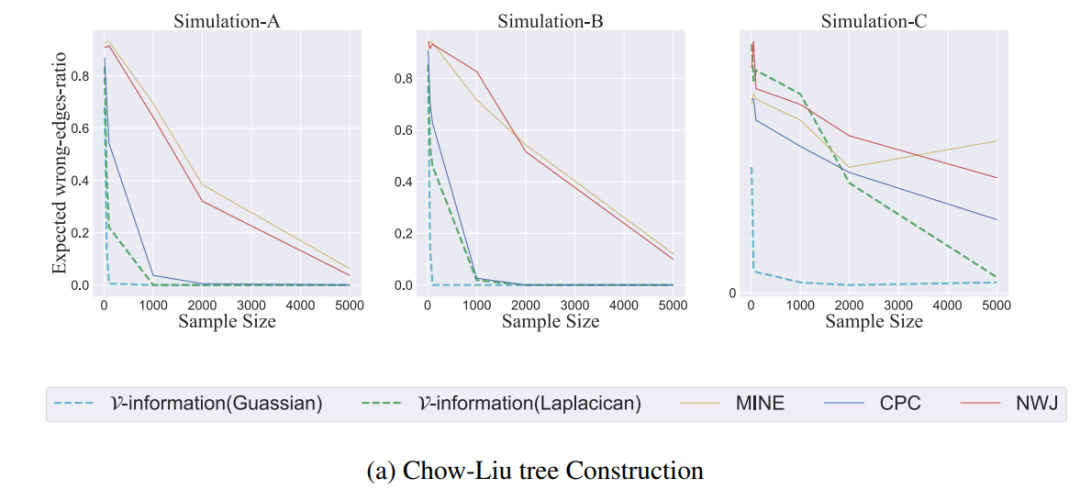

本文通过实验验证了新的基于 V-信息的算法构建 Chow-Liu Tree 的效果,优于利用现存最好的互信息估计量的 Chow-Liu 算法。

![]()

研究者将 V-信息用到了其他结构学习的任务中,如基因网络重建(图左)和因果推断(图右)。

推荐:

论文一作为北京图灵班本科生许逸伦,并且在审稿阶段,

论文以满分获得 ICLR 2020 接收

。

论文 5:Flexible Transmitter Network

摘要:

当前的神经网络大多基于 MP 模型,即按照生物神经元的结构和工作原理构造出来的抽象和简化模型。此类模型通常将神经元描述为「在来自其他神经元的信号的实值加权集合上执行激活函数」。近日,

南京大学的张绍群博士和周志华教授提出了一个名为 Flexible Transmitter (FT) 的模型,这是一种具备灵活可塑性的新型生物拟真神经元

。

具体来讲,FT 模型利用一对参数来建模神经元之间的递质(transmitter),并设置一个神经递质调节的记忆单元来记录感兴趣神经元的长期学习信息。因此,FT 模型是一个双变量二值函数,常用的 MP 神经元模型是其特殊形式。FT 模型可以处理更加复杂的数据,甚至时序信号。

为了展示 FT 模型的能力和潜力,研究者提出了 Flexible Transmitter Network (FTNet)

。FTNet 基于最常见的全连接前馈架构而构建,FT 神经元是该架构的基本构造块。FTNet 允许梯度计算,并且可以通过在复杂域中执行反向传播算法的扩展版本来实现。在一系列任务上的实验结果展示了 FTNet 的优越性能。这项研究为神经网络提供了另一种基本构造块,展示了开发具有神经元可塑性的人工神经网络的可行性。

![]()

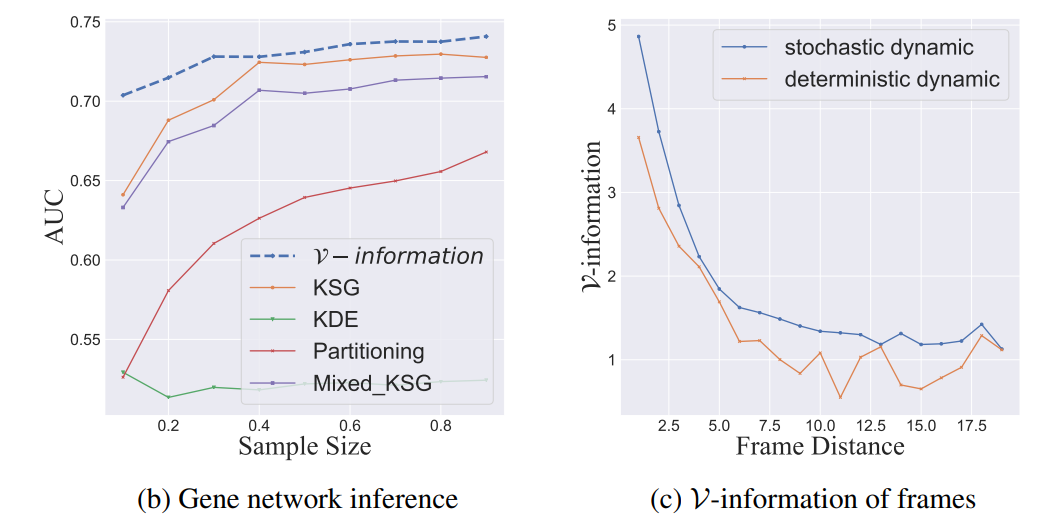

FT 模型图示。其中 (w, v) 是递质参数对,m_t 表示神经元 A 的记忆单元在时间 t 处的强度。

![]()

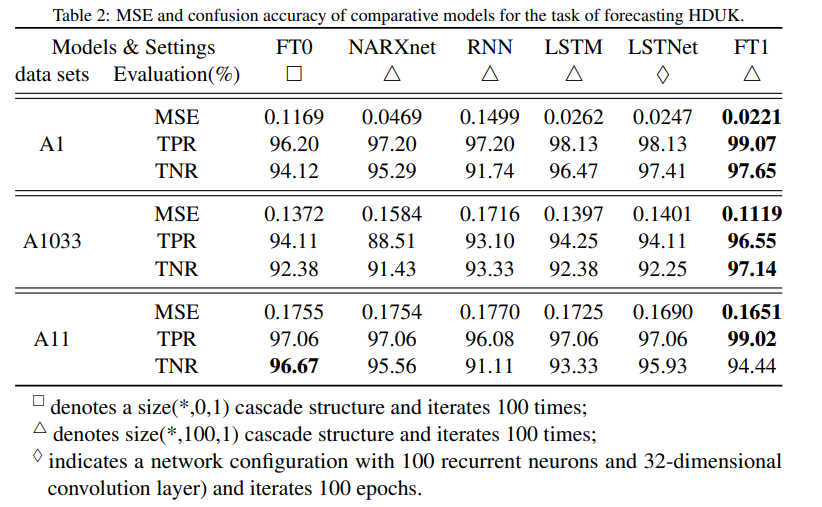

FT 模型在 HDUK 交通预测任务上的 MSE 和 confusion accuracy。

![]()

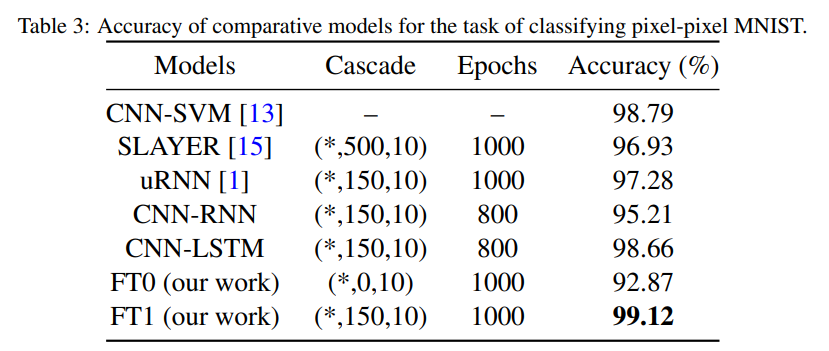

各模型在 pixel-by-pixel MNIST 任务上的准确度对比。

推荐:

本研究从神经元入手改进神经网络,可以处理更复杂的数据,甚至是时序信号。

论文 6:Toward Trustworthy AI Development: Mechanisms for Supporting Verifiable Claims

摘要:

近年来人工智能的进展使人们逐渐意识到 AI 系统的巨大影响,并认识到业界和学界现有的规定和标准并不足以确保负责任 AI 的发展。为了赢得系统用户、客户、民间团体、政府以及其他利益相关者的信任,以及令这些主体相信他们正在负责任地构建 AI,AI 开发者需要做出可验证的声明并为此负责。与此同时,指定组织机构之外的主体也需要切实有效的手段来核查这些声明。

因此,

来自 OpenAI、Google Brain 等多个机构的59位研究者撰写了一份报告,指出不同的利益相关者可以采取不同的措施来提升 AI 系统及其开发过程相关声明的可验证性,同时重点强调为 AI 系统的安全性、公平性和隐私保护提供证

据。为此,研究者解析了涵盖制度和软硬件的 10 种机制,并针对这些机制的实现、探索和改进提出建议。

![]()

推荐:

59 位作者,80 页 PDF,

图灵奖得主、深度学习三巨头之一 Yoshua Bengio 也参与了报告的撰写

。

论文 7:FineGym: A Hierarchical Video Dataset for Fine-grained Action Understanding

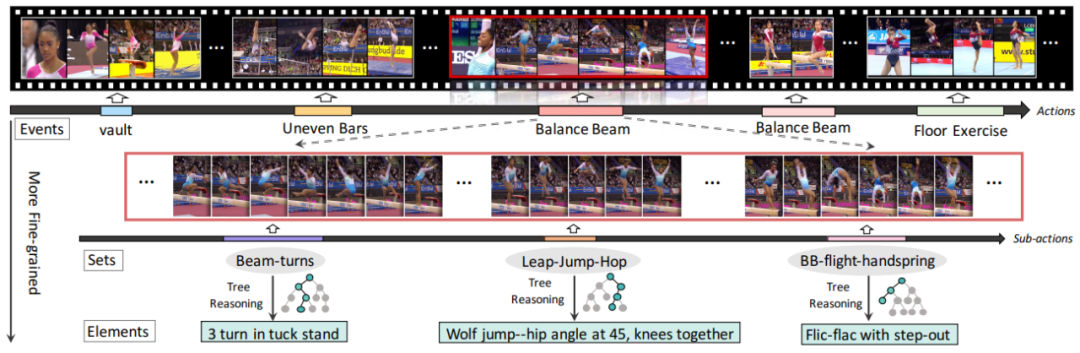

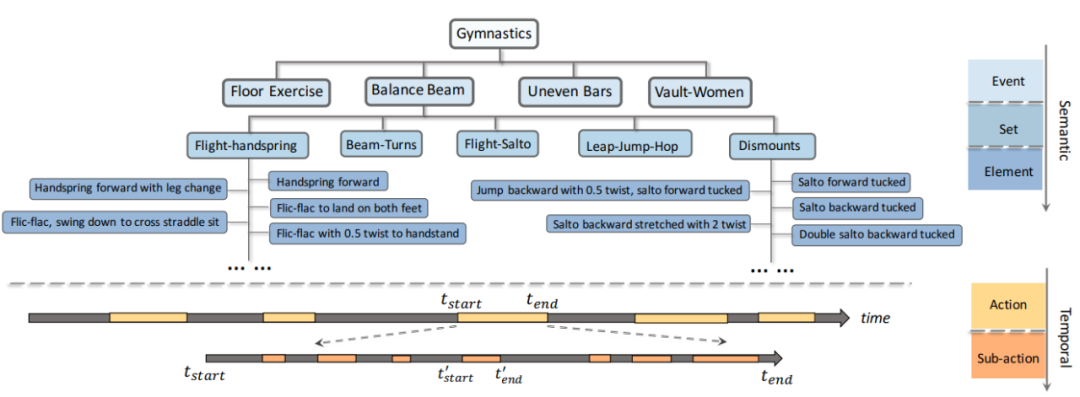

摘要:视频中的动作理解一直是计算机视觉领域的热点研究方向。原有的工作一般都是面向粗粒度的动作识别与分析,在许多现有数据集上相关研究已经遇到了瓶颈。在这项工作中,

来自港中文和商汤的研究者提出了一个大规模、高质量、层级化标注的细粒度人体动作数据集:FineGym

。在这一数据集上,我们对现有的各类动作识别方法从多个层级多个角度进行了分析,得了很多有趣的结果,对领域一些固有结论产生了挑战,也为未来的研究带来了一些启发。

值得注意的是,除了支持动作识别任务,FineGym 丰富的标注内容还可以支持其他动作相关的研究,如时域动作检测、动作质量评估、动作生成、动作属性识别等。

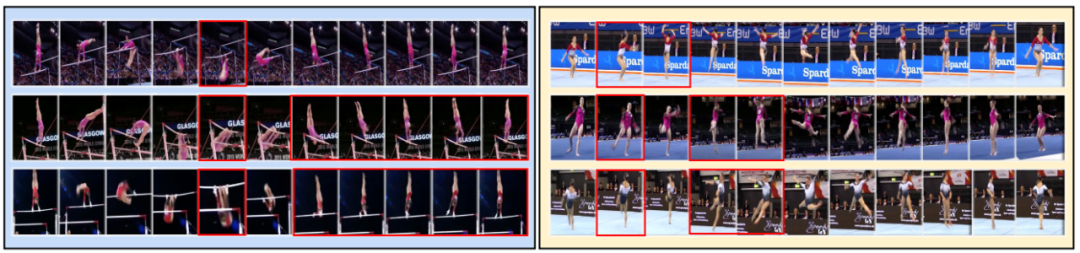

![]()

![]()

![]()

推荐:

本研究以

3 strong accpet 的满分成绩被 CVPR2020 接收

。

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天发起的ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括NLP、CV、ML领域各10篇精选,并提供音频形式的论文摘要简介,详情如下:

本周 10 篇 NLP 精选论文是:

1. AREDSUM: Adaptive Redundancy-Aware Iterative Sentence Ranking for Extractive Document Summarization. (from Keping Bi, Rahul Jha, W. Bruce Croft, Asli Celikyilmaz)

2. ToD-BERT: Pre-trained Natural Language Understanding for Task-Oriented Dialogues. (from Chien-Sheng Wu, Steven Hoi, Richard Socher, Caiming Xiong)

3. Rapidly Deploying a Neural Search Engine for the COVID-19 Open Research Dataset: Preliminary Thoughts and Lessons Learned. (from Edwin Zhang, Nikhil Gupta, Rodrigo Nogueira, Kyunghyun Cho, Jimmy Lin)

4. Neural Data-to-Text Generation with Dynamic Content Planning. (from Kai Chen, Fayuan Li, Baotian Hu, Weihua Peng, Qingcai Chen, Yajuan Lv, Yong Zhu, Hong Yu)

5. Document-level Representation Learning using Citation-informed Transformers. (from Arman Cohan, Sergey Feldman, Iz Beltagy, Doug Downey, Daniel S. Weld)

6. When Does Unsupervised Machine Translation Work?. (from Kelly Marchisio, Kevin Duh, Philipp Koehn)

7. Toward Subgraph Guided Knowledge Graph Question Generation with Graph Neural Networks. (from Yu Chen, Lingfei Wu, Mohammed J. Zaki)

8. AMR Parsing via Graph-Sequence Iterative Inference. (from Deng Cai, Wai Lam)

9. Keyword Assisted Topic Models. (from Shusei Eshima, Kosuke Imai, Tomoya Sasaki)

10. The Right Tool for the Job: Matching Model and Instance Complexities. (from Roy Schwartz, Gabi Stanovsky, Swabha Swayamdipta, Jesse Dodge, Noah A. Smith)

1. Monocular Depth Estimation with Self-supervised Instance Adaptation. (from Robert McCraith, Lukas Neumann, Andrew Zisserman, Andrea Vedaldi)

2. Contrastive Examples for Addressing the Tyranny of the Majority. (from Viktoriia Sharmanska, Lisa Anne Hendricks, Trevor Darrell, Novi Quadrianto)

3. Image Quality Assessment: Unifying Structure and Texture Similarity. (from Keyan Ding, Kede Ma, Shiqi Wang, Eero P. Simoncelli)

4. Spatial Priming for Detecting Human-Object Interactions. (from Ankan Bansal, Sai Saketh Rambhatla, Abhinav Shrivastava, Rama Chellappa)

5. The Devil is in the Details: Self-Supervised Attention for Vehicle Re-Identification. (from Pirazh Khorramshahi, Neehar Peri, Jun-cheng Chen, Rama Chellappa)

6. SpeedNet: Learning the Speediness in Videos. (from Sagie Benaim, Ariel Ephrat, Oran Lang, Inbar Mosseri, William T. Freeman, Michael Rubinstein, Michal Irani, Tali Dekel)

7. Would Mega-scale Datasets Further Enhance Spatiotemporal 3D CNNs?. (from Hirokatsu Kataoka, Tenga Wakamiya, Kensho Hara, Yutaka Satoh)

8. Learning to Explore using Active Neural SLAM. (from Devendra Singh Chaplot, Dhiraj Gandhi, Saurabh Gupta, Abhinav Gupta, Ruslan Salakhutdinov)

9. 6D Camera Relocalization in Ambiguous Scenes via Continuous Multimodal Inference. (from Mai Bui, Tolga Birdal, Haowen Deng, Shadi Albarqouni, Leonidas Guibas, Slobodan Ilic, Nassir Navab)

10. RescueNet: Joint Building Segmentation and Damage Assessment from Satellite Imagery. (from Rohit Gupta, Mubarak Shah)

1. On Learning Rates and Schr\"odinger Operators. (from Bin Shi, Weijie J. Su, Michael I. Jordan)

2. A Spatiotemporal Epidemic Model to Quantify the Effects of Contact Tracing, Testing, and Containment. (from Lars Lorch, William Trouleau, Stratis Tsirtsis, Aron Szanto, Bernhard Schölkopf, Manuel Gomez-Rodriguez)

3. Extrapolation in Gridworld Markov-Decision Processes. (from Eugene Charniak)

4. LOCA: LOcal Conformal Autoencoder for standardized data coordinates. (from Erez Peterfreund, Ofir Lindenbaum, Felix Dietrich, Tom Bertalan, Matan Gavish, Ioannis G. Kevrekidis, Ronald R. Coifman)

5. Sequential Batch Learning in Finite-Action Linear Contextual Bandits. (from Yanjun Han, Zhengqing Zhou, Zhengyuan Zhou, Jose Blanchet, Peter W. Glynn, Yinyu Ye)

6. Controllable Variational Autoencoder. (from Huajie Shao, Shuochao Yao, Dachun Sun, Aston Zhang, Shengzhong Liu, Dongxin Liu, Jun Wang, Tarek Abdelzaher)

7. Certified Adversarial Robustness for Deep Reinforcement Learning. (from Michael Everett, Bjorn Lutjens, Jonathan P. How)

8. Taxonomy of Dual Block-Coordinate Ascent Methods for Discrete Energy Minimization. (from Siddharth Tourani, Alexander Shekhovtsov, Carsten Rother, Bogdan Savchynskyy)

9. Neural Status Registers. (from Lukas Faber, Roger Wattenhofer)

10. Telling BERT's full story: from Local Attention to Global Aggregation. (from Damian Pascual, Gino Brunner, Roger Wattenhofer)

![]()