【导读】图神经网络依然是当下的研究热点。来自新加坡南洋理工大学Xavier Bresson和Bengio联合发布了一篇论文《Benchmarking Graph Neural Networks》,如何构建强大的GNN成为了核心问题。什么类型的架构、第一原则或机制是通用的、可推广的、可伸缩的,可以用于大型图数据集和大型图数据集? 另一个重要的问题是如何研究和量化理论发展对GNNs的影响?基准测试为回答这些基本问题提供了一个强有力的范例。作者发现,准确地说,图卷积、各向异性扩散、剩余连接和归一化层是开发健壮的、可伸缩的GNN的通用构件。

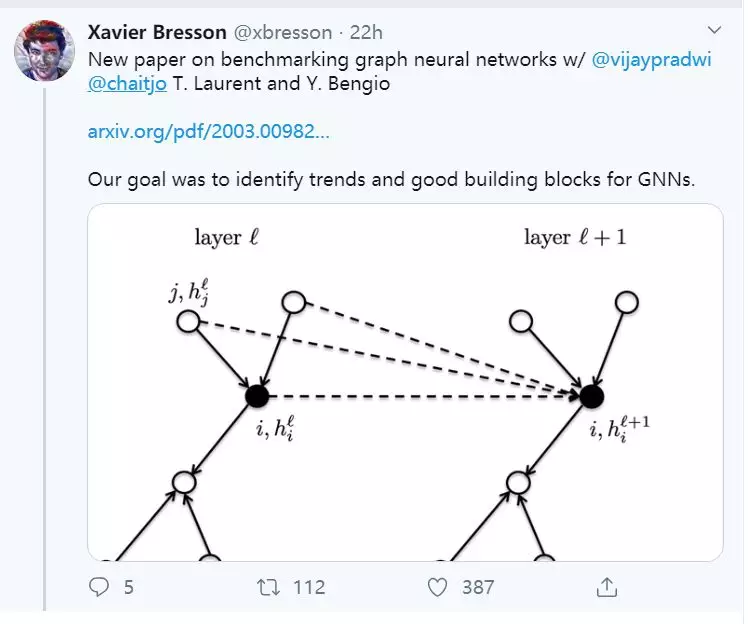

图神经网络(GNNs)已经成为分析和学习图数据的标准工具。它们已经成功地应用于无数的领域,包括化学、物理、社会科学、知识图谱、推荐和神经科学。随着这个领域的发展,识别架构和关键机制变得至关重要,这些架构和关键机制可以泛化图的大小,使我们能够处理更大、更复杂的数据集和域。不幸的是,在缺乏具有一致的实验设置和大型数据集的标准基准的情况下,评估新GNN的有效性和比较模型变得越来越困难。在这篇论文中,我们提出了一个可复制的GNN基准测试框架,为研究人员方便地添加新的数据集和模型提供了便利。我们将该基准测试框架应用于数学建模、计算机视觉、化学和组合问题等新型中型图数据集,以建立设计有效GNNs时的关键操作。准确地说,图卷积、各向异性扩散、剩余连接和归一化层是开发健壮的、可伸缩的GNN的通用构件。

自(Scarselli et al., 2009; Bruna et al., 2013; Defferrard et al., 2016; Sukhbaatar et al., 2016; Kipf & Welling, 2017; Hamilton et al., 2017)图神经网络(GNNs)近年来引起了人们极大的兴趣,开发出了很有前途的方法。随着这个领域的发展,如何构建强大的GNN成为了核心问题。什么类型的架构、第一原则或机制是通用的、可推广的、可伸缩的,可以用于大型图数据集和大型图数据集? 另一个重要的问题是如何研究和量化理论发展对GNNs的影响?基准测试为回答这些基本问题提供了一个强有力的范例。它已被证明是有益的,在几个领域的科学推动进步,确定基本的想法,并解决领域特定的问题(Weber et al., 2019)。最近,著名的2012年ImageNet (Deng et al.,2009)挑战提供了触发深度学习革命的基准数据集(Krizhevsky et al., 2012; Malik, 2017)。国际团队竞相在大型数据集上生成最佳的图像分类预测模型。自从在ImageNet上取得突破性成果以来,计算机视觉社区已经开辟了一条道路,以识别健壮的体系结构和训练深度神经网络的技术(Zeiler & Fergus, 2014; Girshick et al., 2014; Long et al., 2015; He et al., 2016)。

但是,设计成功的基准测试是非常具有挑战性的:它需要定义适当的数据集、健壮的编码接口和用于公平比较的公共实验设置,所有这些都是可重复的。这样的需求面临几个问题。首先,如何定义合适的数据集?它可能很难收集有代表性的,现实的和大规模的数据集。这是GNNs最重要的问题之一。大多数发表的论文都集中在非常小的数据集,如CORA和TU数据集(Kipf & Welling, 2017; Ying et al., 2018; Velickovi ˇ c et al. ´ , 2018; Xinyi & Chen, 2019; Xu et al., 2019; Lee et al., 2019),其中所有的gnn执行几乎相同的统计。有些与直觉相反的是,没有考虑图结构的基线表现得和GNNs一样好,有时甚至更好(Errica et al., 2019)。这就提出了开发新的、更复杂的GNN架构的必要性问题,甚至提出了使用GNNs的必要性问题(Chen et al., 2019)。例如,在Hoang & Maehara(2019)和Chen等人(2019)的近期著作中,作者分析了GNNs的容量和组成,以揭示模型在小数据集上的局限性。他们声称这些数据集不适合设计复杂的结构归纳学习架构。

GNN文献中的另一个主要问题是定义常见的实验设置。正如Errica等人(2019)所指出的,最近关于TU数据集的论文在训练、验证和测试分割以及评估协议方面没有达成共识,这使得比较新思想和架构的性能变得不公平。目前还不清楚如何执行良好的数据分割,除了随机分割之外,后者已知会提供过于乐观的预测(Lohr, 2009)。此外,不同的超参数、损失函数和学习速率时间表使得很难识别架构中的新进展。

本文的贡献如下:

-

我们发布了一个基于PyTorch (Paszke et al., 2019)和DGL (Wang et al., 2019)库的基于GitHub的GNNs开放基准基础架构。我们专注于新用户的易用性,使新数据集和GNN模型的基准测试变得容易。

-

我们的目标是超越流行的小型CORA和TU数据集,引入中等规模的数据集,其中包含12k-70k图,节点大小为9-500个。提出的数据集包括数学建模(随机块模型)、计算机视觉(超级像素)、组合优化(旅行商问题)和化学(分子溶解度)。

-

我们通过建议的基准测试基础设施来确定重要的GNN构建块。图卷积、非istropic扩散、残差连接和归一化层对设计高效的GNN非常有用。

-

我们的目标不是对已发布的GNN进行排名。为特定的任务寻找最佳模型在计算上是昂贵的(并且超出了我们的资源),因为它需要使用交叉验证对超参数值进行彻底的搜索。相反,我们为所有模型确定了一个参数预算,并分析性能趋势,以确定重要的GNN机制。

-

数值结果完全可重复。通过运行脚本,我们可以简单地重现报告的结果。此外,基准基础设施的安装和执行在GitHub存储库中有详细的说明。