新型相机DVS/Event-based camera的发展及应用

点“计算机视觉life”关注,置顶更快接收消息!

本文简要介绍下近些年计算机视觉研究领域出现的一种新型视觉传感器 DVS(也称event-based camera,事件相机)

背景

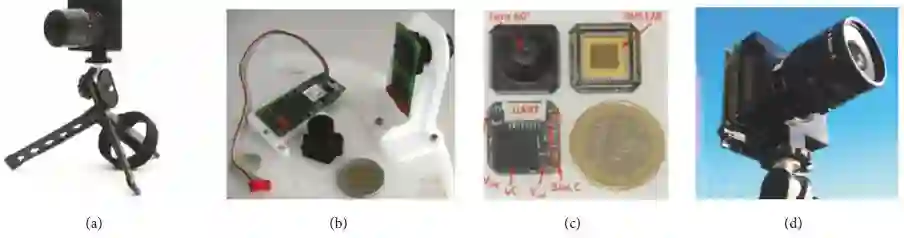

多年前,研究者们受人类视网膜原理的启发设计了一种神经拟态视觉传感器(NVS,现多称作DVS),其历史最早可追溯到1992年,Mahowald公开了其设计的第一个event-based神经拟态系统(address-event representation(AER) system),2003年Ruedi等人在空间对比和局部定位方面实现重大突破,同时Grenet等人在2005年利用该类传感器实现了第一个工业应用。但直到2006年,DVS(dynamic vision sensor)的发展才算真正的打开了神经拟态视觉传感器的大门。下图为几种神经拟态视觉传感器的实物图。可以看到神经拟态视觉传感器历经20多年的发展已经拥有多种型号,其中有的体积只有硬币大小,可以应用在多个领域。

简介

神经拟态视觉传感器使用基于事件驱动的方式来捕捉场景中的动态变化。与传统相机不同,神经拟态视觉传感器没有 “帧” 的概念。当现实场景中发生变化时,神经拟态视觉传感器会产生一些像素级的输出(即事件),一个事件具体包括(t, x, y, p),这里的 x, y 为事件在2D空间的像素坐标,t为事件的时间戳,p为事件的极性。事件的极性代表场景的亮度变化: 上升(positive) or 下降 (negative)。

神经拟态视觉传感器对数据存储和计算资源的需求非常小,并且其具有非常低的延迟,可以达到微秒级!!!传统相机在固定频率下产生一系列帧图片,其关键问题是在相邻俩帧之间会丢失掉很多关键信息,并且传统相机在内存,能量损耗以及延迟方面需求过大,这直接导致了很多算法的实时性非常低。以深度学习为例,为了实现目标检测等环境感知任务,不得不利用昂贵的硬件(GPUs)平台为其提供算力支撑。所以神经拟态视觉传感器的研究还是有一定前景的。

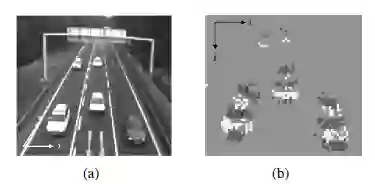

目前在这方面进行相关研究工作的机构主要有TUM,ETH以及新加坡等高校。下图为神经拟态视觉传感器与传统相机在相同背景下所产生的不同输出对比图,通过该图也许大家对这个陌生的视觉传感器会有些许概念。

应用

(1)特征跟踪

早在2006年,Litzenberger便利用神经视觉系统来估计车辆的速度,他们提出了一种基于事件点云数据斜率估计的方法,通过车辆的对比,实现了车辆的速度预估。下图中图(a)为真实场景,图(b)为神经拟态视觉传感器的二维点云数据图。此外,近几年,有人提出神经拟态视觉系统

的长期目标跟踪问题。该方法包含跟踪器,检测器和全局滑窗的训练。 相比于传统的基于帧的相机算法,该方法的实验结果显示其实时性非常高,这也表明了神经拟态视觉传感器的应用前景。

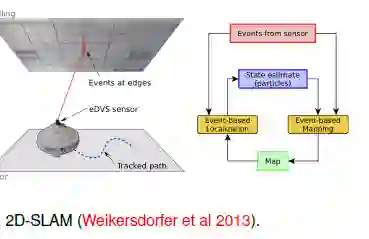

(2)SLAM

在2013年,Weikersdorfer等人在以前的工作基础上扩展到实时slam建图,机器人可以借助天花板上的特征进行自身定位。他们使用神经拟态视觉传感器传入的事件数据来更新状态估计,并提供似然图。 在定位过程中,通过事件数据和当前状态估计来更新地图。 该方法首次应用在2D 视觉SLAM场景。此外,在2014年,Weikersdorfer又将传统的基于帧的RGB-D传感器与DVS神经拟态视觉传感器进行融合,以便为事件数据提供深度信息。 利用事件数据的稀疏性,该算法比先前工作中提及的方法快20倍,并且可以同时创建稀疏的3D地图。

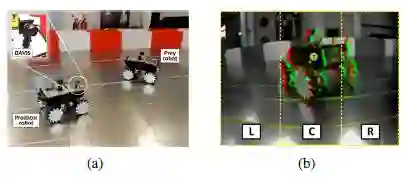

(3)Predator-Prey Robot

捕食者-猎物机器人是Moeys等人在2016年提出的。其把动态有源像素传感器(DAVIS,神经拟态视觉传感器的一种)安装在捕食者机器人上,使得捕食者机器人能够对猎物机器人进行跟踪(图(a))。 他们采用卷积神经网络(CNN)来处理事件数据,并且将视场(FOV)分成三个部分以区分猎物的位置,左(L),中(C)或右(R)(图(b))。使用1.25h标记的数据集离线训练CNN以识别猎物机器人的位置和大小。更令人惊讶的是,他们发现微小的CNN(只有10,000个参数)不仅可以检测到猎物,还可以检测到复杂背景场景中没有猎物。在此基础上,他们在2018年发布了捕食者 - 猎物 数据集(PRED18),通过较小的数据集和网络,研究自动驾驶中的车辆和路径检测要变的容易很多。

关于神经拟态视觉传感器的应用有很多,由于篇幅的原因这里不在进行介绍,欢迎大家关注公众号,在以后的推文中,我们会适当的对相关算法进行详细解读,敬请期待。

相关文章

欢迎关注公众号:计算机视觉life,一起探索计算机视觉新世界~

好文!给个好看啦~