视频中的多目标跟踪【附PPT与视频资料】

关注文章公众号

回复"高旭"获取PPT与视频资料

导读

目前视频多目标跟踪在智能安防、自动驾驶、医疗等领域都有非常多的应用前景,但同时也是计算机视觉中比较困难的一个问题。这主要是由于待跟踪的目标被遮挡造成的。本文主要介绍多目标跟踪目前的一些解决策略以及未来的发展趋势。

作者简介

高旭,北京大学信息科学技术学院在读硕士,本科毕业于中国传媒大学数字媒体技术专业,目前主要研究方向为视频的多目标跟踪,已在ACM Multimedia发表过文章。

1.Introduction

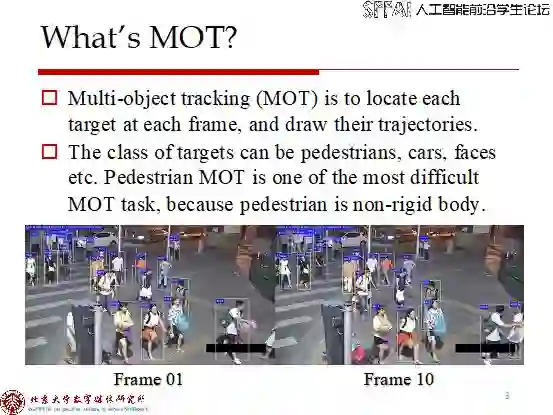

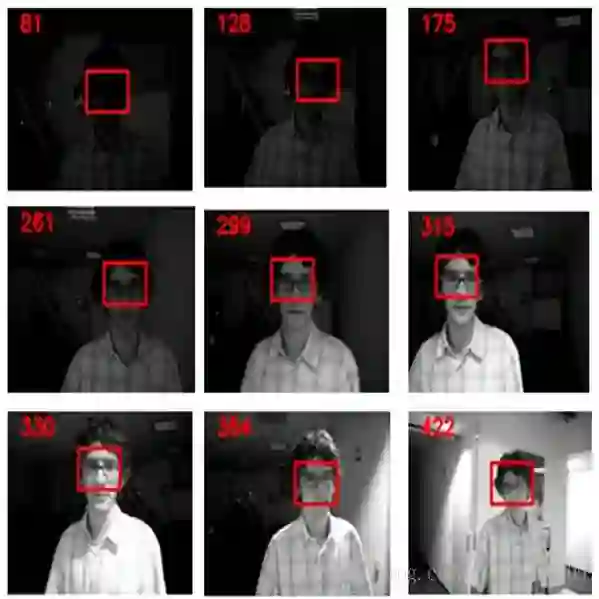

视频多目标跟踪(MOT)是目前计算机视觉中的一个很重要的问题。该问题的主要目标是将视频中的每个目标的轨迹画出来,也就是要把属于同一个目标的bounding box标成同一个ID。MOT在很多领域上都有应用,例如智能安防、自动驾驶、医学场景等等。MOT目前最大的挑战就是遮挡(Occlusion),两个目标之间发生的遮挡很容易造成ID的变换,这也成为很多MOT研究者攻克的目标。

2.Methods

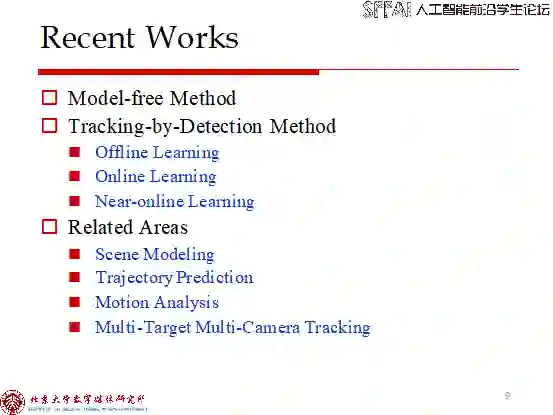

目前大多数的MOT工作的方向为Tracking-by-Detection的思路,即先将每一帧中的目标检测出来,然后对这些检测出来的框做跟踪。另一种思路就是Model-Free,即先将第一帧中的目标检测出来,然后在之后的帧中跟踪第一帧标注出来的目标。

Tracking-by-Detection的方法中多,从跟踪方式上可以分为三大类,包括离线跟踪(Offline MOT)、在线跟踪(Online MOT)以及近似在线跟踪(Near-Online MOT)。其中,离线跟踪的思路是,一次性输入所有的视频帧,将每帧中所有的目标检测出来,然后将问题转化为数据关联(Data Association)的问题。常见的离线跟踪优化方法包括图模型优化【1】以及分层的小轨迹关联方法【2】。

然而,当输入一段视频流的时候,当前帧之后的图像无法获得,因此无法用离线跟踪的方法进行求解,这时就要用到在线跟踪方法。在线跟踪方法只利用当前帧和之前帧的信息,并且只能改变当前帧的关联情况,而之前已经关联好的轨迹则无法修改。如果运算速度够快,在线跟踪是可以达到实时跟踪的。但是要注意,在线跟踪并不等于实时跟踪,它只是多目标跟踪的一种方式。可以看出,由于离线跟踪利用了比在线跟踪更多的信息,因此在线跟踪的精度肯定要低于离线跟踪。目前在线跟踪方法有很多突破方向,包括强化学习【3】、RNN网络【4】、单目标跟踪辅助【5】以及注意力机制【5】。

近似在线跟踪则是介于离线跟踪和在线跟踪方法之间的一种跟踪方法,即在处理视频流的时候,只利用当前帧以及之前帧的信息,但是允许修改最近T帧内的轨迹关联情况。目前也有一些工作是基于近似在线跟踪策略的【6】。

除了三种跟踪方法以外,在跟踪过程中还会参考很多信息来判断一段已经跟踪好的轨迹和一个候选检测框之间的相似程度。这些信息在在线跟踪中应用的最为广泛。这些信息一般包括:外观模型、运动模型、交互模型。外观模型和运动模型主要是衡量轨迹与候选检测之间的外观和运动相似性,很多时候,外观模型可以用CNN提取,运动模型可以用匀速直线运动模型或者RNN模型。此外,交互模型反映的是人和人之间位置的相互影响,有传统方法设计结构限制进行建模【7】,也有深度学习方法用一个统一的LSTM框架进行建模【4】。

3.Take Home Message

视频多目标跟踪仍然是个很艰巨的问题。未来在线跟踪的策略会越来越多,而且发展方向主要聚焦在:(1)利用单目标跟踪器做辅助;(2)利用注意力机制获得更鲁棒的外观模型;(3)强化学习方法;(4)将更多的推理引入进来,例如图网络。

4.Reference

【1】Li Zhang, Yuan Li, and Ramakant Nevatia. 2008. Global data associationfor multi- object tracking using network flows. In 2008 IEEE Conference onComputer Vision and Pattern Recognition (CVPR). 1–8.https://doi.org/10.1109/CVPR.2008.4587584

【2】Bing Wang, Gang Wang, Kap Luk Chan, and Li Wang. 2017. Tracklet Associationby Online Target-Specific Metric Learning and Coherent Dynamics Estimation.IEEE Transactions on Pattern Analysis and Machine Intelligence 39, 3 (March2017), 589–602. https://doi.org/10.1109/TPAMI.2016.2551245

【3】Yu Xiang, Alexandre Alahi, and Silvio Savarese. 2015. Learning toTrack: Online Multi-object Tracking by Decision Making. In 2015 IEEEInternational Conference on Computer Vision(ICCV).4705–4713.https://doi.org/10.1109/ICCV.2015.534

【4】Amir Sadeghian, Alexandre Alahi, and Silvio Savarese. 2017. Trackingthe Untrackable: Learning to Track Multiple Cues with Long-Term Dependencies.In 2017 IEEE International Conference on Computer Vision (ICCV). 300–311.https://doi.org/10.1109/ICCV.2017.41

【5】Qi Chu, Wan li Ouyang, Hongsheng Li, Xiaogang Wang, Bin Liu, and NenghaiYu. 2017. Online Multi-object Tracking Using CNN-Based Single Object Trackerwith Spatial-Temporal Attention Mechanism. In 2017 IEEE InternationalConference on Computer Vision(ICCV).4846–4855.https://doi.org/10.1109/ICCV.2017.518

【6】Wonggun Choi. 2015. Near-Online Multi-target Tracking withAggregated Local Flow Descriptor. In 2015 IEEE International Conference onComputer Vision (ICCV). 3029–3037. https://doi.org/10.1109/ICCV.2015.347

【7】Ju Hong Yoon, Chang-Ryeol Lee, Ming-Hsuan Yang,and Kuk-Jin Yoon. 2016. Online Multi-object Tracking via Structural ConstraintEvent Aggregation. In 2016 IEEE Conference on Computer Vision and PatternRecognition (CVPR). 1392–1400. https://doi.org/10.1109/CVPR.2016.155

SFFAI招募

现代科学技术高度社会化,在科学理论与技术方法上更加趋向综合与统一,为了满足人工智能不同领域研究者相互交流、彼此启发的需求,我们发起了SFFAI这个公益活动。SFFAI每周举行一期线下活动,邀请一线科研人员分享、讨论人工智能各个领域的前沿思想和最新成果,使专注于各个细分领域的研究者开拓视野、触类旁通。

SFFAI目前主要关注机器学习、计算机视觉、自然语言处理等各个人工智能垂直领域及交叉领域的前沿进展,将对线下讨论的内容进行线上传播,使后来者少踩坑,也为讲者塑造个人影响力。

SFFAI还将构建人工智能领域的知识树(AI Knowledge Tree),通过汇总各位参与者贡献的领域知识,沉淀线下分享的前沿精华,使AI Knowledge Tree枝繁叶茂,为人工智能社区做出贡献。

这项意义非凡的社区工作正在稳步向前,衷心期待和感谢您的支持与奉献!

历史文章推荐: