GAU-α:尝鲜体验快好省的下一代Attention

在FLASH:可能是近来最有意思的高效Transformer设计中,我们介绍了 GAU(Gated Attention Unit,门控线性单元),在这里笔者愿意称之为“目前最有潜力的下一代 Attention 设计”,因为它真正达到了“更快(速度)、更好(效果)、更省(显存)”的特点。

开源地址:

GAU-α

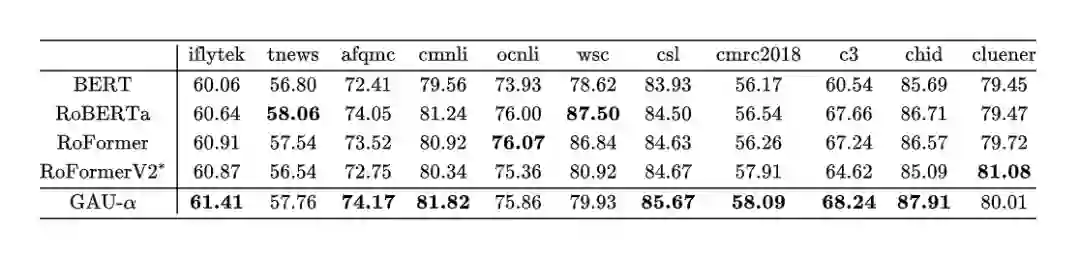

首先介绍一下开源出来的“GAU-α”在 CLUE 任务上的成绩单:

从表中可以看出,除了 WSC 这个数据量极少的“异类”外,GAU-α 在多数任务上都有优势,并且除了 WSC 外的平均成绩是最好的。其中,RoFormerV2* 与 GAU-α 的比较是最为公平的,因为它们的训练脚本、训练数据、整体结构都是一样的,唯一不同就是 GAU-α 是将 RoFormerV2* 中的 Attention+FFN 组合换成了两层 GAU,两者对比充分显示出了 GAU 设计“更好”的特点。

此外,我们在RoFormerV2:自然语言理解的极限探索介绍过 RoFormerV2 对结构进行了简化,从而获得更快的速度,具有同样整体结构的 GAU-α 也是如此,所以 GAU-α 的速度是比表中的 BERT、RoBERTa、RoFormer 都要快的,但平均效果却更胜一筹。更进一步的测试显示,当序列长度超过 512 时,GAU-α 的速度开始超过同样精简过的 RoFormerV2,并且显存占用更低,越长则对 GAU-α 更有利。

训练

模型架构:GAU-α 就是将 RoFormerV2 的 Attention+FFN 换成了两层 GAU,在之前的文章中我们比较过两层 GAU 的计算量和参数量大致相当于 Attention+FFN 组合,所以这样的替换是合理的;RoFormerV2 的特点是保留了 Post Norm 结构,去掉了所有的 Bias 项,并且 Layer Norm 换成了 RMS Norm 的最简单变体,在 GAU-α 中也是如此。

归一化:在听说Attention与Softmax更配哦~中我们讨论过 Attention 的归一化问题,GAU-α 的 Attention 归一化选取了其中笔者自行提出的具有较好外推能力的熵不变性 Softmax(在 bert4keras 中暂称为 softmax_plus)。

训练方式:在初始化方面笔者按照训练1000层的Transformer究竟有什么困难?进行了调整,因此无须 Wamrup 就可以直接训练,优化器用的是 LAMB,学习率分段线性衰减;预训练任务用的是全词 MLM,分词工具用百度的 LAC,这些跟 RoFormerV2 都是对齐的。好像值得一提的也就这么多了,确实没进行多大的改变。除了在归一化方式上花了点时间进行测试,其他方面也没多费时间,直接训练就得到了不错的效果。

小结

GAU 是笔者认为的“目前最有潜力的下一代 Attention 设计”,本文分享了 GAU 的一些训练经验,并开源了一个尝鲜版“GAU-α”。

PaperWeekly独家周边盲盒

限量 200 份,免费包邮送

周边盲盒将随机掉落

众多读者要求返场的爆款贴纸

炼丹师必备超大鼠标垫

让你锦鲤护体的卡套组合

扫码回复「盲盒」

立即免费参与领取

👇👇👇

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧