许多实际应用需要对长序列时间序列进行预测,例如用电计划。长序列时间序列预测(LSTF)对模型的预测能力要求很高,即能够高效捕获输出和输入之间精确的长程依赖。近年来的研究表明,Transformer 具有提高预测能力的潜力。然而,Transformer 存在几个严重的问题,因而无法直接应用于 LSTF,比如二次时间复杂度、高内存使用率以及编码器 - 解码器架构的固有局限。

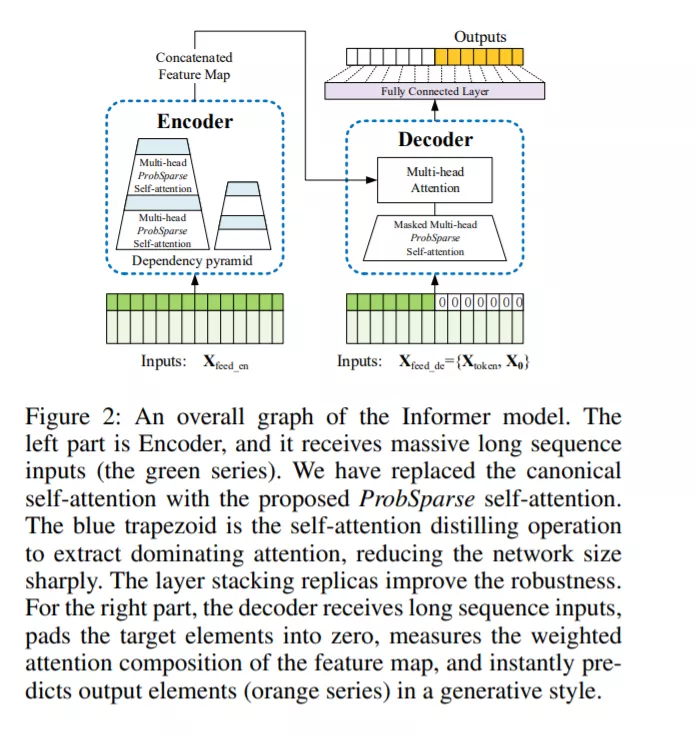

为解决这些问题,该研究为 LSTF 设计了一个基于高效 transformer 的模型——Informer,该模型具备三个特征:

1)ProbSparse 自注意力机制,其时间复杂度和内存使用达到 O(L log L),在序列依赖对齐方面具有不错的性能; 2)自注意力蒸馏通过将级联层输入减半来突出注意力,并且能够高效地处理极长的输入序列; 3)尽管生成风格解码器在概念上非常简单,但它会在一次前向操作中预测较长的时序序列,而不是逐步预测,这极大地提高了长序列预测的推断速度。

成为VIP会员查看完整内容

相关内容

Arxiv

1+阅读 · 2021年3月30日

Arxiv

1+阅读 · 2021年3月28日