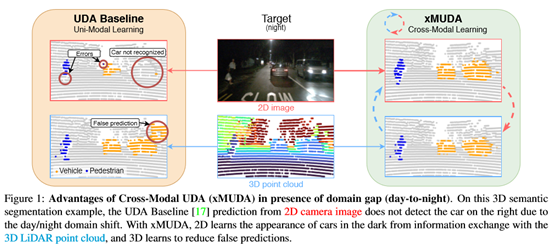

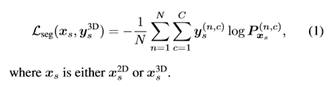

CVPR 2020 | 利用跨模态无监督域自适应进行三维语义分割

登录查看更多

相关内容

专知会员服务

78+阅读 · 2020年2月25日

Arxiv

78+阅读 · 2019年11月10日

Arxiv

7+阅读 · 2019年8月28日

Arxiv

12+阅读 · 2018年9月27日