ECCV 2022 | 港中文MMLab:基于Transformer的光流

©PaperWeekly 原创 · 作者 | Zhaoyang Huang

单位 | 香港中文大学MMLab

研究方向 | 视觉关联性学习

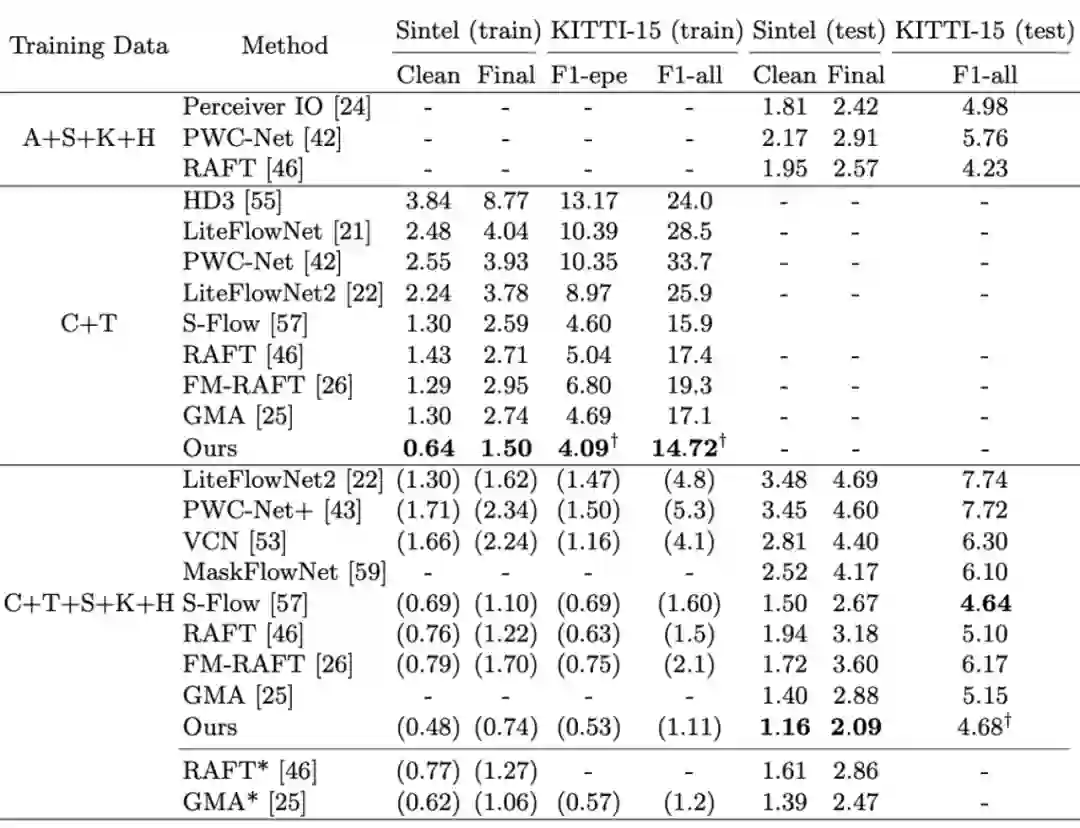

只在 FlyingChairs+FlyingThings 上训练后,FlowFormer 在 Sintel Training 的 clean 与 final 两个子集中分别取得了 0.64 与 1.50 AEPE。与之前发表的最好结果(1.29 和 2.74)相比,误差下降了 50.4% 和 45.3%,体现了其卓越的泛化性。在公开的 Sintel benchmark(test)上,FlowFormer 在clean 和 final 两个子集中取得了 1.159 和 2.088 AEPE,降低了此前发表的最优误差(1.388 和 2.47)达 16.5% 和 15.5%。

论文标题:

FlowFormer: A Transformer Architecture for Optical Flow

ECCV 2022

https://drinkingcoder.github.io/publication/flowformer/

论文介绍

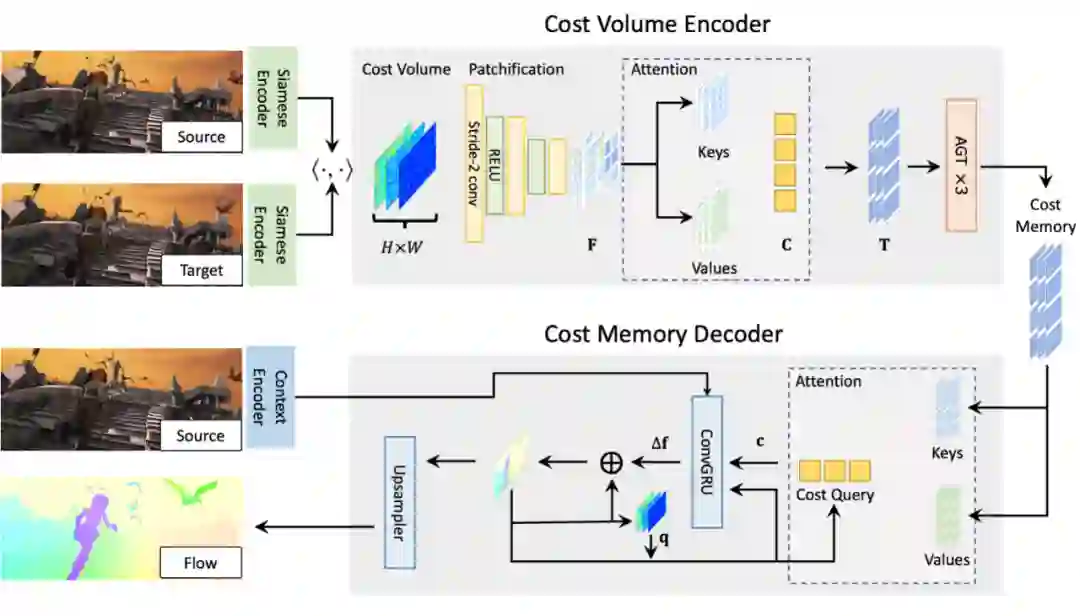

FlowFormer 基于 RAFT 的思想,探索了使用 Transformer 对其进行全方位改进,包含了以下重要模块:1)Alternate-Group Transformer (AGT)层,将 4D cost volume 投影至隐空间编码为cost memory;2) Recurrent Transformer Decoder,使用 dynamic positional cost query 循环的从 cost memory 中提取信息来优化光流估计;3)首次验证了使用 ImageNet 预训练的 Transformer 来编码图像特征可以提升光流估计性能。

相比于 CNN,Transformer 破除了局部偏差(locality bias)并能进行长程建模。PerceiverIO 开创性的使用纯 Transformer 来学习光流估计,它直接对图像像素 tokenization 并用一个通用的输入-输出映射来学习光流估计。由于它没有用任何针对光流的信息,如视觉相似性,因此其需要大量的参数参数和训练数据来学习(约 80 倍的 RAFT 训练数据量)。因此我们提出一个问题:我们能否同时获益于 Transformer 的长程建模能力并从视觉相似性信息中估计光流?针对这个问题,该论文提出了 FlowFormer。

算法细节

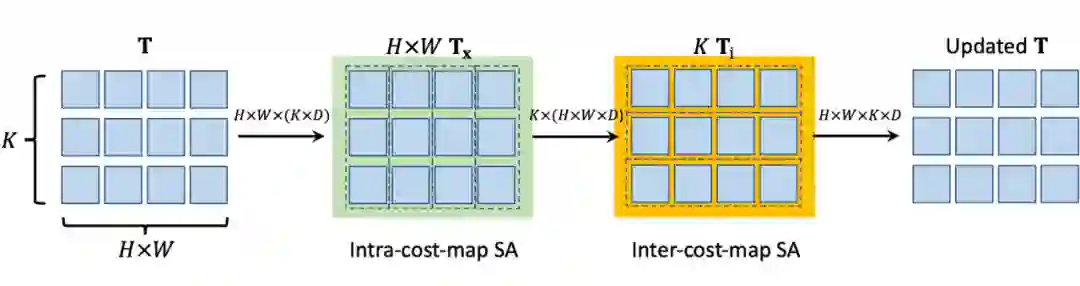

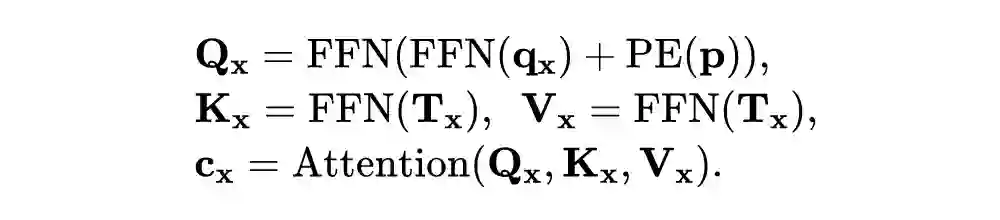

该论文观察到,对每个像素而言,光流估计的信息来源是当前像素与目标图像中所有像素的相似性,即 H x W 的 cost map。因此将每个像素的 cost map 投到同一个隐空间中形成 K 个 token,即从 H x W x H x W 的 4D cost volume 转化成H x W x K 个 token,其中每个 token 维度为 D。在此基础上我们使用轮换分组(alternate-group)Transformer 对这些 token 进行编码。

AGT 轮流使用这两种分组,对组内的 token 使用 Transformer 编码,这样信息可以在所有 token 之间进行传播但算力相比同时对所有 token 使用 Transformer 又大幅下降。我们使用了三层 AGT,最终得到 H x W x K 个 token,并将其作为编码后的 cost memory。

泛化性:在 FlyingChairs 于 FlyingThings(C+T)上训练,在 Sintel 与 KITTI 的训练集上计算光流误差,这种方法能评测光流模型的泛化性。如上表所示,FlowFormer 在 Sintel 训练集 clean 与 final 两个子集上的误差分别是 0.64 和 1.50,在 KITTI-15 训练集的 F1-epe 与 F1-all 分别达到了 4.09 和 14.72。与 GMA 相比,FlowFormer 在 Sintel 训练集两个子集上分别减少了 50.4% 与 45.3% 的误差,在 KITTI-15 F1-all 上减少了 13.9%,充分展示了 FlowFormer 优异的繁华性能。

Sintel Benchmark 上的精度分析:在 FlyingChairs、FlyingThings、Sintel 训练集这三个数据集上训练,在 Sintel 测试集上评测。FlowFormer 将误差降到了 1.16 和 2.09,下降比率达到了 16.5% 和 15.5%。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧