【中山大学&腾讯等】可靠图深度学习的最新进展:对抗攻击、固有噪声和分布转移

摘要:

https://www.zhuanzhi.ai/paper/c3f2da099c06fba725a9c78bac53ee4a

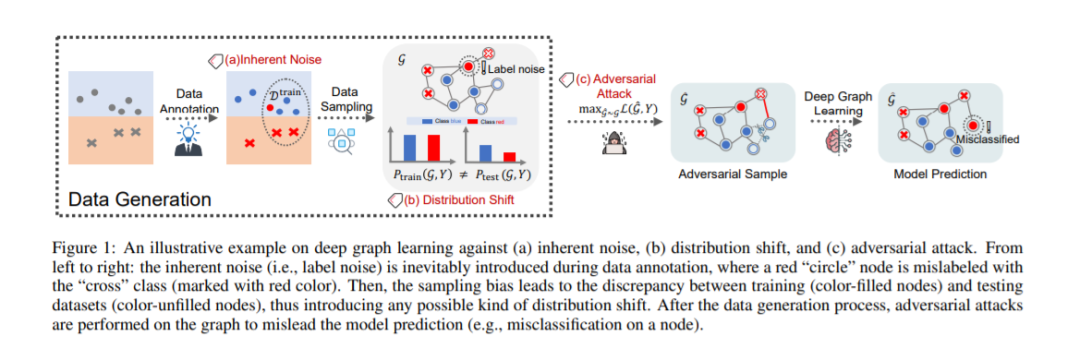

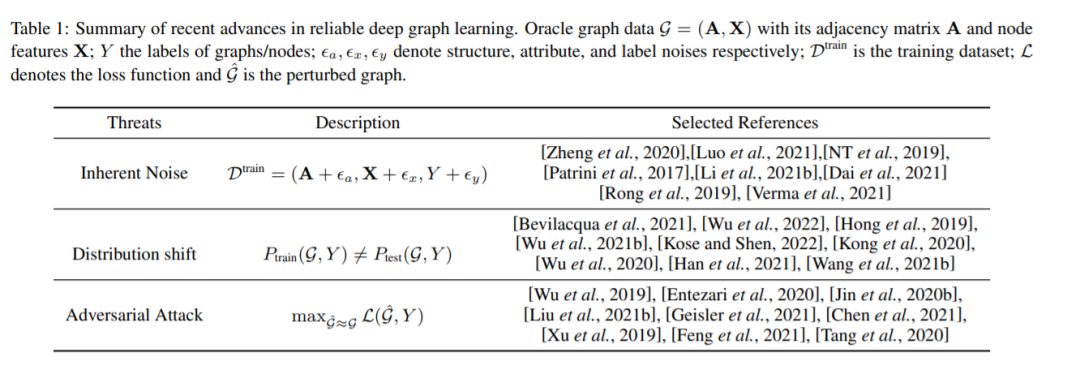

近年来,基于图神经网络(GNNs)的深度图学习(DGL)在许多重要领域都取得了显著进展,从金融等商业场景(如欺诈检测和信用建模)[Dou et al., 2020; Yang et al., 2020]和电子商务(如推荐系统)[Wu et al., 2021a],到诸如药物发现和先进材料发现等科学领域[Guo et al., 2021; Wu et al., 2017]。尽管取得了进步,但将各种DGL算法应用到实际应用中仍面临一系列的可靠性威胁。在较高的层次上,我们将这些威胁分为三个方面,即固有噪声、分布转移和对抗性攻击。具体来说,固有噪声是指图结构、节点属性和节点/图标签中的不可约噪声。分布转移是指训练分布和测试分布之间的转移,包括域泛化和子种群转移。对抗性攻击是一种操纵性的人类行为,旨在通过精心设计的模式或对原始数据的扰动导致模型的不当行为。典型的例子包括对抗性样本[Zugner¨et al., 2018]和后门触发器[Xi et al., 2021]。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“RDGL” 就可以获取《【中山大学&腾讯等】可靠图深度学习的最新进展:对抗攻击、固有噪声和分布转移》专知下载链接

请扫码加入专知人工智能群(长按二维码),或者加专知小助手微信(zhuanzhi02),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG、论文等)交流~

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月18日

Arxiv

0+阅读 · 2022年4月15日

Arxiv

31+阅读 · 2021年9月27日