CIKM 2021 | 基于池化结构搜索的图分类

Pooling Architecture Search for Graph Classification

https://arxiv.org/abs/2108.10587

https://github.com/AutoML-Research/PAS

备注:该论文已经被数据挖掘会议 CIKM 2021 接收,欢迎大家关注。如有任何问题,欢迎联系 weilanning@ict.ac.cn。

AutoSF: Searching scoring functions for knowledge graph embedding. ICDE 2020. (AutoSF)

Interstellar: Searching Recurrent Architecture for Knowledge Graph Embedding. NeurIPS 2020. (Interstellar)

Search to aggregate neighborhood for graph neural network. ICDE 2021. (SANE)

Simplifying Architecture Search for Graph Neural Network. CIKM-CSSA 2020 (SNAG)

Searching to Sparsify Tensor Decomposition for N-ary relational data. WWW 2021. (S2S)

DiffMG: Differentiable Meta Graph Search for Heterogeneous Graph Neural Networks. KDD 2021. (DiffMG)

-

TabGNN: Multiplex Graph Neural Network for Tabular Data Prediction. KDD-DLP 2021. (TabGNN)

参考文献

[1] Design Space for Graph Neural Networks. NeurIPS 2020.

[2] Neural architecture search with reinforcement learning. ICLR 2017

[3] Regularized evolution for image classifier architecture search. AAAI 2019

[4] DARTS: Differentiable architecture search. ICLR 2019

[5] SNAS: stochastic neural architecture search. ICLR 2019

[6] Distinguishing enzyme structures from non-enzymes without alignments. JMB 2003

[7] How powerful are graph neural networks? ICLR 2019

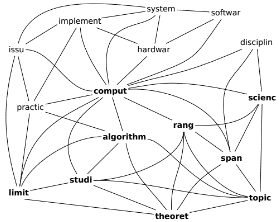

[8] Text categorization as a graph classification problem. ACL 2015

[9] 图1左:https://www.mdpi.com/2078-2489/1/2/60/htm, 中:https://medium.com/analytics-vidhya/social-network-analytics-f082f4e21b16, 右:论文[8]。

[10] An end-to-end deep learning architecture for graph classification. AAAI 2018.

[11] Hierarchical graph representation learning with differentiable pooling. NeurIPS 2018.

[12] Self-Attention Graph Pooling. ICML 2019

[13] ASAP: Adaptive Structure Aware Pooling for Learning Hierarchical Graph Representations. AAAI 2020

[14] Graph u-nets. ICML 2019.

[15] Graphnas: Graph neural architecture search with reinforcement learning. IJCAI 2020.

[16] Simplifying Architecture Search for Graph Neural Network. CIKM-CSSA 2020

[17] Search to aggregate neighborhood for graph neural network. ICDE 2021

[18] Graph Neural Network Architecture Search for Molecular Property Prediction. Arxiv 2020

特别鸣谢

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧