【泡泡一分钟】通过对抗性参数最优化实现3D人物位姿检测(3dv-14)

每天一分钟,带你读遍机器人顶级会议文章

标题:Adversarially Parameterized Optimization for 3D Human Pose Estimation

作者:Dominic Jack, Frederic Maire, Anders Eriksson and Sareh Shirazi @QUT

来源:3dv-2017(International Conference On 3D vision)

播音员:格子

编译:郭鑫

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

我们提出了一种对抗性参数最优化框架,可以在低维学习可能的人物位置参数,从2D信息求到3D位姿。我们训练了一个对抗性生成网络来“想象”可能的位姿,然后在这个想象的空间中找到一个和观测一致的位姿。

这个框架不需要场景/观测匹配并且可以在没有数据增强的情况下实现已知的几何不变性。这个算法允许实时配置,所以可以直接利用到已知的数值而不需要额外的训练,比如相机的内/外参或者已经提供的目标的高度。

在单张图像和连续图像中,我们使用这个框架通过投影的关节位置来检测3D人物位姿。通过非常简单的浅层网络结构达到了非常有竞争力的结果,同时,我们的代码开源。

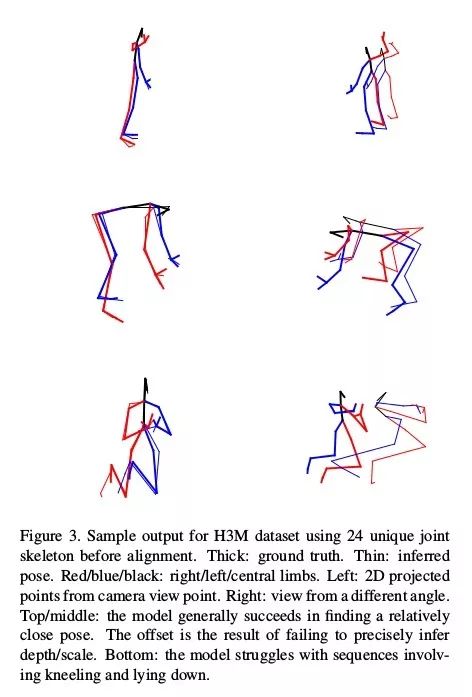

下图为这个框架通过2D位置真值得到的输出示例。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

回复关键字“3dv14”,即可获取本文下载链接。

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com