【泡泡一分钟】DeepVO:基于深度循环卷积神经网络的端到端视觉里程计(ICRA-18)

每天一分钟,带你读遍机器人顶级会议文章

标题:DeepVO: Towards End-to-End Visual Odometry with Deep Recurrent Convolutional Neural Networks

作者:Sen Wang, Ronald Clark, Hongkai Wen and Niki Trigoni

来源:ICRA 2017

编译:蔡纪源

播音员: 王肃

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

今天介绍的文章是“DeepVO: Towards End-to-End Visual Odometry with Deep Recurrent Convolutional Neural Networks”——DeepVO:基于深度循环卷积神经网络的端到端视觉里程计,该文章将发表在ICRA2017。

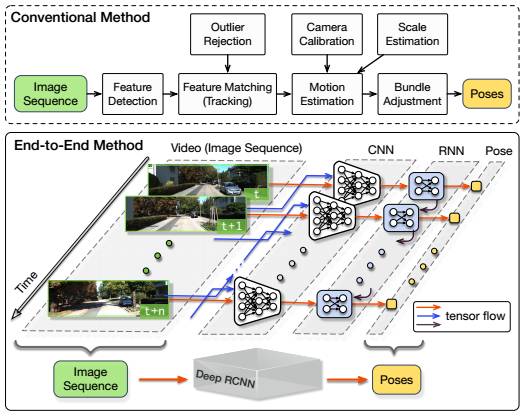

单目视觉里程计(Visual odometry,VO)是机器视觉领域一项重要的研究问题,目前大多数视觉里程计方法都是基于标准框架开发的,包括特征提取,特征匹配,运动估计,局部优化等模块。尽管其中一些方法已经展现了优越的性能,但通常仍需要精心设计和专门进行微调才能适应不同的任务和环境需求。而且,单目视觉里程计缺失尺度信息,往往需要一些先验知识来恢复绝对尺度估计。

本文使用深度递归卷积神经网络(RCNNs),提出了一种新颖的端到端单目VO的框架。由于它是以端到端的方式进行训练和配置的,因此它可以直接从一系列原始的RGB图像(视频)中计算得到姿态,而无需采用任何传统VO框架中的模块。

图1.传统的单目视觉里程计框架与提出的端到端方法的对比图。

基于RCNN,一方面它可以通过卷积神经网络(Convolutional Neural Network)自动学习VO问题的有效特征表示,另一方面可以通过递归神经网络(Recurrent Neural Network)对时序模型(运动模型)、数据关联模型(图像序列)进行隐式建模。

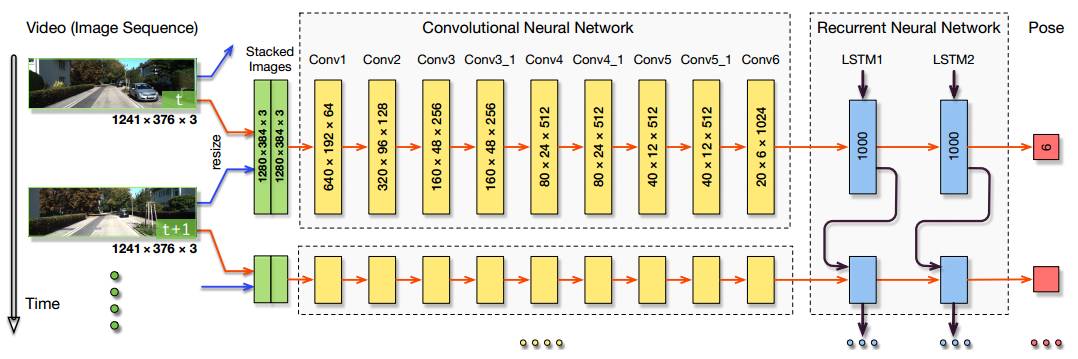

图2.本文提出的基于RCNN的单目VO系统结构图。

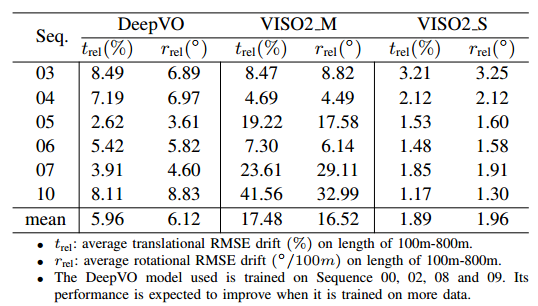

图3.本文算法与单目VISO2算法在数据集上的运行结果对比。

最后,作者在KITTI VO数据集上进行的大量实验,显示提出的方法能与目前最先进方法抗衡,也验证了端到端的深度学习技术可以成为传统VO系统的一种可行的补充。

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

回复关键字“DeepVO”,即可获取本文下载链接。

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com