现在的人工智能是否走上了数学的极端?

极市导读

数字电路、集成电路的高速发展让计算机的计算和存储能力达到了新的高度,我们开始实现一些从前不可能的事情,人工智能也因此得到快速的发展。但目前的人工智能好像都是基于逻辑和结构的基础上寻找答案,那么还存在所谓的智能吗?现在的人工智能是否走上了数学的极端呢? >>加入极市CV技术交流群,走在计算机视觉的最前沿

原问题:人工智能在当下如火如荼,有一个很重要的原因是计算机的计算和存储能力达到了一个新的高度,让原来不敢想的事情成为可能。但是,这种计算能力的高度是基于数字电路、集成电路的高速发展带来的。

目前我所了解的人工智能领域,包括机器视觉,包括语义分析知识图谱等,都是基于逻辑和结构的基础上去找答案,去找特征,去组织关系,是数字的结构的。但最大的问题就在这里,当开发者依据个人的倾向去组织数据确定逻辑和结构的时候,已经不存在所谓的智能了,就已经将核心固化了。

所以,我理解智能应该是存在很大程度上的巧合的,也存在很大程度上的随机,凭借数学公式是不能实现的。所以,我想,在数字技术之上的模拟技术是否才是这个问题的答案?有么有类似的案例?结果怎么样?

-------------------------------------------------------------------------

这是一个很有价值的问题,对于初学者尤其重要。从题主的补充说明中,可以看出题主进行过深入的思考。只是题主或许不太熟悉人工智能的早期发展历史,同时稍微混淆了几个概念。下面,我尝试提供一些观点。

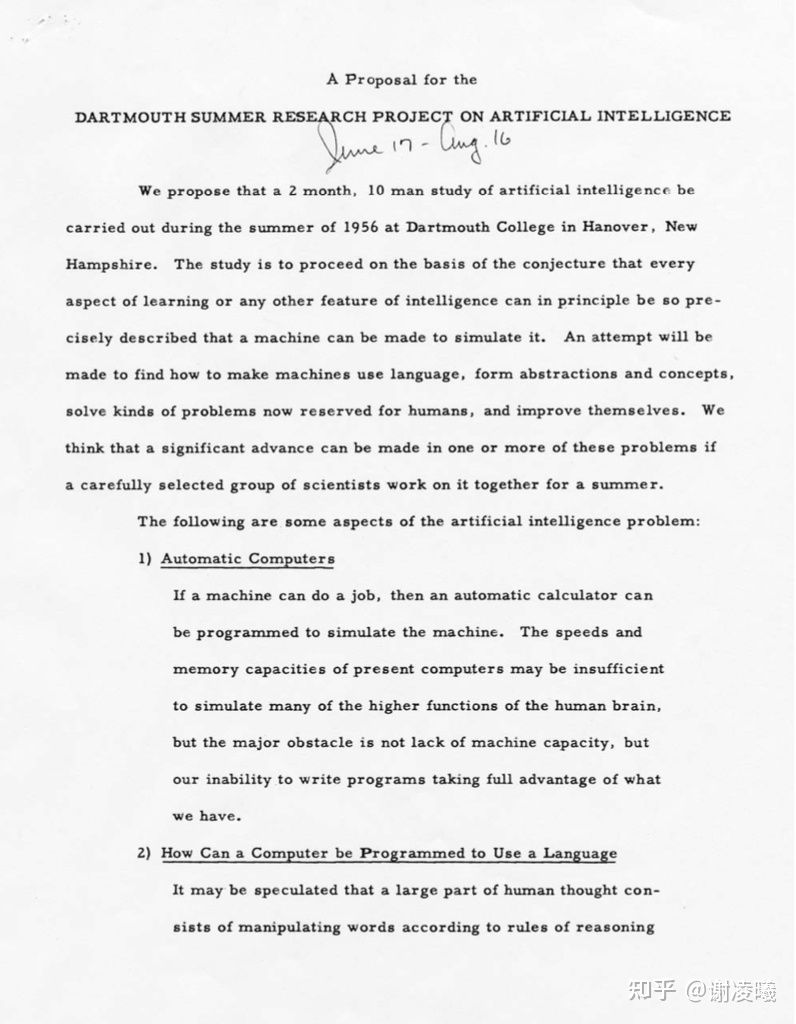

按照普遍的认知,现代意义上的人工智能,正式提出于1956年的达特茅斯会议。相比于古早时期的幻想(如中国战国时期的偃师和西方中世纪炼金术中的Homunculus),1956年的定义明确了“智能可以独立于肉体存在” ,然而站在今天的视角看,当时人们对于人工智能的定义仍然很不清晰。从当年proposal的首页截图中,可以看到他们提出的前两个问题是“自动化的计算机”和“如何编写程序让计算机学会使用语言”。前者显然是非常模糊的说法;而后者(也许是受到了图灵测试[1]的影响)看似跟今天的自然语言处理非常相似,可细看描述就会发现,先驱们并没有把具体任务形式化地定义下来。也许是这些不明确的定义给了人们莫名的信心,当时的10个参与者提出了“两个月内解决人工智能基础问题” 的豪言壮语,让今天的人们忍俊不禁。后来的事情大家是知道的:这些基础问题直到今天也没有解决(甚至接近解决),但是这10位先驱中有5人先后荣获图灵奖。所以挖坑早是多么重要!(最后一句划掉)

达特茅斯暑期研究计划的proposal首页如果对人工智能早期历史感兴趣,可以浏览维基百科的人工智能史页面,也可以开2倍速听下我的讲解(第1课第2部分):

谢凌曦:第1课 人工智能综述:https://zhuanlan.zhihu.com/p/452444873

回到正题上来。无论早期人工智能的定义多么幼稚,有一个事实是确定的:现代人工智能,脱胎于数学、神经科学和当时尚在襁褓中的计算机科学。我们再看维基百科对于人工智能的定义:

人工智能(英语:artificial intelligence,缩写为AI)亦称智械、机器智能,指由人制造出来的机器所表现出来的智能。通常人工智能是指通过普通计算机程序来呈现人类智能的技术。

也就是说,现代人工智能的共同特点,就是通过高速计算机来实现(有时候甚至可以说复现)人类行为。以此可以回应题主的第一段话:确实,如果未来人类没有造出仿生机器,那么人工智能只能通过数字集成电路来实现。 一个有趣的例子是,科学家们通过把电极插入老鼠和猴子的大脑,可以记录它们对于各种外界刺激的反应。如果我们将这个系统理解为一个机器,那么它确实在一定程度上不依靠数学实现了智能(或许应该叫做鼠工智能或者猴工智能)。当然,出于伦理的考虑,我们是绝无可能把人脑当成机器来使用的(虽然有各种类似的研究)。

再回到主线上来。题主第二段说,“目前我所了解的人工智能领域,……,都是基于逻辑和结构的基础上去找答案,去找特征,去组织关系,是数字的结构的”。正是通过这句话,我判断题主不太熟悉早期人工智能史。事实上,从1950年代开始,人工智能就存在着三个彼此竞争的流派:逻辑演绎、归纳统计、类脑计算。直至今日,也没有人从理论上论证三个流派孰优孰劣,虽然归纳统计在今天占据了压倒性的优势(包括机器学习和从中发展出的深度学习)。这其中,类脑计算的思想很终极也很容易理解:搞清楚人脑是如何工作的,然后用数学模型去复现它;可惜的是,虽然21世纪是生命科学的世纪(大雾),脑科学的进展还是没能满足人工智能的需求。

除了高冷的类脑计算派,逻辑演绎派和归纳统计派也进行了长达数十年的竞争。它们的本质分歧在于:逻辑演绎派希望能对任何任务建立起规则,并且通过严谨的逻辑推理来解决问题;而归纳统计派则认为,严格建模即不现实也不必要,“这个世界就是描述它自己最好的模型”[2]。1970年代,逻辑演绎派在符号人工智能的框架下搞出了专家系统[3],一举带来人工智能的第二次繁荣期;但是很快,人们就发现专家系统的使用场景过于受限,同时维护规则库的开销太大,人工智能进入第二次低谷期。带领业界走出第二次低谷期的,正是归纳统计派,包括后来被归为亚符号人工智能的统计学习理论[4]。再后来,手工设计模型遇到瓶颈,而1950年代就存在的连接主义(人工神经网络)在大数据的驱动下,进化为深度学习理论,基本上统治了人工智能领域,直至今日。

因此对于第二个问题的回答是:人工智能里存在其他学派,但是它们目前还没有跟归纳统计派抗衡的能力。但是,统计学习方法的缺陷是非常明显的(这正是题主的观点,也是业界普遍的担忧)。从我个人的观点看,我不相信统计学习能够实现真正的人工智能,但是它确实是当前人类掌握的最有力工具。特别是在深度学习出现以后,统计学习方法能够解决很多受限场景下的实际问题,因而形成了正向循环,获取了政府和工业界的大量投资。因而,从观感上,有一种“人工智能只剩下统计学习”的错觉,但我相信其他流派也还在努力,等待翻身的一天。

最后,我不太能够从数学上理解“智能存在很大程度上的随机”的含义。不知道是否有生物学或者遗传学专家,能够从物种进化的角度来分析。不过针对第三段所说的“数字技术之上的模拟技术”,我相信前面的介绍已经多少回答了这个问题:类脑计算就是希望模拟人脑,但是当前还不能在实际问题中看到应用。这里必须澄清:虽然人脑也是分区分层的,不过我向来反对将深度神经网络看做类脑计算(brain-like computing),它最多只能算做脑启发的计算(brain-inspired computing)。许多年前,我听过一个有趣的哲学辩论:人类的大脑,是否能够理解大脑本身?可惜我现在找不到相关材料了。

总之,人工智能的范畴很广,价值也很大。许多我们能够想到的问题,之前都已经有人做过各种各样的思维实验。我强烈建议初学者们,不要仅仅局限在深度学习的框架内,有空可以看看早期各种有趣的故事,至少要搞清楚业界是怎样一步步走到深度学习的,这对于形成完整的人工智能世界观大有裨益。 最后的最后,说到未来,那一定是“道阻且长”,只有保持永恒的探索欲,才有可能突破当前瓶颈,找到新的道路。

参考

1.^Turing A M. Computing machinery and intelligence[M]//Parsing the turing test. Springer, Dordrecht, 2009: 23-65.

2.^Brooks R A. Elephants don't play chess[J]. Robotics and autonomous systems, 1990, 6(1-2): 3-15.

3.^Shortliffe E H, Buchanan B G. A model of inexact reasoning in medicine[J]. Mathematical biosciences, 1975, 23(3-4): 351-379.

4.^Vapnik V. The nature of statistical learning theory[M]. Springer science & business media, 1999.

公众号后台回复“CVPR2022”获取论文分类合集下载~

CV算法项目实践

极市打榜是极市平台推出的一种算法项目合作模式。参与打榜除了可获得定额奖励外,还有机会与平台签约合作,持续获得算法的订单分成收益。平台支持已标注数据集+免费算力+群内技术答疑!

如果你想要获得真实的企业项目实践经验,或者是希望获得一笔丰厚的副业收入,欢迎扫码了解&报名:

扫码查看(报名)

40+算法打榜

备注“打榜”

进入打榜技术交流群