速度提升一倍,无需实例掩码预测即可实现全景分割

选自arXiv

作者:Daan de Geus等

机器之心编译

参与:高璇、张倩

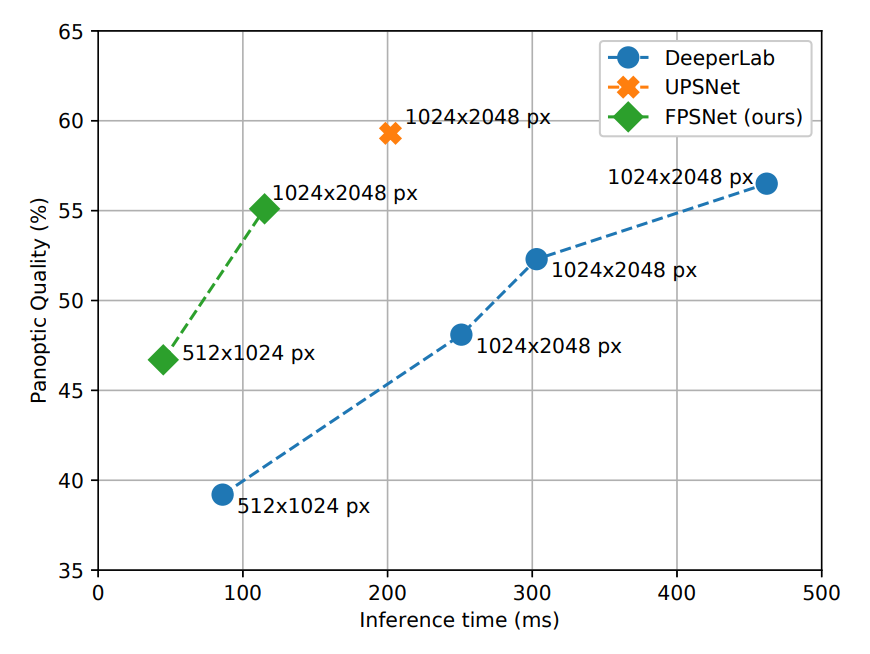

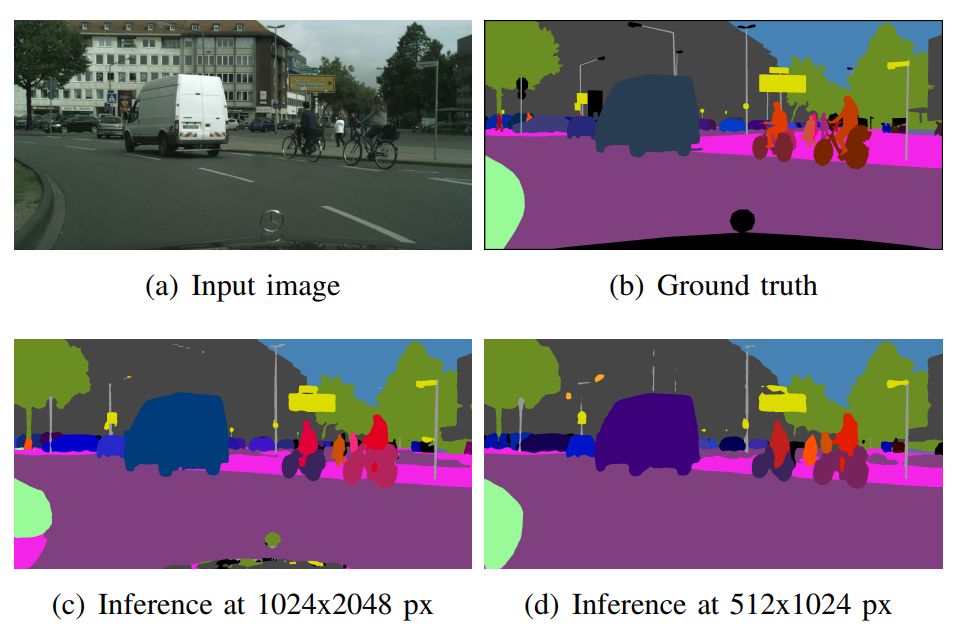

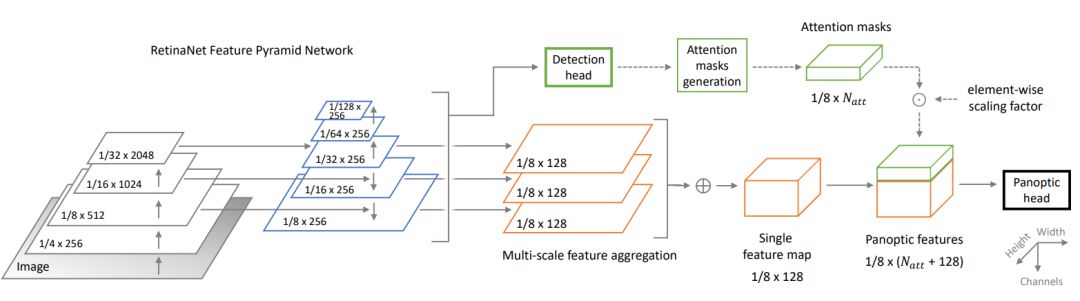

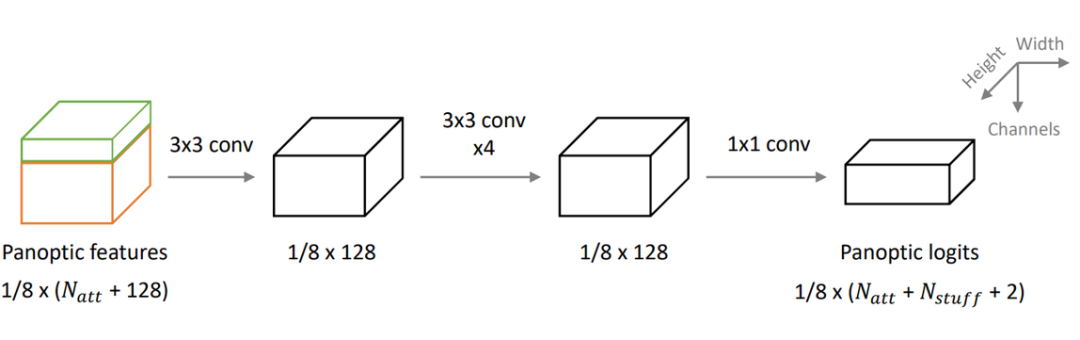

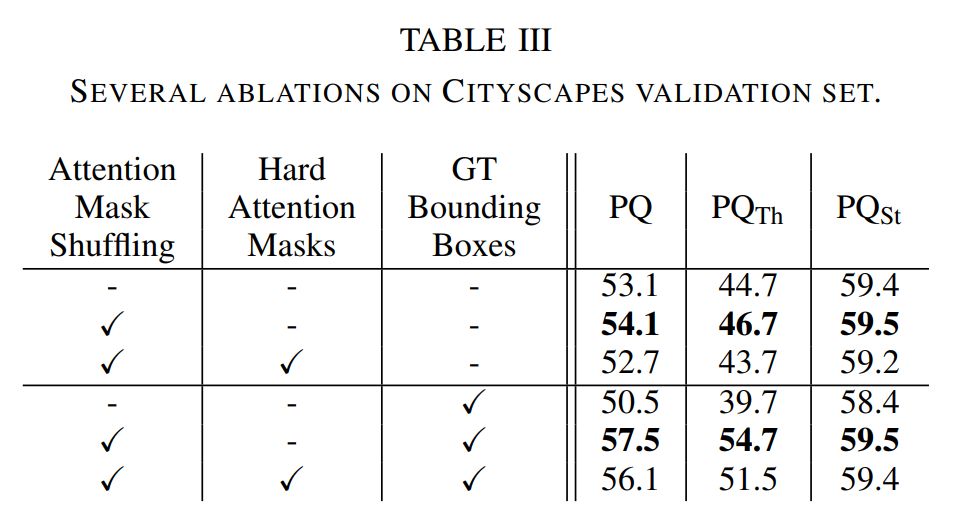

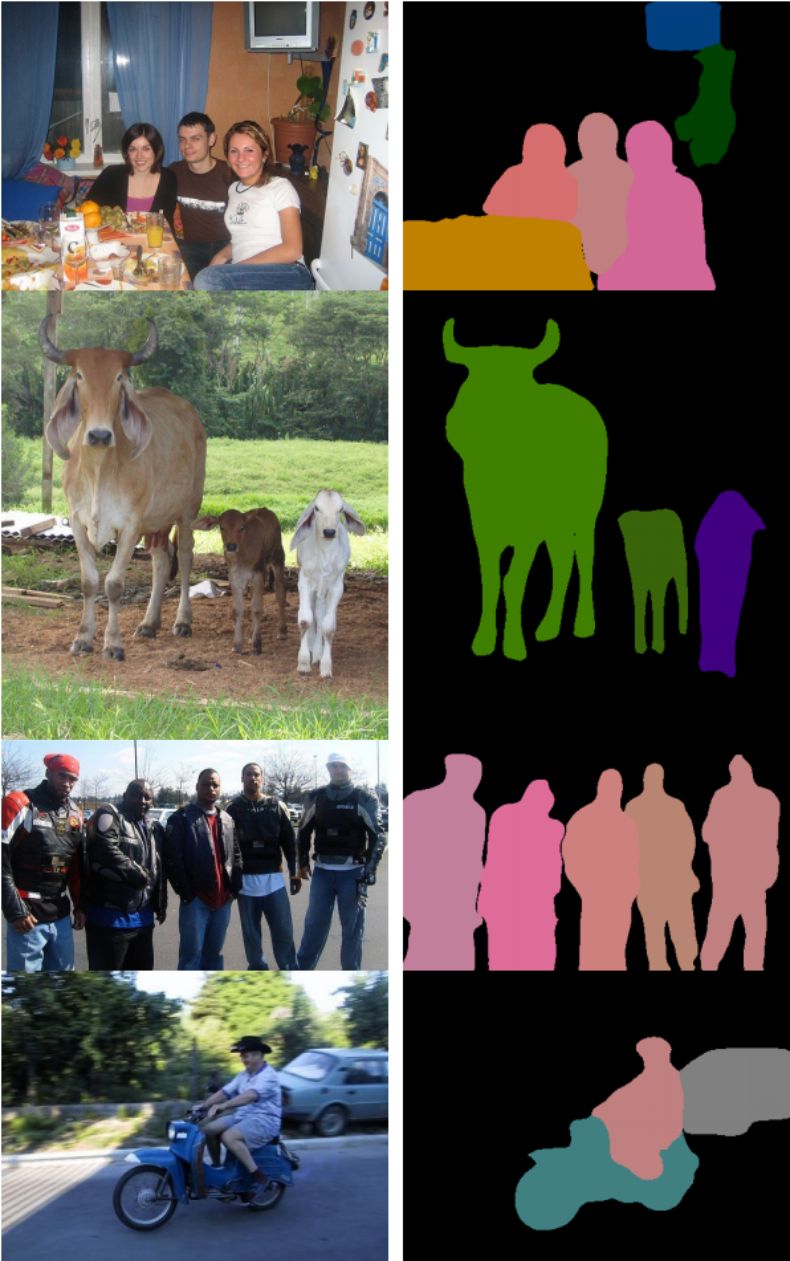

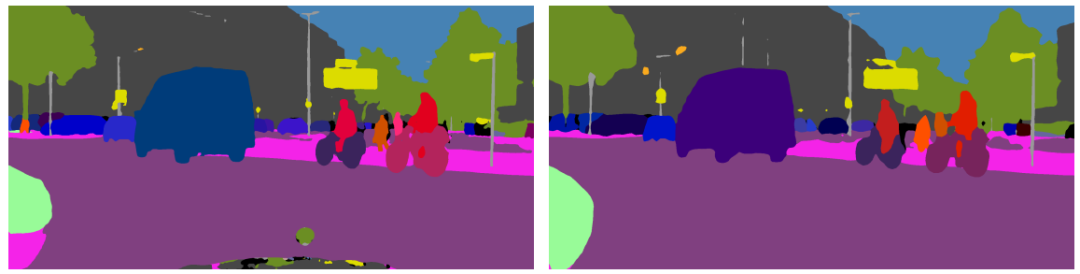

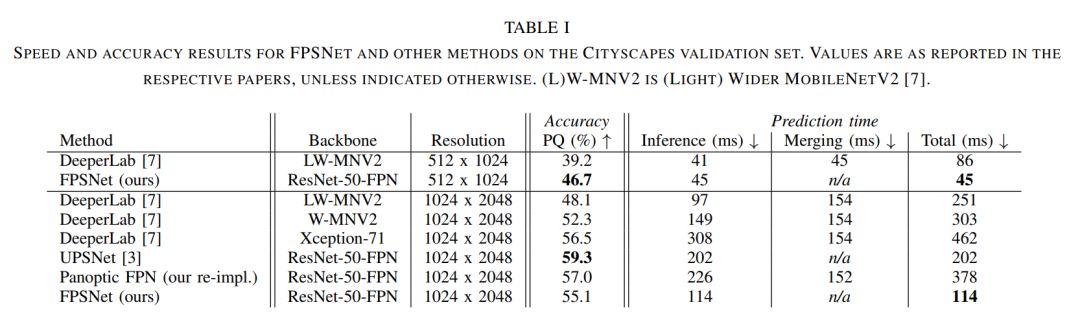

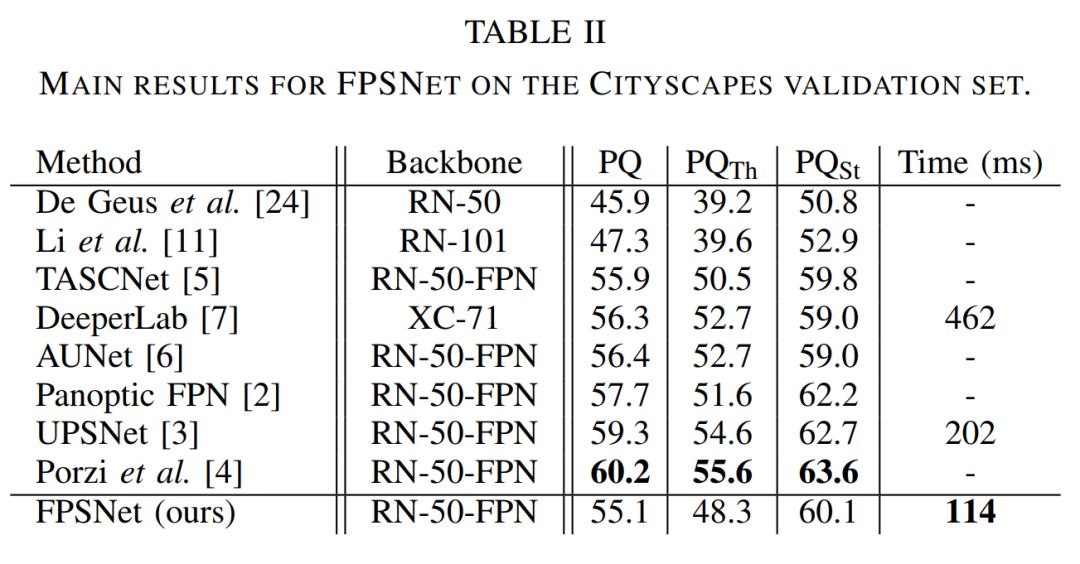

全景分割是图像分割的一个子领域,是语义分割和实例分割的结合。在这篇论文中,来自荷兰埃因霍芬理工大学的研究者提出了一种用于快速全景分割的端到端网络——FPSNet。该网络无需计算成本极高的实例掩码预测或融合启发算法,比现有的全景分割方法更快,同时分割质量也有一定的竞争力。

进行实例分割预测;

合并或拆分预测的后处理步骤。

登录查看更多

相关内容

专知会员服务

39+阅读 · 2020年3月19日

Arxiv

5+阅读 · 2018年9月6日

Arxiv

6+阅读 · 2018年7月19日

Arxiv

7+阅读 · 2018年5月25日

Arxiv

10+阅读 · 2018年3月20日