从SwinTransformer到GFlowNets,我们从2021年2万份SOTA工作中选了256个最值得关注的(附完整名录)

-

不是所有我们熟知的热门工作都有官方实现 -

不是所有我们熟知的热门工作的官方实现都可以通过GitHub找到 -

不是所有我们熟知的人们工作都有被媒体报道

-

在比较是否更具价值的过程中,不同分析师对于哪个工作对AI开发者的价值更大存在分歧 -

参与评价的分析师虽然也是AI开发者,但几个人是无法代表广大AI开发者的 -

在与不同工作进行比较的过程中,分析师对某个工作的价值度的主观感受会随着打分进程的展开产生变化,使用固定人类分析师作为判别器的会让排序算法失去稳定性

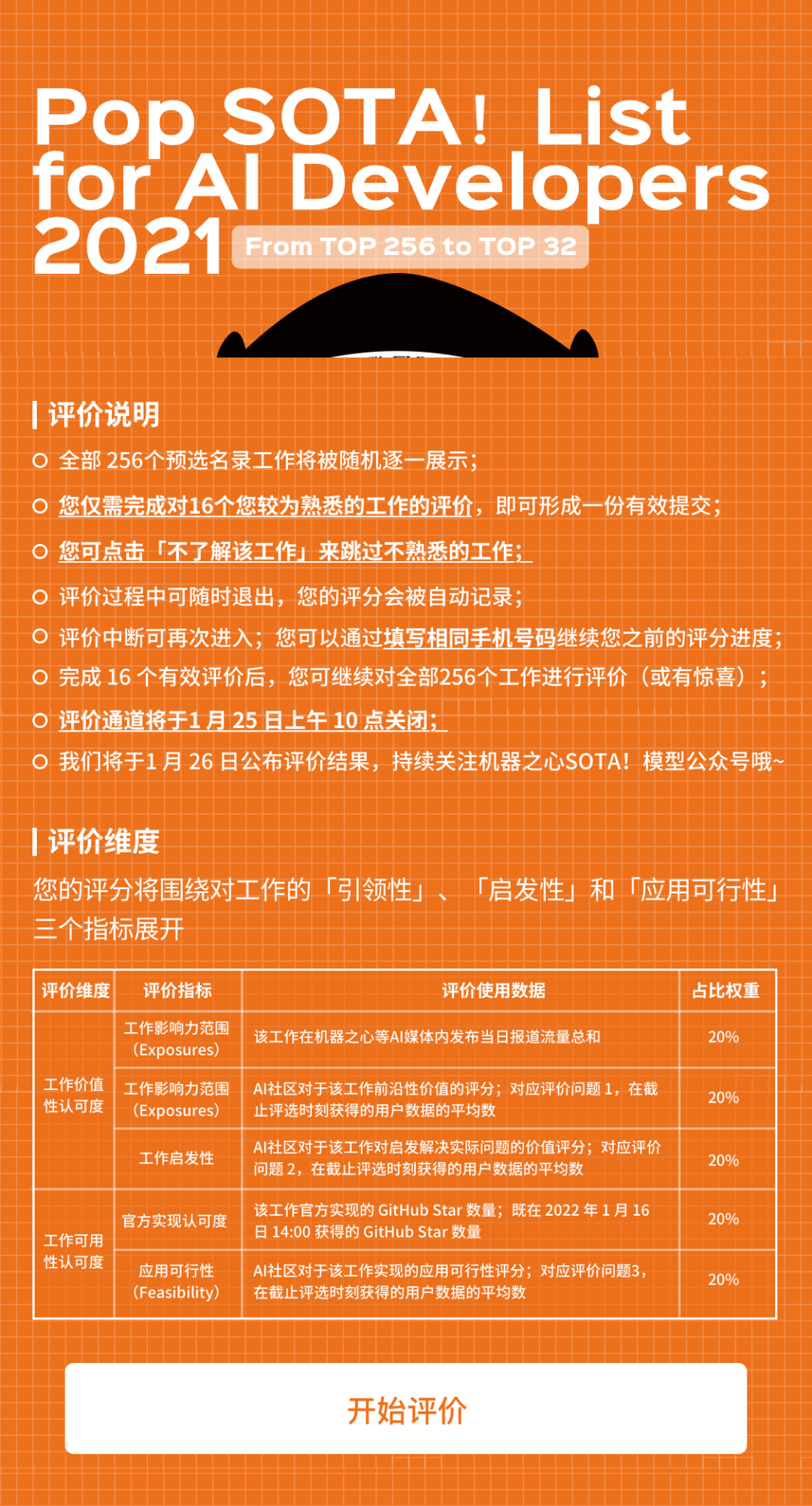

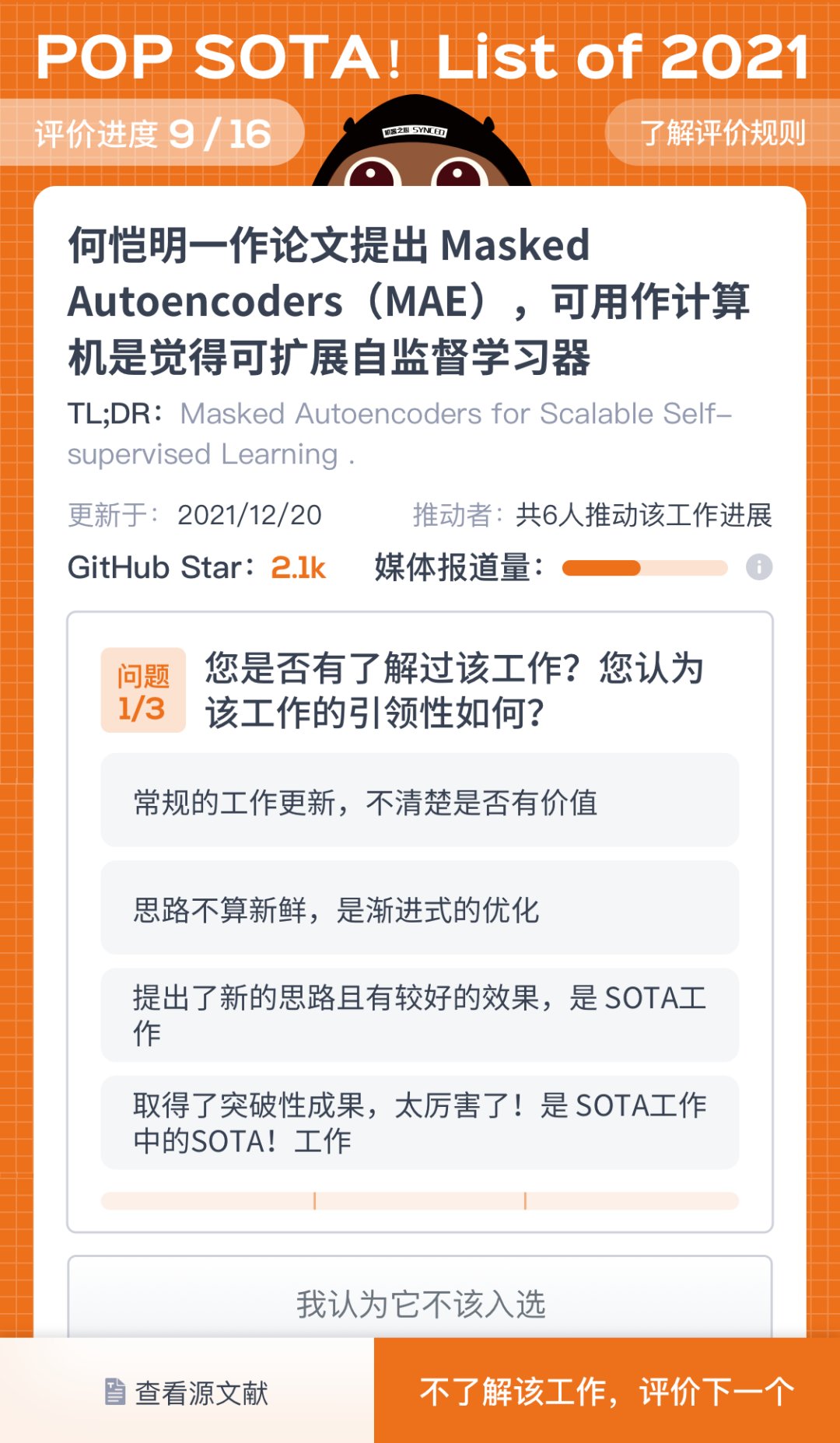

根据我们的评价计算方法,各位老伙计们只需分别完成对 16 个您较为熟悉的工作的评价~ 我们就工作的「引领性」、「启发性」和「应用可行性」三个需要 AI社区的老伙计们帮助我们进行评价的维度设计了三个问题,各位老伙计只需通过选择的形式回答以下三个问题,告诉我们您对工作的看法即可 ——

-

您是否有了解过该工作?您认为该工作的引领性如何? -

您认为该工作对您是否有帮助或者启发? -

您在实践中应用过该工作么?该工作是否好用?

Pop SOTA!List for AI Developers 2021 预选工作完整清单

注1:由于准备时间略微仓促,项目组虽进行了多次校验,但难免存在一定疏漏;若您发现有重要工作被遗漏或列表中存在错误,请点击「阅读原文」通过填写表单来告诉我们当前列表中存在的遗漏与错误。

注2:考虑到目前放出有序列表会影响大家对于技术进展价值的评判,我们将会在评价完成之后,将评价中所使用到的数据、排序工具及所有工作的排序发布到 GitHub,方便社区用户帮(gong)助(tong)改(tu)进(cao)我们不够严谨的评价过程。

注3:以下共计256个发布于2021年度的工作,覆盖新思路、新模型、新实现、新数据集及新工具五大类别。

| 微软亚洲研究院提出 Swin Transformer,在 COCO 等数据集上超越 CNN | 新模型,新实现,新思路 |

| 谷歌推出 1.6 万亿参数语言模型 Switch Transformer,预训练速度最高可达 T5 的 7 倍 | 新模型,新思路,新实现 |

| OpenAI 发布基于 GPT-3 开发的 DALL·E,可从文字说明直接生成图像 | 新模型,新实现,新思路 |

| OpenAI 发布 CLIP,支持文本图像跨模态检索,可用于查找最能代表图像的文本片段,或查找给定文本查询的最合适图像 | 新模型,新思路,新实现 |

| 谷歌研究所、MIT CSAIL 以及华盛顿大学等提出 VOGUE,可无缝地执行服装和目标人物的合并 | 新模型 |

| 微软更新 DeBERTa 模型,使得单个 DeBERTa 模型在 SuperGLUE 上宏平均得分首次超过人类 | 新模型,新实现 |

| MIT、Amazon 发现 ImageNet 等十个主流机器学习数据集的测试集平均错误率高达 3.4% | 新思路 |

| Geoffrey Hinton 发布最新论文讲解 GLOM,表达神经网络中部分-整体层次结构 | 新思路 |

| 北京智源人工智能研究院发布超大规模智能模型系统悟道 1.0 | 新模型 |

| OpenAI 发现 CLIP 模型中出现了多模态神经元 | 新思路 |

| 百度文心多项任务分数刷新 GLUE 榜单 | 新模型 |

| 阿里巴巴联合清华大学发布千亿参数规模中文多模态预训练模型 M6,可设计 30 多种物品高清图像 | 新模型 |

| 谷歌研究团队提出了ResNet-RS | 新模型,新实现 |

| 谷歌 Quoc Le 等人提出 AutoDropout,利用强化学习自动找寻模型专用 Dropout | 新模型 |

| OpenAI 科学家提出全新增强学习算法 Go-Explore,或推动 AI 向真正智能学习体进化 | 新模型 |

| 伦斯勒理工学院、MIT-IBM Watson AI Lab 的研究者进行的一项入侵果蝇大脑网络的研究中,人们成功地在生物大脑中执行了自然语言处理等任务 | 新思路 |

| 微软亚洲研究院更新多模态文档理解预训练模型 LayoutLM2.0,多项任务取得新突破 | 新模型,新实现 |

| 周志华团队开源深度森林 DF21 | 新工具 |

| 希伯来大学、特拉维夫大学、Adobe 等机构提出 StyleCLIP,融合了 StyleGAN 和 CLIP 两种模型的特性 | 新模型,新实现 |

| 智源研究院联合清华大学、阿里巴巴、搜狗等发布超大规模新型预训练模型“悟道·文汇” | 新模型 |

| 英国萨塞克斯大学用 GPU 模拟了猴子大脑视觉皮层的一个大型模型 | 新思路 |

| 南加州大学等提出 Deepfake检测器 DefakeHop | 新实现,新模型 |

| 斯坦福大学提出 GANformer,在图像质量和多样性方面取得了 SOTA 结果 | 新模型,新实现 |

| 京东开源 PyTorch 人脸识别工具包 FaceX-Zoo,覆盖最强模型 | 新工具 |

| 港科大、字节等提出神经网络新算子 involution | 新模型,新实现 |

| 微软提出 VinVL,基于更好的视觉特征,达到更强的多模态性能 | 新模型,新实现 |

| 德国海德堡大学提出语义引导生成百万像素图像的 Transformer 架构 | 新模型,新实现 |

| 微软亚洲研究院等更新代码智能领域大规模多任务基准 CodeXGLUE | 新数据集 |

| 牛津大学 ML 算法实现 10 万高压非晶硅原子的模拟 | 新思路 |

| 吴恩达团队发现在 ImageNet 上优化后的模型,在胸片分类的性能上具有显著提高 | 新思路 |

| 微软亚洲研究院发布了 NNI 2.0 版本,加入了基于掩码的模型压缩加速工具的支持等 | 新工具 |

| Yoshua Bengio 等人新论文描绘了因果对机器学习的影响,并提出了该交叉领域的核心研究方向 | 新思路 |

| 唐杰、杨植麟等提出 P-tuning,自动搜索连续空间中的 Prompt,以提高 GPT 模型的自然语言理解能力 | 新模型,新实现 |

| Facebook AI 提出首个完全基于 Transformer 的视频理解架构 TimeSformer | 新模型,新实现 |

| Mirco Ravanelli 等推出纯 PyTorch 语音工具包 SpeechBrain | 新工具 |

| 清华大学和芯翌科技发布全球最大规模人脸数据集 WebFace 260M,包含数百万 ID 和数亿图片 | 新数据集 |

| Jürgen Schmidhuber 等建立了线性(核)注意力与快速权重存储系统之间的内在联系,并提出更新规则,在合成检索问题、机器翻译、语言模型等实验上性能优越 | 新模型,新实现 |

| Quoc Le 等使用元伪标签方法将 ImageNet 的 Top-1 Accuracy 上了 90.2% | 新思路,新模型,新实现 |

| Facebook 提出 13 亿参数自监督 CV 新模型 SEER,无标注预训练实现 SOTA | 新模型 |

| EleutherAI 开源复刻版 GPT-3 GPT-Neo | 新模型,新实现 |

| 智源研究院联合清华开源首个支持 PyTorch 框架的 MoE 系统 FastMoE,相比直接使用 PyTorch 实现的版本,提速 47 倍 | 新工具 |

| 南加州大学华人博士创建了一个小工具 Rebiber,让论文引用更规范 | 新工具 |

| 微软等提出 ZeRO-Offload 技术,可在单个 GPU 上训练 130 亿参数的深度学习模型 | 新工具 |

| Facebook 提出 ResMLP,完全建立在 MLP 上 | 新模型,新思路 |

| 上海科技大学提出 Liquid Warping GAN with Attention,可在一个统一的框架内处理人体图像合成 | 新模型,新实现 |

| Facebook AI 多任务多模态的统一Transformer UniT | 新模型,新实现 |

| DeepMind 提出 NFNet,不需要规范化,训练速度提高了 8.7 倍 | 新模型,新实现 |

| 微软提出了一种基于 NeRF 的新系统 FastNeRF,运行速度是原始 NeRF 算法的 3000 倍 | 新模型 |

| 微软提出元学习框架 MC-BERT,将元控制器应用到 BERT,与原始 BERT 相比,训练速度提升了 80% | 新模型,新实现 |

| 追一科技开源首个中文 T5 模型 | 新模型,新实现 |

| 微软联合浙大提出 FastSpeech 2,在提升语音合成质量的同时,加快了合成速度 | 新模型 |

| CMU 提出自动生成论文评审结果系统 ReviewAdvisor,可自动生成论文评审结果 | 新模型,新实现 |

| 谷歌开源自动化寻找最优 ML 模型新平台 Model Search | 新工具 |

| spaCy 3.0 正式版发布,提供基于 transformer 的 Pipeline | 新工具 |

| 上海人工智能实验室提出了即插即用的共同注意力模型 SMCA,可使 DETR 收敛加速 10 倍 | 新模型,新实现 |

| 北航、UC 伯克利等提出 Informer | 新模型 |

| UNC、微软等提出 ClipBERT | 新模型 |

| 云从科技提出基于 BART 的语义纠错方法,拼写、常识、语法、推理错误都能纠正 | 新模型 |

| 剑桥大学为反例指导抽象优化方法的量化可满足性问题设计了新的 QSAT 求解器 IQ | 新模型 |

| Michael I. Jordan 等提出 POXM,用于从 XMC 任务的 Bandit Feedback 中学习 | 新模型 |

| 百度发布预训练模型 ERNIE-M 并开源模型实现 | 新模型,新实现 |

| 复旦大学自然语言处理实验室发布模型鲁棒性评测平台 TextFlint | 新工具 |

| UC 伯克利等提出新型数据集 MATH 和 AMPS 以提高语言模型数学解题能力 | 新数据集 |

| 慕尼黑大学、微软亚研的研究者提出简单 ConvNet 比CapsNet 具有更好的稳健性 | 新模型 |

| 华为诺亚实验室等提出新型视觉 Transformer 网络架构 TNT,表现优于 ViT 和 DeiT | 新模型,新实现 |

| Facebook AI 提出基于神经的反编译框架 N-Bref | 新模型,新实现 |

| Facebook 科学家 Sho Yaida 撰书从第一性原理解释深度神经网络,LeCun 表示这是首批致力于深度学习理论的书 | 新思路 |

| 谷歌大脑推出结合卷积和注意力的新模型 CoAtNet,模型具有更强的学习和泛化能力 | 新模型 |

| 谷歌大脑原 ViT 团队提出完全使用多层感知机的视觉网络架构 MLP-Mixer,可媲美 CNN、ViT | 新模型,新思路,新实现 |

| GitHub 和 OpenAI 联合发布 AI 编程辅助工具 GitHub Copilot,使用数十亿行代码进行训练 | 新思路,新工具 |

| 北京智源人工智能研究院发布悟道 2.0,参数量达 1.75 万亿 | 新模型 |

| 阿里达摩院开源深度语言模型体系 AliceMind | 新模型,新实现 |

| 阿里达摩院发布 270 亿参数中文预训练语言模型 PLUG | 新模型 |

| 谷歌最新研究发现精准优质的数据很大程度上决定了 AI 模型的性能 | 新思路 |

| 谷歌大脑推出 20 亿参数的视觉Transformer模型 ViT-G/14,刷新 ImageNet Top1 | 新模型 |

| OpenAI 提出扩散模型 ADM,在图像合成质量上超过 BigGAN,多样性还更佳 | 新模型,新实现 |

| 字节实习生提出 AgileGAN,可生成高质量风格肖像 | 新模型,新实现 |

| 华为联合鹏城实验室开源 2000 亿参数中文预训练模型盘古α | 新模型,新实现 |

| 何恺明团队针对 Transformer 在自监督学习框架中存在的训练不稳定问题,提出了一种简单而有效的技巧 Random Patch Projection | 新模型,新实现 |

| 英伟达、斯坦福和微软用 3072 块 A100 训练万亿参数 GPT | 新模型,新实现 |

| UC 伯克利马毅团队试图提供一个合理的理论框架来解释现代深度(卷积)网络 | 新思路 |

| 百度提出 PP-YOLOv2,在同等速度下,精度超越 YOLOv5 | 新实现,新模型 |

| 英伟达等提出 GANverse3D,通过一张图像创建动画3D图像 | 新模型 |

| 快手提出斗地主人工智能系统 DouZero | 新模型,新实现 |

| 微软推出 DeepDebug,使用 Transformer 进行自动 Debug | 新模型 |

| 微软亚洲研究院提出开放领域视频生成预训练模型 GODIVA,文字生成视频只需一步 | 新模型 |

| 清华悟道·文源团队发布 CPM-2 | 新模型,新实现 |

| MIT、微软推出编程挑战题库数据集,可用于教 AI 编程并评估 AI 的编程能力 | 新数据集 |

| 百度飞桨发布 2.1,包含万亿级图检索引擎推理部署导航图等 | 新工具 |

| Facebook AI 提出神经架构的快速搜索算法 FP-NAS,搜索速度更快、分类精度更高、性能更好 | 新模型 |

| 伊利诺伊大学香槟分校提出了 GANs N’ Roses,可从人像生成多样化风格的动漫形象 | 新模型,新实现 |

| 百度飞桨模型压缩工具 PaddleSlim 新增 OFA 功能,对 BERT 模型实现了近 2 倍加速,对 GAN 模型实现 33 倍体积压缩 | 新工具 |

| 上海交大、华为海思提出新算子 X-volution,首次统一卷积与自注意力 | 新模型 |

| 智源研究院发布大规模并行训练效率提升神器 TDS | 新工具 |

| Facebook AI 研究院发布无监督 wav2vec 架构 wav2vec-U | 新模型,新实现 |

| 微软推出 BEiT,首次将 BERT 应用在图像领域 | 新模型,新思路,新实现 |

| Facebook 提出图像分类架构 LeViT | 新模型,新实现 |

| Facebook 提出ConViT,兼具CNN和Transformer优势 | 新模型,新实现 |

| Facebook 提出 TextStyleBrush,可模仿用户笔迹 | 新数据集 |

| 英特尔研究人员提出图像增强新模型,可实时应用于视频游戏 | 新模型,新实现 |

| 研究人员提出 MobileStyleGAN,相较于 StyleGAN2 参数更少、计算复杂度更低 | 新模型,新实现 |

| 英伟达更新 Faster Transformer 4.0,支持 GPT-3 大规模多 GPU 多机推理 | 新工具 |

| TensorFlow 开源决策森林库 TF-DF | 新工具 |

| 微软提出自然语言生成预训练 BANG,吸收自回归与非自回归模型优势 | 新模型,新实现 |

| 百度文心 ERNIE 开源了四大预训练模型:ERNIE-Gram、ERNIE-Doc、ERNIE-ViL、ERNIE-UNIMO | 新模型,新实现 |

| David Silver、Richard Sutton 等提出将智能及其相关能力理解为促进奖励最大化 | 新思路 |

| 上海交大开源多智能体并行训练框架 MALib,支持大规模基于种群的多智能体强化学习训练 | 新工具 |

| 德国马克斯·普朗克智能系统研究所等提出 GIRAFFE,可在不影响背景或其他目标的情况下移动图像中的目标 | 新模型 |

| 香侬科技提出融合字形与拼音信息的中文预训练模型 ChineseBERT | 新模型,新实现 |

| 达特茅斯学院等提出了强化学习框架,用来缓解生成的文本中的偏见 | 新模型,新思路 |

| Quoc Le 等提出无注意力网络架构 gMLP,在图像分类等任务上媲美 Transformer 性能表现 | 新模型 |

| 谷歌等提出新的人像重照明和背景替换系统 Total Relighting,可对图像背景进行替换 | 新模型 |

| QQ 浏览器团队推出十亿级小模型摩天 | 新模型 |

| 美团提出 ConSERT,基于对比学习的文本表示模型,效果提升 8% | 新模型,新实现 |

| CMU 和谷歌等提出 LASR,可通过输入短视频生成人类或动物的 3D 模型 | 新实现,新模型 |

| 阿里达摩院提出半监督视频目标分割新算法 LCM,在 DAVIS 和 Youtube-VOS 基准实现最优性能 | 新模型 |

| 谷歌基于 Transformer 架构提出 LaMDA,可做到自由切换主题 | 新模型 |

| 谷歌基于 Transformer 架构提出 MUM,可让模型跨语言获得知识,理解文本,图像和视频等多类信息 | 新模型 |

| 微软亚洲研究院发布 NAS-BERT,可直接在上游预训练任务中进行压缩训练,使压缩模型不再依赖于下游的具体任务 | 新模型 |

| 南京大学大开源高效 Transformer ResT | 新模型,新实现 |

| 谷歌、罗格斯大学提出 NesT,超越 Swin Transformer | 新模型,新实现 |

| Google Research 提出 ALIGN,可跨模态搜索图像到文本、文本到图像等 | 新模型 |

| 字节跳动提出 GLAT(Glancing Transformer),获 WMT 2021 大语种德英自动评估第一 | 新模型,新实现 |

| 北大、字节跳动等提出超像素分割模型 LNSNet | 新模型,新实现 |

| 第四范式开源机器学习操作系统内核 OpenAIOS | 新工具 |

| DeepMind 开源 AlphaFold2,预测出 98.5% 的人类蛋白质结构 | 新思路,新模型,新实现 |

| Percy Liang、李飞飞等 100 多位研究者系统阐述了大规模预训练模型背后的机遇与风险,并统一给这些模型取名为 Foundation Model | 新思路 |

| MIT 新研究为逼近矩阵乘法任务引入了一种基于学习的算法,运行速度是精确矩阵乘积的 100 倍,是当前近似方法的 10 倍 | 新思路 |

| OpenAI 公开 GitHub Copilot 背后代码生成模型 Codex 论文 | 新模型,新数据集 |

| 谷歌团队探讨 ViT 和 CNN 之间相关的差异 | 新思路 |

| 谷歌团队探讨了当前大规模语言模型用于通用编程语言程序合成的极限 | 新思路 |

| 华盛顿大学发布 RoseTTAFold,降低算力需求 | 新模型,新实现 |

| CMU 博士刘鹏飞发表关于 Prompt Learning 综述文章 | 新思路 |

| Yann LeCun 团队提出端到端调制检测器 MDETR,能够根据原始文本查询直接检测图像中的目标 | 新模型,新实现 |

| DeepMind 发布 Perceiver 通用实现 Perceiver IO,能够处理比标准 Transformer 所能处理的大得多的输入和输出 | 新模型,新实现 |

| UC 伯克利、FAIR 和谷歌大脑提出序列建模强化学习架构 Decision Transformer,媲美甚至超越 SOTA 离线 RL 基线方法 | 新模型,新实现 |

| DeepMind 联合谷歌,用神经网络与机器学习方法来解决混合整数规划(MIP)问题 | 新模型,新实现,新思路 |

| 悟道团队综述预训练模型的过去、现在与未来 | 新思路 |

| 谷歌发布 1370 亿参数模型 FLAN,零样本性能超越小样本 | 新模型,新实现 |

| 斯坦福博士开发出全新 RNA 三维结构预测模型 ARES | 新模型 |

| 谷歌推出基于 T5 架构的预训练字节级 Transformer 模型 ByT5 | 新模型,新实现 |

| 字节实习生提出 RVM,实现 4K 60 帧视频实时抠图 | 新模型,新实现 |

| 周志华、李航、邱锡鹏、李沐、Aston Zhang 5 位专家指导,机器之心发布 ML 术语中英对照词表 | 新数据集 |

| 斯坦福大学教授李飞飞主导的 AI100 研究报告推出第二期,对过去五年来人工智能领域最重要的 14 个大问题进行了回顾和分析 | 新思路 |

| 苏黎世华人博士提出图像修复模型 SwinIR | 新模型,新实现 |

| OpenAI 开源 GPU 编程语言 Triton,将同时支持 N 卡和 A 卡 | 新工具 |

| Facebook、UIUC 开源 MaskFormer | 新模型,新实现 |

| 英特尔实验室提出 DPT 架构,用 ViT 替代卷积网络做密集预测 | 新模型,新实现 |

| 百度提出了语言与视觉一体的预训练方法 UNIMO,提供了一种新的统一模态学习范式 | 新模型,新实现 |

| GitHub 用户 7eu7d7 发布 genshin_auto_fish,可在原神里自动钓鱼 | 新工具 |

| Facebook 发布沙盒 MiniHack,内置史上最难游戏 | 新工具 |

| 华为发布异构计算架构 CANN 5.0,2.69 分钟完成 BERT 训练 | 新工具 |

| 斯坦福和 CMU 等提出 SDEdit,可从任何基于用户的输入中生成新图像 | 新模型,新实现 |

| 清华刘知远、黄民烈团队提出新框架 PPT,让超大模型调参变简单 | 新模型 |

| 微软通用语言表示模型 T-ULRv5 登顶 XTREME | 新模型 |

| Facebook 发布新的语言模型训练方式 GSLM,能够直接在原始音频信号上训练模型 | 新模型,新实现 |

| Deepmind 等机构研究人员提出 Transformer 变体∞-former,可处理任意长度上下文 | 新模型 |

| 腾讯开悟举办开悟 MOBA 多智能体强化学习大赛,以王者荣耀为游戏测试环境 | 新工具 |

| 清华大学提出 28 亿参数中文预训练对话模型 | 新模型,新实现 |

| 上海科技大学提出 SofGAN | 新模型,新实现 |

| 阿里达摩院发布万亿参数 M6-T | 新模型 |

| 微软亚洲研究院等提出网络结构搜索方法 AutoFormer,用来自动探索最优的 ViT 模型结构 | 新模型,新实现 |

| 微软提出 Focal Transformer,在分类、检测、分割任务上都验证了结构的有效性 | 新模型,新实现 |

| CMU 和 MIT 等研究人员提出 GAN Sketching,可通过草图生成图像 | 新模型,新实现 |

| MindSpore 正式推出 1.5 版本,32 块卡就能训练 2420 亿参数量的模型 | 新工具 |

| 微软、浙大等研究者提出剪枝框架 OTO,无需微调即可获得轻量级架构 | 新模型,新实现 |

| 微软推出 1350 亿参数的大规模稀疏模型 MEB | 新模型 |

| 字节跳动提出一个 143 层的残差 UNet 架构,可以完美将混合音频分离成单个源 | 新模型,新实现 |

| 百度提出跨模态文档理解模型 ERNIE-Layout,登顶 DocVQA 榜首 | 新模型 |

| 耶路撒冷希伯来大学的研究者发现,深度神经网络需要 5 至 8 层互连神经元才能表征(或达到)单个生物神经元的复杂度 | 新思路 |

| 来自 SalesForce 的研究者提出开源框架 WarpDrive,可在一个 V100 GPU 上并行运行、训练数千个强化学习环境和上千个智能体 | 新工具 |

| 清华大学提出 Fastformer | 新模型 |

| 英伟达发布端到端高性能机器人仿真平台 Isaac Gym | 新工具 |

| 一流科技正式上线 OneFlow v0.5 版 | 新工具 |

| 浪潮发布 2457 亿参数模型源 1.0 | 新模型,新实现 |

| 谷歌和 CMU 等提出极简弱监督图像-文本预训练模型 SimVLM,多模态下达 SOTA | 新模型,新思路 |

| Quoc Le 等提出 Primer,可搜索高效率 Transformer 变体 | 新模型,新实现 |

| DeepFaceLab 更新,AI 换脸效果更佳 | 新工具 |

| 百度发布 PLATO-XL,全球首个百亿参数中英文对话预训练生成模型 | 新模型,新实现 |

| 百度 ERNIE 推出 3.0,刷新 50 多个 NLP 任务基准,取得 SuperGLU 最优性能 | 新模型 |

| Jittor 团队开源医学图像智能分割模型库JMedSeg | 新工具 |

| Google 发布数据分析工具 Know Your Data | 新工具 |

| Deepmind 提出 Transformer 新变体 ∞-former:无限长期记忆,任意长度上下文 | 新模型 |

| 谷歌大脑提出全新图神经网络 GKATs,比 9 种 SOTA GNN 更强 | 新模型 |

| Mila 唐建团队发布 AI 药物研发平台 TorchDrug | 新工具 |

| 百度大脑升级至 7.0 | 新工具 |

| 何恺明一作论文提出 Masked Autoencoders(MAE),可用作计算机是觉得可扩展自监督学习器 | 新模型,新思路,新实现 |

| 微软亚洲研究院升级 Swin Transformer,新版本 SwinTransformer V2 具有 30 亿个参数,在四个具有代表性的基准上刷新纪录 | 新模型,新实现,新思路 |

| 英伟达推出升级版 StyleGAN 3,实现了真正的图像平移、旋转等不变性,大幅提高了图像合成质量 | 新模型,新实现 |

| 德国埃尔朗根-纽伦堡大学提出基于点的可微神经渲染流水线 ADOP,使用一组照片即可渲染 3D 场景 | 新模型,新实现 |

| Yoshua Bengio 一作论文提出了生成流网络 GFlowNets | 新思路,新模型 |

| FAIR 等提出能用于视频模型的自监督预训练方法 MaskFeat,MaskFeat 的 MViT-L 在 Kinetics-400 上的准确率超过 MAE,BEiT 等方法 | 新模型 |

| 英伟达更新 GauGAN 2.0,输入文字和简单的绘图就能创建逼真的图像 | 新模型 |

| OpenAI 推出 WebGPT,允许模型搜索和浏览网页更准确地回答开放式问题 | 新模型 |

| MIT 研究发现 GPT-3 和人类大脑处理语言方式相似 | 新思路 |

| 微软亚研院、北大提出多模态预训练模型 Nüwa,在 8 种包含图像和视频处理的下游视觉任务上具有出色的合成效果 | 新模型,新实现 |

| 微软提出新 CV 基础模型 Florence,打破分类、检索等多项 SOTA | 新模型 |

| MIT 韩松团队提出 MUCNetV2,极大程度上解决了 TinyDL 的内存瓶颈问题 | 新模型 |

| 港中大团队提出 CityNeRF,使用卫星图片重建洛杉矶 3D 模型 | 新模型 |

| Facebook 推出有史以来第一个赢得 WMT 的多语言模型,并击败了双语模型 | 新模型 |

| 谷歌推出 1.2 万亿参数通用稀疏语言模型GLaM,小样本学习打败 GPT-3 | 新模型 |

| 稚晖君开源自制机械臂 Dummy | 新工具 |

| 华中大、港大等提出基于数据关联方法 BYTE 的跟踪器 ByteTrack | 新模型,新实现 |

| OpenAI 推出 35亿参数文本生成图像新模型 GLIDE,媲美DALL·E | 新模型,新实现 |

| 英伟达等提出 EditGAN,实现高精度语义图像编辑 | 新模型 |

| 武大、湖北工业大学等提出 AnimeGAN,可将人像变动漫 | 新模型,新实现 |

| 三星、洛桑联邦理工学院等机构的研究者提出了 LaMa | 新模型,新实现 |

| 匿名论文提出 ConvMixer,优于 ResNet 等经典视觉模型 | 新模型,新思路,新实现 |

| 达摩院发布中文社区首个表格预训练模型 SDCUP | 新模型,新实现 |

| 谷歌发布最新看图说话模型 SimVLM,可实现零样本学习 | 新模型 |

| 谷歌提出了 TokenLearner,ViT 用上它最多可以降低 8 倍计算量,分类性能更强 | 新模型,新实现 |

| 清华大学计图团队等发表关于计算机视觉中的注意力机制的综述文章 | 新思路 |

| GitHub 用户 babysor 发布语音克隆项目 MockingBird | 新工具 |

| 哈工大讯飞联合实验室推出模型裁剪工具包 TextPruner | 新工具 |

| 微信开源超大预训练模型训练系统 PatricStar | 新工具 |

| 华盛顿、斯坦福联合提出用于开放式文本生成的比较方法 MAUVE | 新模型 |

| DeepMind 提出 2800 亿参数的 Gopher | 新模型 |

| 伊利诺伊大学厄巴纳 - 香槟分校提出漫画生成框架 JoJoGAN,可以将任意人脸进行风格化 | 新模型,新实现 |

| 天壤 XLab 团队自研蛋白质结构计算平台TRFold2,排名全球第二,算法训练仅用 8 张 RTX3090 | 新思路,新工具 |

| 微软亚洲研究院与苏州大学在 Dropout 的基础上提出了进一步的正则方法 R-Drop | 新模型,新实现 |

| 上海人工智能实验室联合商汤科技、港中大、上海交大共同发布了通用视觉模型 INTERN | 新模型 |

| UCLA 和谷歌研究院研究了不同机器学习社区中数据集使用的演变及数据集采集和创建之间的相互作用 | 新思路 |

| OpenAI 使用 60 亿参数 GPT-3 解决小学数学问题,得分成绩接近 9-12 岁学生在测试中的得分 | 新模型,新实现 |

| Facebook 提出自监督语音处理模型 XLS-R,共支持128种语言 | 新模型 |

| DeepMind 推出新语言模型 SUNDAE,在 WMT14英德互译任务获 SOTA | 新模型 |

| 微软、英伟达推出 5300 亿参数 Megatron-Turing | 新模型,新思路 |

| DeepMind 官方自称其“首次证明了人工智能可以走在纯数学研究的前沿” | 新模型 |

| 达摩院推出十万亿参数超大规模通用性人工智能大模型 M6-10T | 新模型 |

| 百度与鹏城实验室联合发布 2600 亿参数模型鹏城 - 百度 · 文心,60 多项任务得到突破 | 新模型 |

| 谷歌、OpenAI 等联合推出分层模型 Hourglass,获得 ImageNet32 SOTA | 新模型,新实现 |

| 字节跳动提出适用于视觉任务的大规模预训练方法 iBOT,刷新十几项SOTA,部分指标超 MAE | 新模型,新实现 |

| 颜水成团队提出 MetaFormer | 新模型,新实现 |

| CMU 和港中大等提出 StyleCLIPDraw | 新模型,新实现 |

| 澜舟科技-创新工场开源 10 亿参数轻量孟子模型,可用于新闻分类、文案生成 | 新模型 |

| 普林斯顿、英特尔提出 ParNet,速度和准确性显著优于 ResNet | 新模型,新实现 |

| 深势科技推出中国版 AlphaFold2:Uni-Fold,128张 GPU 训练,训练代码开源 | 新模型,新实现,新思路 |

| 颜水成团队开源 RL 环境并行模拟器 Env Pool,大幅节省 CPU 资源,速度高达百万帧/秒 | 新工具 |

| 昇思 MindSpore 发布蛋白质结构预测工具 | 新工具 |

| Facebook 等提出使用 8 位统计的优化器,在一系列任务中保持了 32 位的性能 | 新模型,新实现 |

| 阿里达摩院发布首个大规模中文多模态评测基准 MUGE,覆盖多个任务 | 新数据集 |

| 百度发布飞桨开源框架 v2.2,涵盖开发、训练、文本任务全流程和硬件适配方案 | 新工具 |

| 清华大学和字节跳动提出神经网络配音器 Neural Dubber | 新模型 |

| 斯坦福等提出 ATOM3D 数据集,用于生物分子领域的三维分子学习 | 新数据集 |

| DeepMind、普林斯顿大学等研究马尔科夫奖励的表达性来优化强化学习智能体 | 新思路 |

| 商汤、西安交通大学等提出通用感知架构 Uni-Perceiver ,可以更好地将预训练中学到的知识迁移到下游任务中 | 新模型 |

| Facebook 等提出元模型 GHN-2,可预测其他模型架构的参数 | 新模型,新实现 |

| 谷歌、Mila 等开源 rliable 库,可用于在 RL 和 ML 基准上进行可靠评估 | 新工具 |

| 清华大学提出高效 NLP 学习框架 TLM,无需进行大规模预训练 | 新模型,新实现 |

| 英伟达等提出 Binary TTC,比现有方法快 25 倍 | 新模型,新实现 |

| 浙大提出稳定连续的视频人脸参数化编辑,可调整人脸胖瘦 | 新模型 |

| 北大、UCLA 及微软联合团队证明图像补丁作为输入的单个ViT 层可模拟 CNN,需 9 头以上 | 新模型 |

| Google Brain 发布多任务模型框架 TAG,少训 2000 个小时也能 SOTA | 新模型 |

| DeepMind 提出 Transformer 变体 Enformer,提高了根据 DNA 序列预测基因表达的准确性 | 新模型,新实现 |

| 百度语音团队发布 SMLTA2,解决了 Transformer 模型用于在线语音识别任务中面临的一些问题 | 新模型 |

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月15日

Arxiv

15+阅读 · 2021年9月22日

Arxiv

15+阅读 · 2020年2月28日